Vyhodnocení a porovnání modelů

Po dokončení experimentu automatizovaného strojového učení (AutoML) si budete chtít projít modely, které byly natrénovány, a rozhodnout, který z nich je nejvhodnější.

V studio Azure Machine Learning můžete vybrat experiment AutoML a prozkoumat jeho podrobnosti.

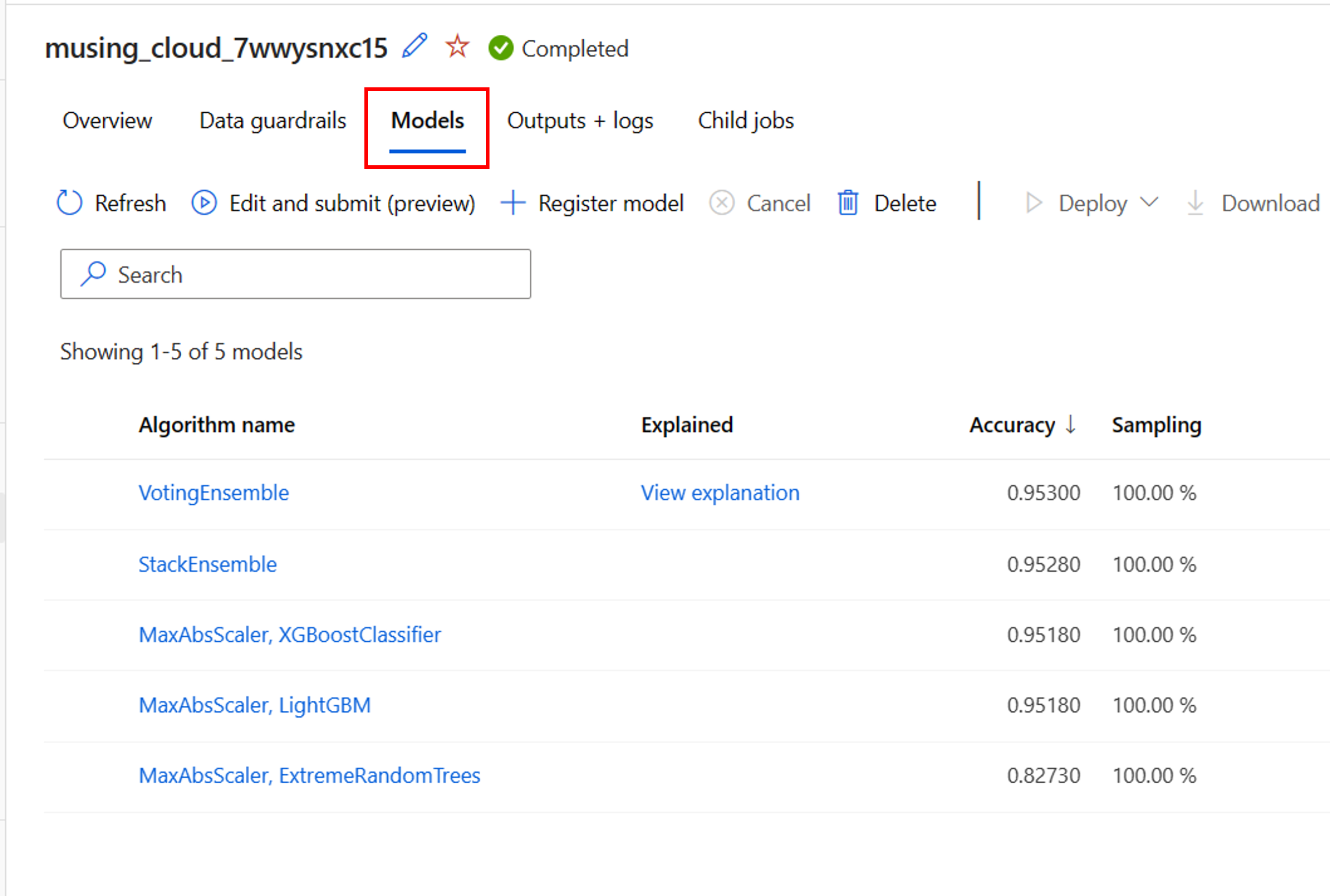

Na stránce Přehled spuštění experimentu AutoML můžete zkontrolovat vstupní datový asset a souhrn nejlepšího modelu. Pokud chcete prozkoumat všechny natrénované modely, můžete vybrat kartu Modely :

Prozkoumání kroků předběžného zpracování

Pokud jste pro experiment AutoML povolili funkci, použijí se také mantinely dat. Tři ochranné mantinely dat podporované pro klasifikační modely jsou:

- Detekce vyrovnávání tříd.

- Chybějící imputace hodnot funkcí

- Detekce funkcí s vysokou kardinalitou

Každá z těchto datových mantinely zobrazí jeden ze tří možných stavů:

- Úspěšné: Nebyly zjištěny žádné problémy a nevyžaduje se žádná akce.

- Hotovo: Změny se použily na vaše data. Měli byste zkontrolovat změny, které AutoML provedl ve vašich datech.

- Upozornění: Byl zjištěn problém, ale nebylo možné ho opravit. Měli byste zkontrolovat data a problém vyřešit.

Vedle mantinely dat může AutoML použít techniky škálování a normalizace u každého natrénovaného modelu. Techniku použitou v seznamu modelů můžete zkontrolovat v části Název algoritmu.

Například název algoritmu uvedeného modelu může být MaxAbsScaler, LightGBM. MaxAbsScaler odkazuje na techniku škálování, kdy se každá funkce škáluje maximální absolutní hodnotou. LightGBM odkazuje na klasifikační algoritmus použitý k trénování modelu.

Načtení nejlepšího běhu a jeho modelu

Při kontrole modelů v AutoML můžete snadno identifikovat nejlepší spuštění na základě zadané primární metriky. V studio Azure Machine Learning se modely automaticky seřadí tak, aby zobrazovaly model s nejlepším výkonem v horní části.

Na kartě Modely experimentu AutoML můžete sloupce upravit, pokud chcete zobrazit další metriky ve stejném přehledu. Vytvořením komplexnějšího přehledu, který zahrnuje různé metriky, může být snazší porovnat modely.

Pokud chcete model prozkoumat ještě více, můžete vygenerovat vysvětlení pro každý natrénovaný model. Při konfiguraci experimentu AutoML můžete určit, že vysvětlení by se měla vygenerovat pro model s nejlepším výkonem. Pokud vás ale zajímá interpretovatelnost jiného modelu, můžete model vybrat v přehledu a vybrat Vysvětlit model.

Poznámka:

Vysvětlení modelu je aproximace interpretovatelnosti modelu. Konkrétně vysvětlení odhadnou relativní důležitost funkcí cílové funkce (co je model natrénovaný tak, aby předpověděl). Přečtěte si další informace o interpretovatelnosti modelu.

Tip

Přečtěte si další informace o tom, jak vyhodnotit spuštění AutoML.