Použití Azure Data Lake Storage Gen1 pro požadavky na velké objemy dat

Poznámka:

Azure Data Lake Storage Gen1 je teď vyřazený. Podívejte se na oznámení o vyřazení z provozu. Prostředky Data Lake Storage Gen1 už nejsou přístupné.

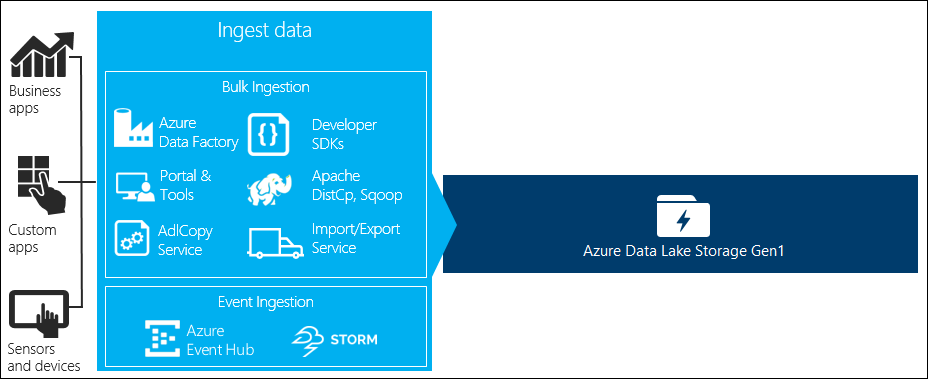

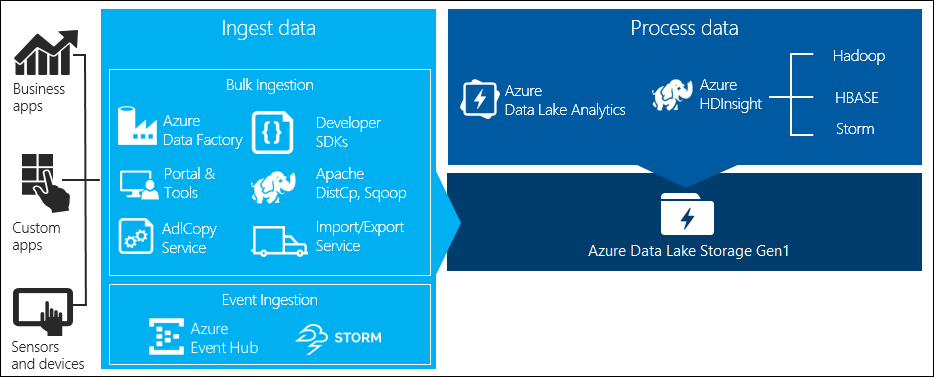

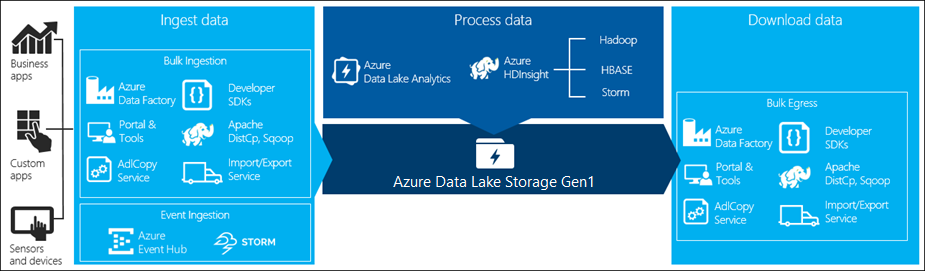

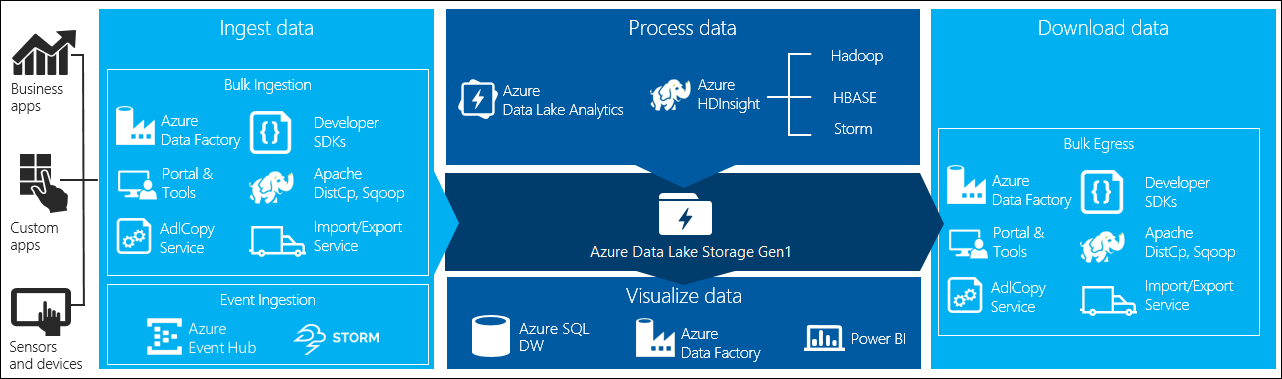

Zpracování velkých objemů dat má čtyři klíčové fáze:

- Ingestování velkých objemů dat do úložiště dat v reálném čase nebo v dávkách

- Zpracování dat

- Stažení dat

- Vizualizace dat

V tomto článku se podíváme na tyto fáze s ohledem na Azure Data Lake Storage Gen1, abychom porozuměli možnostem a nástrojům dostupným pro splnění vašich potřeb velkých objemů dat.

Ingestování dat do Data Lake Storage Gen1

V této části jsou zvýrazněné různé zdroje dat a různé způsoby, kterými je možné tato data ingestovat do účtu Data Lake Storage Gen1.

Ad hoc data

Představuje menší datové sady, které se používají k vytváření prototypů aplikace pro velké objemy dat. Existují různé způsoby příjmu ad hoc dat v závislosti na zdroji dat.

| Zdroj dat | Ingestování pomocí |

|---|---|

| Místní počítač | |

| Azure Storage Blob |

Streamovaná data

To představuje data, která mohou být generována různými zdroji, jako jsou aplikace, zařízení, senzory atd. Tato data je možné ingestovat do Data Lake Storage Gen1 různými nástroji. Tyto nástroje obvykle zachytají a zpracovávají data na základě událostí v reálném čase a pak zapisují události v dávkách do Data Lake Storage Gen1, aby je bylo možné dále zpracovat.

Následují nástroje, které můžete použít:

- Azure Stream Analytics – Události ingestované do služby Event Hubs je možné zapsat do Azure Data Lake Storage Gen1 pomocí výstupu Azure Data Lake Storage Gen1.

- EventProcessorHost – Události můžete přijímat ze služby Event Hubs a pak je zapisovat do Data Lake Storage Gen1 pomocí sady .NET SDK Data Lake Storage Gen1.

Relační data

Můžete také zdrojová data z relačních databází. V průběhu časového období relační databáze shromažďují obrovské objemy dat, které můžou poskytovat klíčové přehledy, pokud se zpracovávají prostřednictvím kanálu pro velké objemy dat. K přesunu těchto dat do Data Lake Storage Gen1 můžete použít následující nástroje.

Data protokolu webového serveru (nahrání pomocí vlastních aplikací)

Tento typ datové sady se výslovně označuje, protože analýza dat protokolu webového serveru je běžným případem použití pro aplikace pro velké objemy dat a vyžaduje, aby se velké objemy souborů protokolů nahrály do Data Lake Storage Gen1. K napsání vlastních skriptů nebo aplikací k nahrání těchto dat můžete použít kterýkoli z následujících nástrojů.

Pro nahrávání dat protokolu webového serveru a také pro nahrávání dalších druhů dat (např. dat sociálních mínění) je vhodné psát vlastní skripty nebo aplikace, protože nabízí flexibilitu zahrnout komponentu pro nahrávání dat jako součást větší aplikace pro velké objemy dat. V některých případech může mít tento kód podobu skriptu nebo jednoduchého nástroje příkazového řádku. V jiných případech může být kód použit k integraci zpracování velkých objemů dat do obchodní aplikace nebo řešení.

Data přidružená ke clusterům Azure HDInsight

Většina typů clusterů HDInsight (Hadoop, HBase, Storm) podporuje Data Lake Storage Gen1 jako úložiště dat. Clustery HDInsight přistupují k datům z objektů blob služby Azure Storage (WASB). Pokud chcete dosáhnout lepšího výkonu, můžete zkopírovat data z WASB do účtu Data Lake Storage Gen1 přidruženého ke clusteru. Ke zkopírování dat můžete použít následující nástroje.

Data uložená v místních clusterech nebo clusterech IaaS Hadoop

Velké objemy dat se můžou ukládat v existujících clusterech Hadoop místně na počítačích s HDFS. Clustery Hadoop můžou být v místním nasazení nebo v rámci clusteru IaaS v Azure. V případě jednorázového přístupu nebo opakovaného kopírování těchto dat do Azure Data Lake Storage Gen1 můžou být potřeba tyto údaje zkopírovat. Existují různé možnosti, které můžete použít k dosažení tohoto cíle. Níže je seznam alternativ a souvisejících kompromisů.

| Přístup | Detaily | Výhody | Důležité informace |

|---|---|---|---|

| Kopírování dat přímo z clusterů Hadoop do Azure Data Lake Storage Gen1 pomocí služby Azure Data Factory (ADF) | ADF podporuje HDFS jako zdroj dat. | ADF poskytuje připravenou podporu pro HDFS a prvotřídní komplexní správu a monitorování. | Vyžaduje, aby se služba Správa dat Gateway nasadila místně nebo v clusteru IaaS. |

| Exportujte data ze systému Hadoop jako soubory. Potom soubory zkopírujte do Azure Data Lake Storage Gen1 pomocí vhodného mechanismu. | Soubory můžete zkopírovat do Azure Data Lake Storage Gen1 pomocí:

|

Začněte rychle. Může provádět vlastní nahrávání | Vícekrokový proces, který zahrnuje více technologií. Řízení a monitorování bude v průběhu času výzvou vzhledem k přizpůsobené povaze nástrojů. |

| Použijte Distcp ke kopírování dat z Hadoopu do Azure Storage. Pak pomocí vhodného mechanismu zkopírujte data ze služby Azure Storage do Data Lake Storage Gen1. | Data z Azure Storage můžete zkopírovat do Data Lake Storage Gen1 pomocí: | Můžete použít opensourcové nástroje. | Vícekrokový proces, který zahrnuje více technologií |

Opravdu velké datové sady

Při nahrávání datových sad, které se nacházejí v několika terabajtech, může být použití výše popsaných metod někdy pomalé a nákladné. V takovýchpřípadechch

Pomocí Azure ExpressRoute. Azure ExpressRoute umožňuje vytvářet privátní připojení mezi datacentry Azure a infrastrukturou v místním prostředí. To poskytuje spolehlivou možnost pro přenos velkých objemů dat. Další informace najdete v dokumentaci k Azure ExpressRoute.

"Offline" nahrání dat Pokud použití Azure ExpressRoute z nějakého důvodu není možné, můžete pomocí služby Azure Import/Export dodávat pevné disky s daty do datového centra Azure. Vaše data se nejprve nahrají do objektů blob služby Azure Storage. Potom můžete pomocí nástroje Azure Data Factory nebo AdlCopy zkopírovat data z objektů blob služby Azure Storage do Data Lake Storage Gen1.

Poznámka:

Při použití služby Import/Export by velikosti souborů na discích, které odesíláte do datového centra Azure, neměly být větší než 195 GB.

Zpracování dat uložených v Data Lake Storage Gen1

Jakmile jsou data dostupná ve službě Data Lake Storage Gen1, můžete spouštět analýzu dat pomocí podporovaných aplikací pro velké objemy dat. V současné době můžete pomocí Azure HDInsight a Azure Data Lake Analytics spouštět úlohy analýzy dat na datech uložených v Data Lake Storage Gen1.

Můžete se podívat na následující příklady.

- Vytvoření clusteru HDInsight se službou Data Lake Storage Gen1 jako úložiště

- Použití Azure Data Lake Analytics se službou Data Lake Storage Gen1

Stažení dat z Data Lake Storage Gen1

Můžete také chtít stáhnout nebo přesunout data z Azure Data Lake Storage Gen1 pro scénáře, jako jsou:

- Přesuňte data do jiných úložišť do rozhraní se stávajícími kanály zpracování dat. Můžete například chtít přesunout data z Data Lake Storage Gen1 do Azure SQL Database nebo SQL Serveru.

- Stáhněte si data do místního počítače pro zpracování v prostředích IDE při vytváření prototypů aplikací.

V takových případech můžete použít některou z následujících možností:

Pomocí následujících metod můžete také napsat vlastní skript nebo aplikaci pro stahování dat z Data Lake Storage Gen1.

Vizualizace dat v Data Lake Storage Gen1

Pomocí kombinace služeb můžete vytvářet vizuální reprezentace dat uložených v Data Lake Storage Gen1.

- Můžete začít přesunem dat z Data Lake Storage Gen1 do Azure Synapse Analytics pomocí služby Azure Data Factory.

- Potom můžete integrovat Power BI se službou Azure Synapse Analytics a vytvořit vizuální znázornění dat.