Simulace rozhraní OpenAI API

Když vytváříte aplikace připojené k OpenAI, často jenom část aplikace komunikuje s rozhraním OpenAI API. Když pracujete na částech aplikace, které nevyžadují skutečné odpovědi z rozhraní OpenAI API, můžete simulovat odpovědi pomocí dev proxy serveru. Použití simulovaných odpovědí vám umožní vyhnout se zbytečným nákladům. Používá OpenAIMockResponsePlugin místní jazykový model spuštěný v Ollama k simulaci odpovědí z rozhraní OpenAI API.

Než začnete

K simulaci odpovědí rozhraní OpenAI API pomocí dev Proxy potřebujete na svém počítači nainstalovaný Ollama. Pokud chcete nainstalovat Ollama, postupujte podle pokynů v dokumentaci k Ollama.

Dev Proxy ve výchozím nastavení používá jazykový model phi-3. Pokud chcete použít jiný model, aktualizujte model vlastnost v konfiguračním souboru dev proxy.

Konfigurace dev proxy serveru pro simulaci odpovědí rozhraní OpenAI API

Tip

Kroky popsané v tomto kurzu jsou k dispozici v přednastavení pro vývojový proxy server připravený k použití. Pokud chcete použít předvolbu, spusťte devproxy preset get simulate-openaina příkazovém řádku a postupujte podle pokynů.

Pokud chcete simulovat odpovědi rozhraní OPENAI API pomocí dev proxy serveru, musíte v devproxyrc.json souboru povolitOpenAIMockResponsePlugin.

{

"$schema": "https://raw.githubusercontent.com/dotnet/dev-proxy/main/schemas/v0.24.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/dev-proxy-plugins.dll"

}

]

}

Dále nakonfigurujte Dev Proxy tak, aby zachycovali požadavky na rozhraní OpenAI API. OpenAI doporučuje používat https://api.openai.com/v1/chat/completions koncový bod, který vám umožní využívat nejnovější modely a funkce.

{

// [...] trimmed for brevity

"urlsToWatch": [

"https://api.openai.com/v1/chat/completions"

]

}

Nakonec nakonfigurujte Dev Proxy tak, aby používal místní jazykový model.

{

// [...] trimmed for brevity

"languageModel": {

"enabled": true

}

}

Úplný konfigurační soubor vypadá takto.

{

"$schema": "https://raw.githubusercontent.com/dotnet/dev-proxy/main/schemas/v0.24.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/dev-proxy-plugins.dll"

}

],

"urlsToWatch": [

"https://api.openai.com/v1/chat/completions"

],

"languageModel": {

"enabled": true

}

}

Simulace odpovědí rozhraní API OpenAI

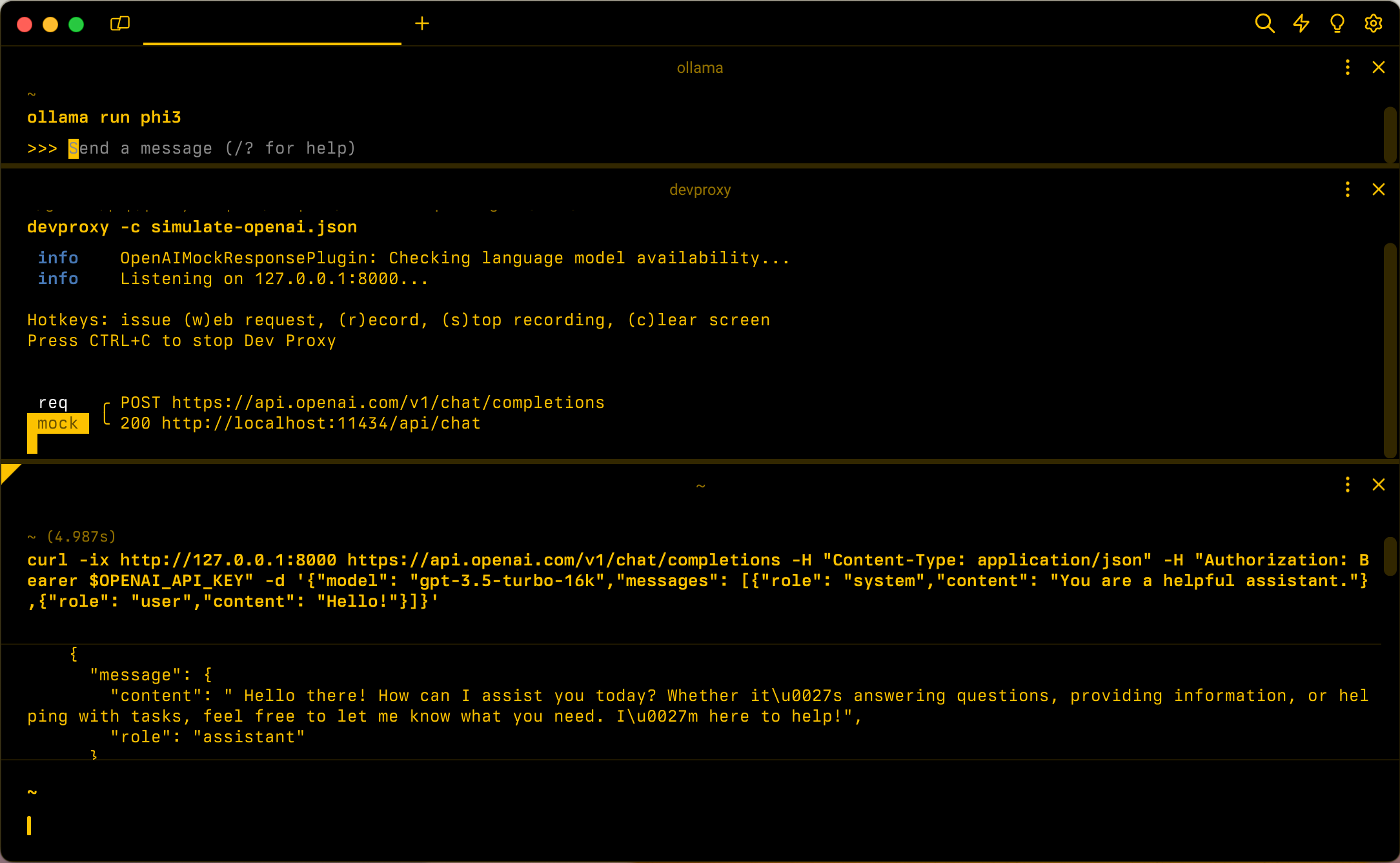

Začněte Ollama s jazykovým modelem phi-3. Na příkazovém řádku spusťte ollama run phi3příkaz .

Potom spusťte Dev Proxy. Pokud použijete předvolbu, spusťte devproxy -c "~appFolder/presets/simulate-openai/simulate-openai.jsonpříkaz . Pokud používáte vlastní konfigurační soubor s názvem devproxyrc.json, uložený v aktuálním pracovním adresáři, spusťte devproxypříkaz . Dev Proxy zkontroluje, jestli má přístup k jazykovému modelu Ollama, a potvrdí, že je připravený simulovat odpovědi rozhraní OpenAI API.

info OpenAIMockResponsePlugin: Checking language model availability...

info Listening on 127.0.0.1:8000...

Hotkeys: issue (w)eb request, (r)ecord, (s)top recording, (c)lear screen

Press CTRL+C to stop Dev Proxy

Spusťte aplikaci a proveďte požadavky na rozhraní OpenAI API. Dev Proxy zachytí požadavky a simuluje odpovědi pomocí místního jazykového modelu.

Další krok

Přečtěte si další informace o OpenAIMockResponsePlugin.

Ukázky

Projděte si také související ukázky dev proxy serveru: