Možnosti pro načtení dat do Fabric Lakehouse

Prostředí pro získání dat se zabývá všemi uživatelskými scénáři pro přenos dat do jezera, například:

- Připojení k existujícímu SQL Serveru a kopírování dat do tabulky Delta na jezeře

- Nahrání souborů z počítače

- Kopírování a slučování více tabulek z jiných jezer do nové tabulky Delta.

- Připojení ke zdroji streamování za účelem vytvoření dat v jezeře.

- Odkazování na data bez kopírování z jiných interních jezer nebo externích zdrojů

Různé způsoby načtení dat do jezera

V Microsoft Fabric existuje několik způsobů, jak získat data do jezera:

- Nahrání souboru z místního počítače

- Spuštění nástroje pro kopírování v kanálech

- Nastavení toku dat

- Knihovny Apache Sparku v kódu poznámkového bloku

- Streamování událostí v reálném čase pomocí eventstreamu

- Získání dat z Eventhouse

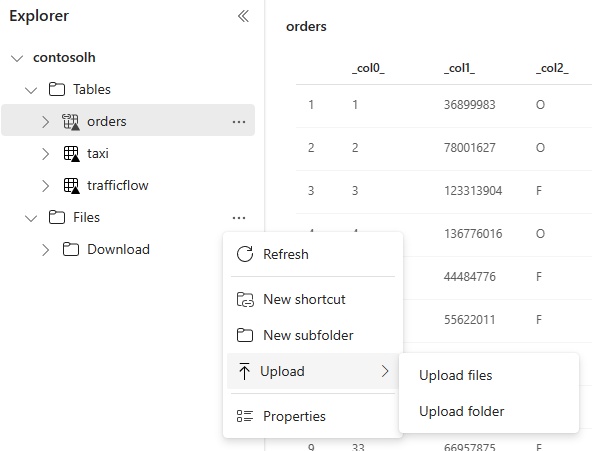

Nahrání místního souboru

Můžete také nahrát data uložená na místním počítači. Můžete to udělat přímo v Průzkumníku Lakehouse.

Nástroj pro kopírování v kanálech

Nástroj Kopírování je vysoce škálovatelné Integrace Dat řešení, které umožňuje připojit se k různým zdrojům dat a načíst data v původním formátu nebo je převést na tabulku Delta. Nástroj pro kopírování je součástí aktivit kanálu, které můžete upravovat několika způsoby, jako je plánování nebo aktivace na základě události. Další informace naleznete v tématu Kopírování dat pomocí aktivity kopírování.

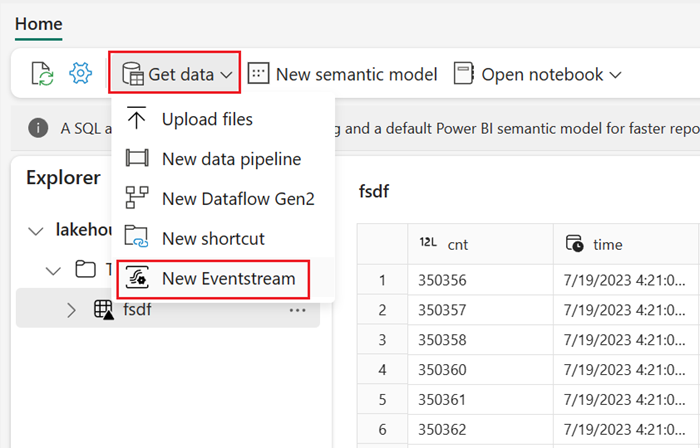

Datové toky

Pro uživatele, kteří jsou obeznámeni s toky dat Power BI, je stejný nástroj dostupný k načtení dat do jezera. Můžete k němu rychle přistupovat z možnosti Získat data v Průzkumníku Lakehouse a načíst data z více než 200 konektorů. Další informace najdete v tématu Rychlý start: Vytvoření prvního toku dat pro získání a transformaci dat.

Kód poznámkového bloku

Pomocí dostupných knihoven Sparku se můžete připojit ke zdroji dat přímo, načíst data do datového rámce a pak je uložit do jezera. Tato metoda je nejotevřenější způsob, jak načíst data v jezeře, kterou uživatelský kód plně spravuje.

Poznámka:

Externí tabulky Delta vytvořené pomocí kódu Sparku nebudou viditelné pro koncový bod analýzy SQL. Pomocí klávesových zkratek v prostoru tabulky můžete zpřístupnit externí tabulky Delta pro koncový bod analýzy SQL. Informace o tom, jak vytvořit zkratku, najdete v části Vytvoření zkratky pro soubory nebo tabulky.

Streamování událostí v reálném čase pomocí eventstreamu

Pomocí eventstreamu můžete získat, zpracovávat a směrovat velké objemy událostí v reálném čase z široké škály zdrojů.

Pokud chcete zjistit, jak přidat lakehouse jako cíl pro Eventstream, přečtěte si téma Získání dat z eventstreamu v lakehouse.

Pokud chcete dosáhnout optimálního výkonu streamování, můžete streamovat data z eventstreamu do eventhouse a pak povolit dostupnost OneLake.

Získání dat z Eventhouse

Když povolíte dostupnost OneLake u dat v Eventhouse, vytvoří se v OneLake tabulka Delta. K této tabulce Delta může přistupovat lakehouse pomocí zástupce. Další informace najdete v tématu Klávesové zkratky OneLake. Další informace najdete v tématu Dostupnost Eventhouse OneLake.

Důležité informace při výběru přístupu k načtení dat

| Případ použití | Doporučení |

|---|---|

| Nahrání malého souboru z místního počítače | Použití místního nahrání souboru |

| Malá data nebo konkrétní konektor | Použití toků dat |

| Velký zdroj dat | Použití nástroje Kopírování v kanálech |

| Komplexní transformace dat | Použití kódu poznámkového bloku |

| Streamování dat | Použití eventstreamu k streamování dat do Eventhouse; povolení dostupnosti OneLake a vytvoření zástupce z Lakehouse |

| Data časových řad | Získání dat z Eventhouse |