Přehled virtuálních počítačů řady HBv4

Platí pro: ✔️ Virtuální počítače s Windows s Linuxem ✔️ ✔️ – Flexibilní škálovací sady Uniform Scale Sets ✔️

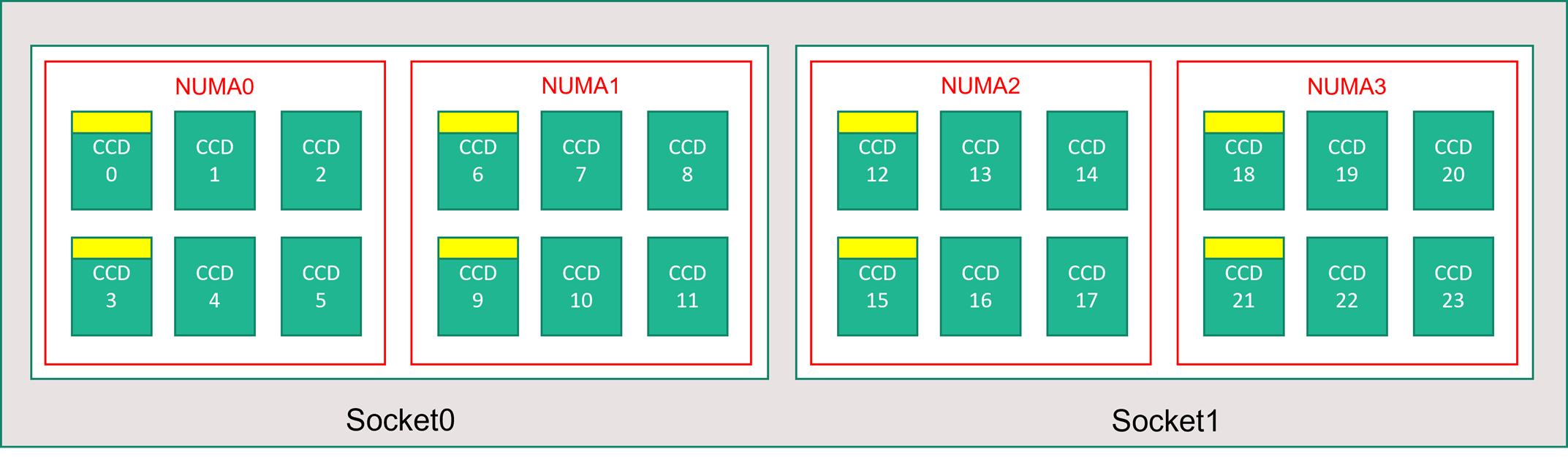

Server řady HBv4 obsahuje 2 * 96jádrový procesor EPYC 9V33X pro celkem 192 fyzických jader Zen4 s AMD 3D-V Cache. Souběžné multithreading (SMT) je v HBv4 zakázané. Tyto 192 jader jsou rozděleny do 24 oddílů (12 na soket), každý oddíl obsahuje 8 jader procesoru s jednotným přístupem k mezipaměti L3 96 MB. Servery Azure HBv4 také spouštějí následující nastavení SYSTÉMU AMD BIOS:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

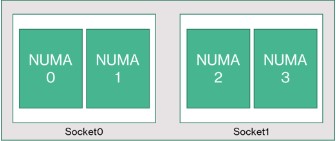

V důsledku toho se server spouští se 4 doménami NUMA (2 na soket) každé velikosti 48 jader. Každá technologie NUMA má přímý přístup k 6 kanálům fyzického DRAM.

Abychom zajistili prostor pro provoz hypervisoru Azure bez narušení virtuálního počítače, vyhrazujeme si 16 fyzických jader na server.

Topologie virtuálních počítačů

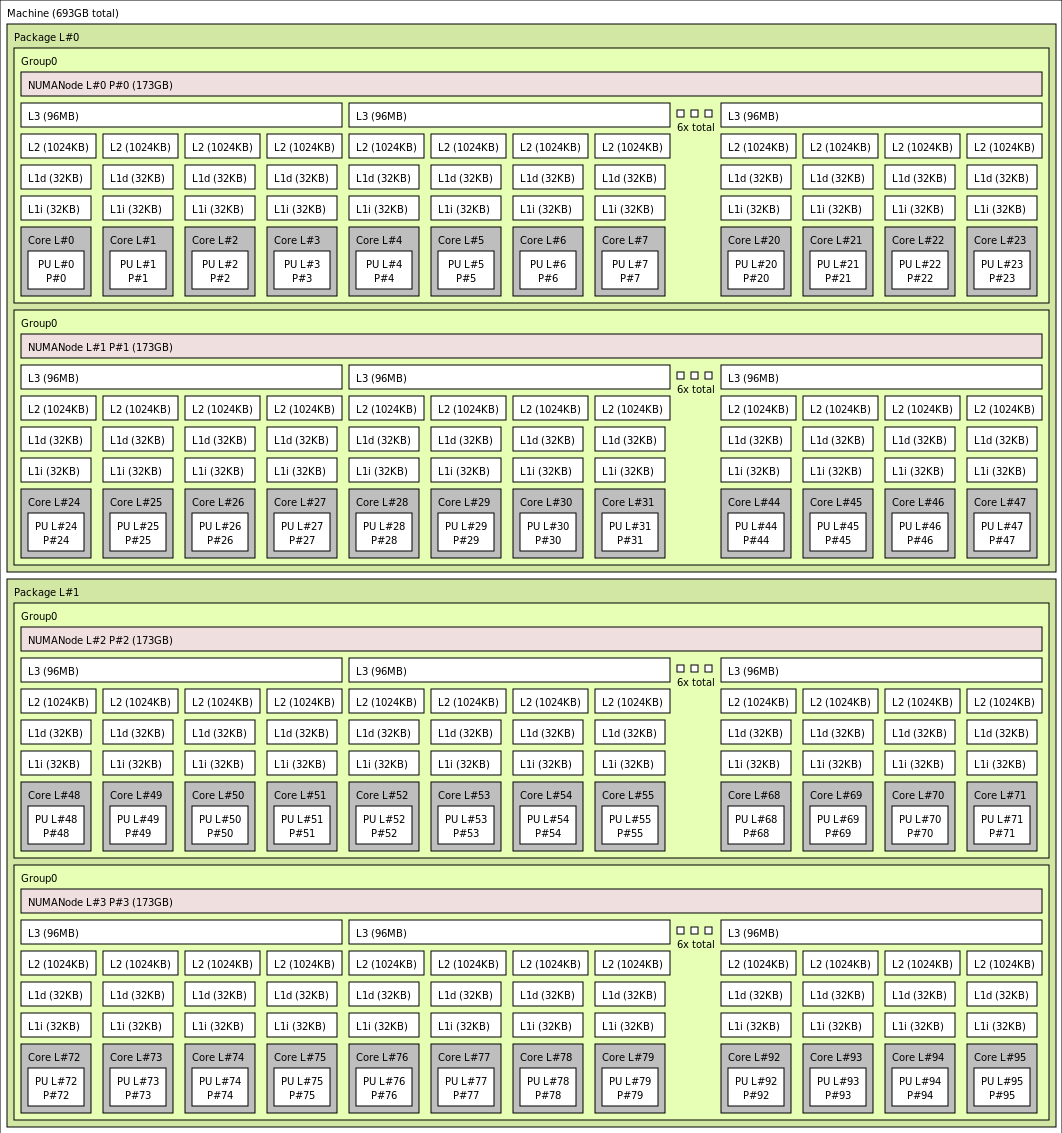

Následující diagram znázorňuje topologii serveru. Tyto 16 jader hostitele hypervisoru (žluté) si vyhrazujeme symetricky napříč oběma sokety procesoru, přičemž v každé doméně NUMA se zbývající jádra pro virtuální počítač řady HBv4 (zelená) zachovají prvních 2 jader z konkrétních komplexních dies (CCD).

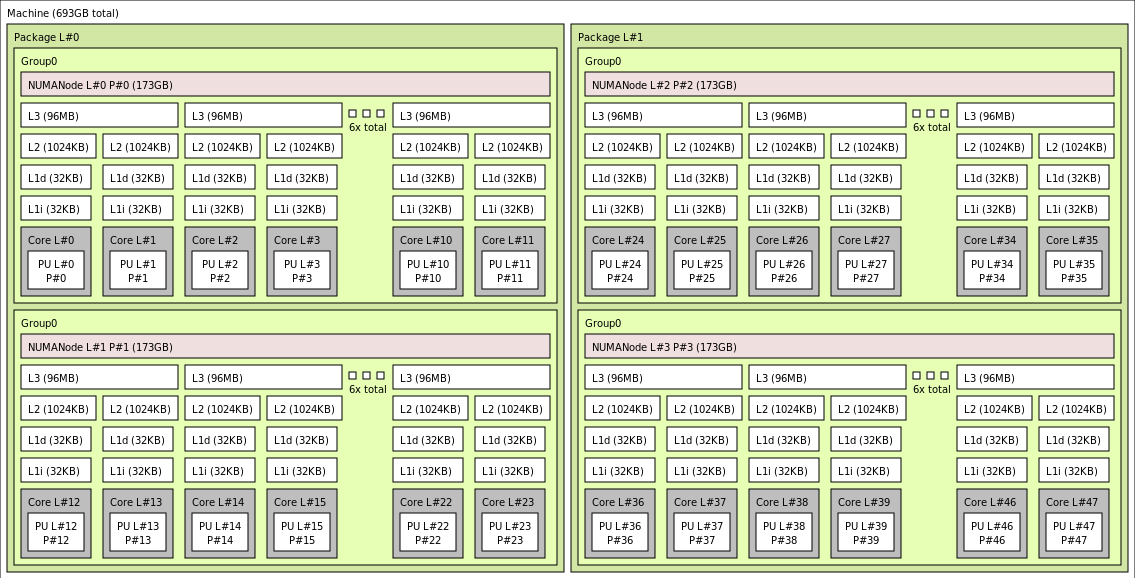

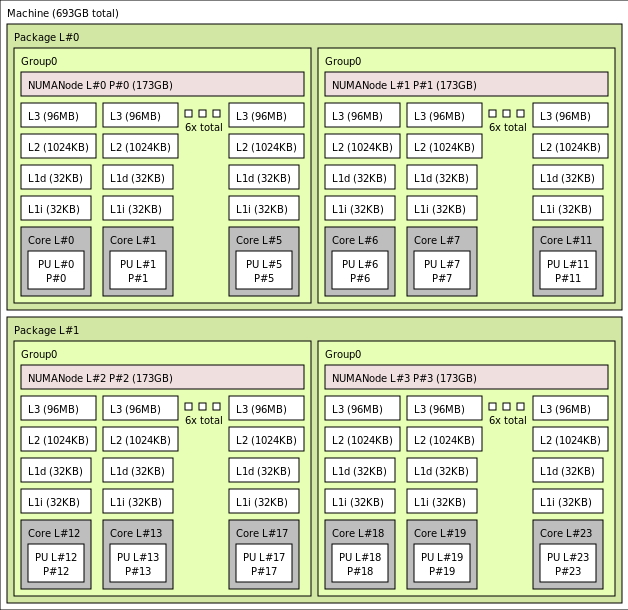

Hranice CCD se liší od hranice NUMA. V HBv4 je skupina šesti (6) po sobě jdoucích disků CCD nakonfigurovaná jako doména NUMA, a to jak na úrovni hostitelského serveru, tak v rámci hostovaného virtuálního počítače. Všechny velikosti virtuálních počítačů HBv4 proto zpřístupňují 4 jednotné domény NUMA, které se zobrazují operačnímu systému a aplikaci, jak je znázorněno níže, přičemž každý má jiný počet jader v závislosti na konkrétní velikosti virtuálního počítače HBv4.

Každá velikost virtuálního počítače HBv4 je podobná fyzickému rozložení, funkcím a výkonu jiného procesoru než AMD EPYC 9V33X následujícím způsobem:

| Velikost virtuálního počítače řady HBv4 | Domény NUMA | Jádra na doménu NUMA | Podobnost s AMD EPYC |

|---|---|---|---|

| Standard_HB176rs_v4 | 4 | 44 | Duální zásuvka EPYC 9V33X |

| Standard_HB176 144rs_v4 | 4 | 36 | Duální zásuvka EPYC 9V33X |

| Standard_HB176 96rs_v4 | 4 | 24 | Duální zásuvka EPYC 9V33X |

| Standard_HB176-48rs_v4 | 4 | 12 | Duální zásuvka EPYC 9V33X |

| 24rs_v4 Standard_HB176 | 4 | 6 | Duální zásuvka EPYC 9V33X |

Poznámka:

Velikosti virtuálních počítačů s omezenými jádry snižují jenom počet fyzických jader vystavených virtuálnímu počítači. Všechny globální sdílené prostředky (RAM, šířka pásma paměti, mezipaměť L3, připojení GMI a xGMI, InfiniBand, síť Azure Ethernet, místní SSD) zůstávají konstantní. To umožňuje zákazníkovi vybrat velikost virtuálního počítače, která je nejlépe přizpůsobená dané sadě úloh nebo požadavků na licencování softwaru.

Virtuální mapování NUMA každé velikosti virtuálního počítače HBv4 se mapuje na základní fyzickou topologii NUMA. Neexistuje žádná zavádějící abstrakce hardwarové topologie.

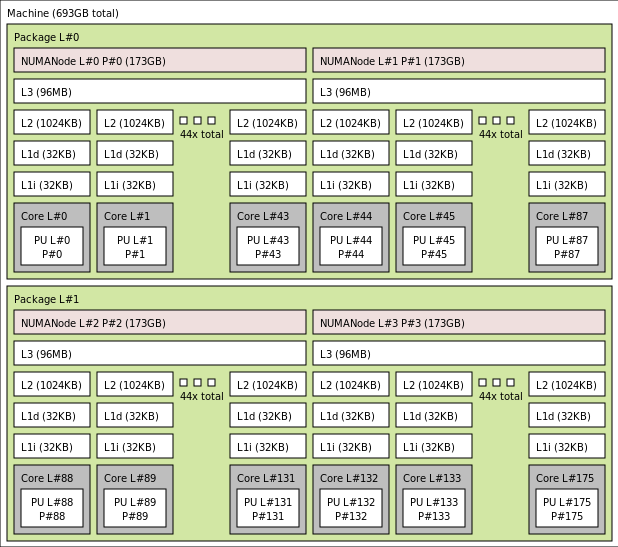

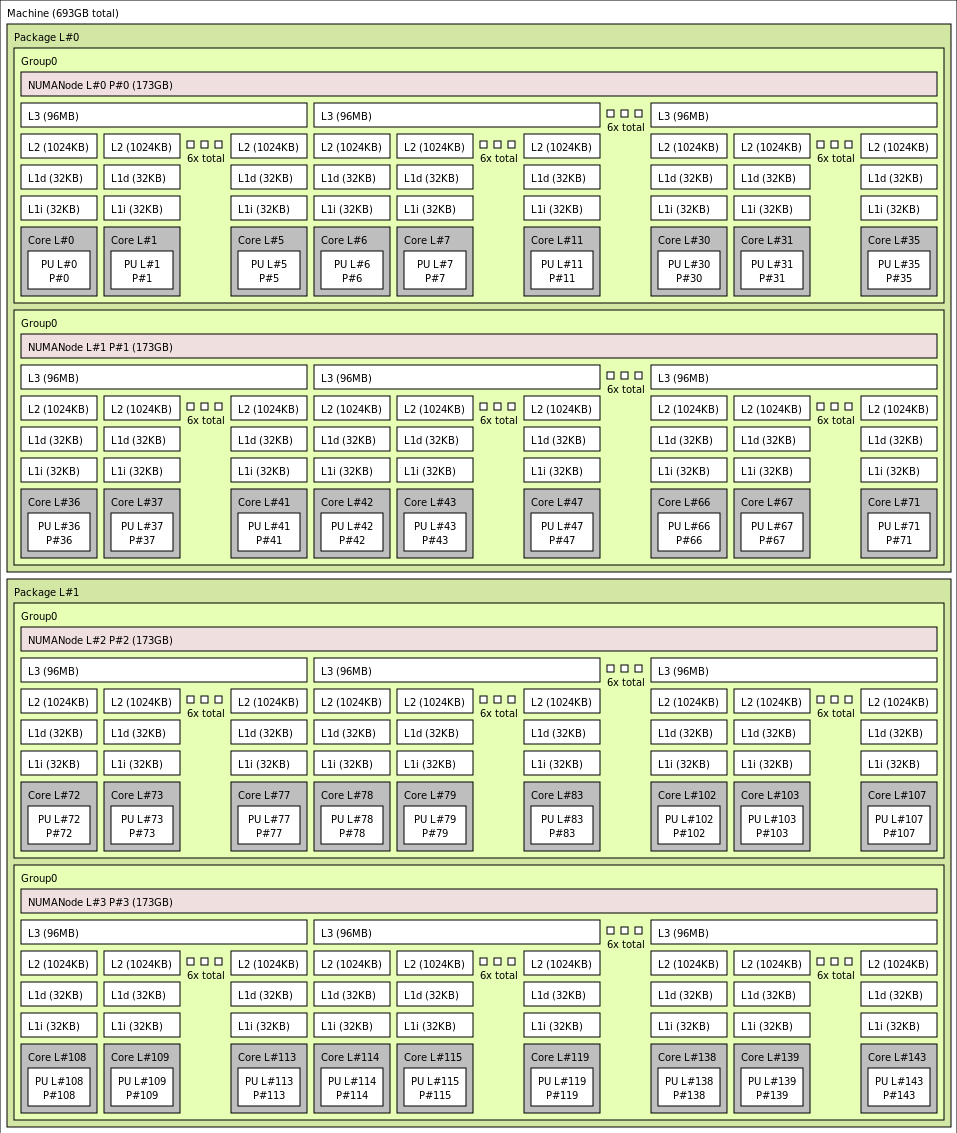

Přesná topologie pro různé velikosti virtuálního počítače HBv4 se zobrazí následujícím způsobem pomocí výstupu lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Kliknutím zobrazíte výstup lstopo pro Standard_HB176rs_v4

Kliknutím zobrazíte výstup lstopo pro Standard_HB176-144rs_v4

Kliknutím zobrazíte výstup lstopo pro Standard_HB176-96rs_v4

Kliknutím zobrazíte výstup lstopo pro Standard_HB176-48rs_v4

Kliknutím zobrazíte výstup lstopo pro Standard_HB176-24rs_v4

Sítě InfiniBand

Virtuální počítače HBv4 také obsahují síťové adaptéry NVIDIA Mellanox InfiniBand (ConnectX-7), které fungují až na 400 gigabitů za sekundu. Síťová karta se předává virtuálnímu počítači přes SRIOV a umožňuje síťový provoz obejít hypervisor. V důsledku toho zákazníci načítají standardní ovladače Mellanox OFED na virtuální počítače HBv4, stejně jako holé prostředí.

Virtuální počítače HBv4 podporují adaptivní směrování, dynamickou připojenou dopravu (DCT, kromě standardních přenosů RC a UD) a hardwarové snižování zátěže mpI na procesor onboarding adaptéru ConnectX-7. Tyto funkce zvyšují výkon, škálovatelnost a konzistenci aplikací a doporučuje se jejich používání.

Dočasné úložiště

Virtuální počítače HBv4 obsahují 3 fyzicky místní zařízení SSD. Jedno zařízení je předem naformátované tak, aby sloužilo jako stránkový soubor a zobrazilo se ve vašem virtuálním počítači jako obecné zařízení SSD.

Dvě další, větší disky SSD jsou poskytovány jako neformátovaná bloková zařízení NVMe přes NVMeDirect. Vzhledem k tomu, že blokové zařízení NVMe obchází hypervisor, má větší šířku pásma, vyšší IOPS a nižší latenci na IOP.

Při spárování v pruhovaném poli poskytuje SSD NVMe až 12 GB/s čtení a 7 GB/s zápisů a až 186 000 IOPS (čtení) a 201 000 IOPS (zápisy) pro hloubkové hloubky fronty.

Specifikace hardwaru

| Specifikace hardwaru | Virtuální počítače řady HBv4 |

|---|---|

| Cores | 176, 144, 96, 48 nebo 24 (SMT zakázáno) |

| Procesor | AMD EPYC 9V33X |

| Frekvence procesoru (bez AVX) | Základna 2,4 GHz, maximální zvýšení 3,7 GHz |

| Memory (Paměť) | 768 GB (paměť RAM na jádro závisí na velikosti virtuálního počítače) |

| Místní disk | 2 * 1,8 TB NVMe (blok), 480 GB SSD (stránkový soubor) |

| InfiniBand | 400 Gb/s Mellanox ConnectX-7 NDR InfiniBand |

| Síť | 80 Gb/s Ethernet (40 Gb/s využitelné) Azure second Gen SmartNIC |

Specifikace softwaru

| Specifikace softwaru | Virtuální počítače řady HBv4 |

|---|---|

| Maximální velikost úlohy MPI | 52 800 jader (300 virtuálních počítačů ve škálovací sadě virtuálních počítačů s jednou placementGroup=true) |

| Podpora MPI | HPC-X (2.13 nebo vyšší), Intel MPI (2021.7.0 nebo vyšší), OpenMPI (4.1.3 nebo vyšší), MVAPICH2 (2.3.7 nebo vyšší), MPICH (4.1 nebo vyšší) |

| Další architektury | UCX, libfabric, PGAS nebo jiné moduly runtime založené na infiniBand |

| Podpora služby Azure Storage | Disky Úrovně Standard a Premium (maximálně 32 disků), Azure NetApp Files, Azure Files, Azure HPC Cache, Spravovaný systém souborů Lustre Azure |

| Podporovaný a ověřený operační systém | AlmaLinux 8.6, 8.7, Ubuntu 20.04+ |

| Doporučený operační systém pro výkon | AlmaLinux HPC 8.7, Ubuntu-HPC 20.04+ |

| Podpora orchestratoru | Azure CycleCloud, Azure Batch, AKS; Možnosti konfigurace clusteru |

Poznámka:

- Tyto virtuální počítače podporují pouze generaci 2.

- Oficiální podpora na úrovni jádra od AMD začíná na RHEL 8.6 a AlmaLinux 8.6, což je derivát RHEL.

- Windows Server 2012 R2 není podporován na HBv4 a jiných virtuálních počítačích s více než 64 (virtuálními nebo fyzickými) jádry. Další informace naleznete v tématu Podporované hostované operační systémy Windows pro Hyper-V na Windows Serveru. Windows Server 2022 se vyžaduje pro velikosti 144 a 176 jader, Windows Server 2016 také funguje pro 24, 48 a 96 velikostí jader, Windows Server funguje jenom pro 24 a 48 velikostí jader.

Důležité

Doporučený obrázek URN: almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101, pokud chcete tuto image nasadit přes Azure CLI, ujistěte se, že jsou zahrnuté následující parametry --plan 8_7-hpc-gen2 --product almalinux-hpc --publisher almalinux. Pro testy škálování použijte doporučenou URN spolu s novou tarballovou verzí PROSTŘEDÍ HPC-X.

Poznámka:

- Podpora oznámení o nedoručení je přidaná v UCX 1.13 nebo novějším. Starší verze UCX hlásí výše uvedenou chybu modulu runtime. Chyba UCX: Neplatná aktivní rychlost

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128. - Ibstat ukazuje nízkou rychlost (SDR): Starší verze Mellanox OFED (MOFED) nepodporují oznámení o nedoručení a může hlásit pomalejší rychlosti IB. Použijte MOFED verze MOFED 5.6-1.0.3.3 nebo vyšší.

Další kroky

- Přečtěte si o nejnovějších oznámeních, příkladech úloh PROSTŘEDÍ HPC a výsledcích výkonu na blogech technické komunity Azure Compute.

- Přehled architektury vyšší úrovně spouštění úloh PROSTŘEDÍ HPC najdete v tématu Vysokovýkonné výpočetní prostředí (HPC) v Azure.