Balíčky pracovních prostorů

Balíčky pracovních prostorů můžou být vlastní nebo soukromé kolo (Python), jar (Scala/Java) nebo soubory tar.gz (R). Tyto balíčky můžete nahrát do pracovního prostoru a později je přiřadit ke konkrétnímu fondu Sparku.

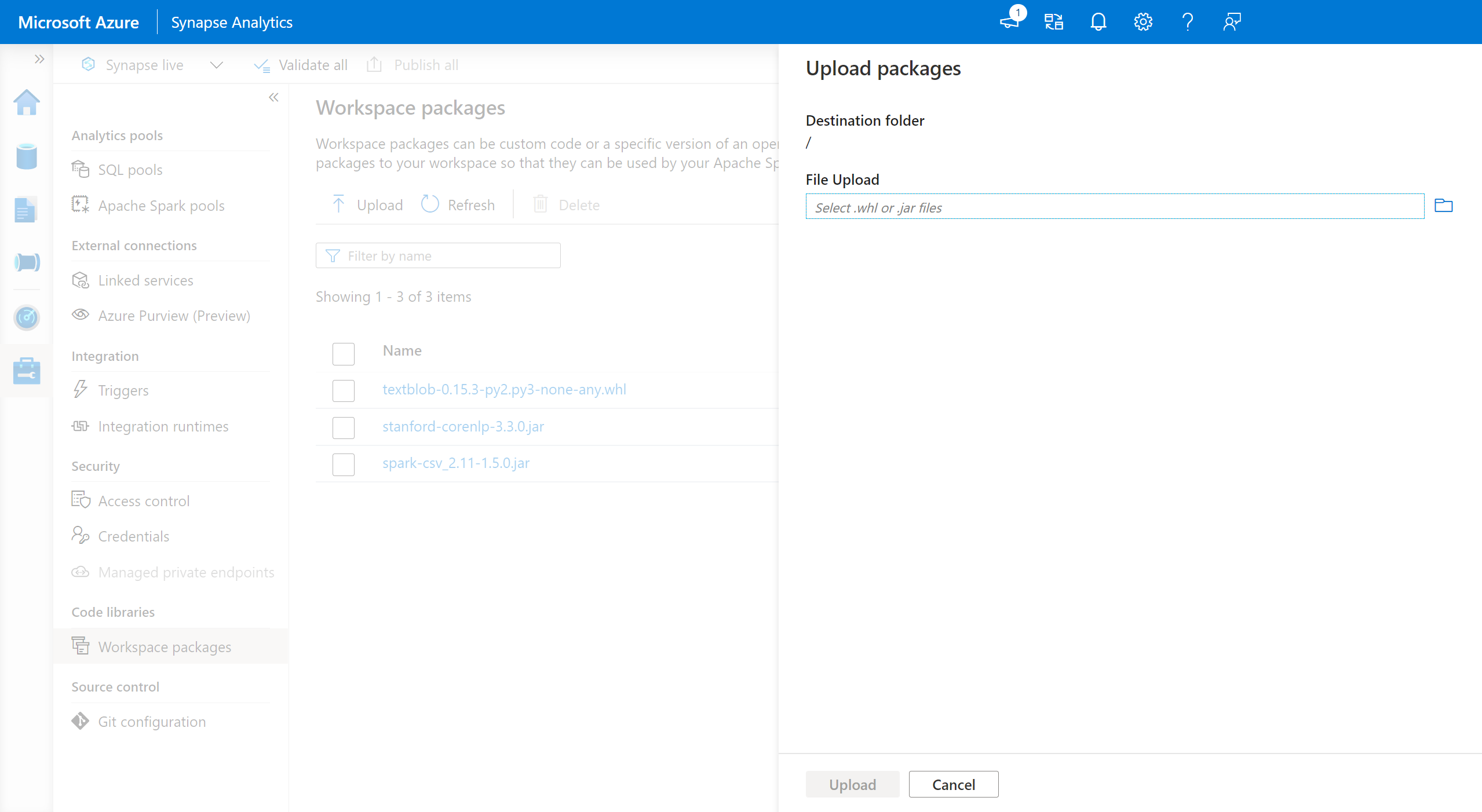

Přidání balíčků pracovního prostoru:

- Přejděte na kartu Spravovat>balíčky pracovních prostorů.

- Nahrajte soubory pomocí selektoru souborů.

- Po nahrání souborů do pracovního prostoru Azure Synapse můžete tyto balíčky přidat do fondu Apache Spark.

Upozorňující

Ve službě Azure Synapse může fond Apache Spark využívat vlastní knihovny, které se buď nahrají jako balíčky pracovních prostorů, nebo se nahrají do dobře známé cesty ke službě Azure Data Lake Storage. Obě tyto možnosti však nelze použít současně ve stejném fondu Apache Spark. Pokud jsou balíčky k dispozici pomocí obou metod, nainstalují se pouze soubory kolečka zadané v seznamu balíčků pracovních prostorů.

Jakmile se balíčky pracovního prostoru použijí k instalaci balíčků do daného fondu Apache Sparku, platí omezení, že už nemůžete zadávat balíčky pomocí cesty k účtu úložiště ve stejném fondu.

Poznámka:

Doporučujeme, abyste v pracovním prostoru neměli více balíčků se stejným názvem. Pokud chcete použít jinou verzi stejného balíčku, musíte odstranit stávající verzi a nahrát novou verzi.

Účet úložiště

Vlastní sestavené balíčky je možné nainstalovat do fondu Apache Spark tak, že všechny soubory nahrajete do účtu Azure Data Lake Storage (Gen2), který je propojený s pracovním prostorem Synapse.

Soubory by se měly nahrát do následující cesty ve výchozím kontejneru účtu úložiště:

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

Upozorňující

- V některých případech možná budete muset vytvořit cestu k souboru na základě výše uvedené struktury, pokud ještě neexistuje. Pokud složka ještě neexistuje, může být třeba přidat

pythonsložku dolibrariestéto složky. - Tato metoda správy vlastních souborů nebude podporována v modulu Runtime Azure Synapse pro Apache Spark 3.0. Informace o správě vlastních souborů najdete v části Balíčky pracovních prostorů.

Důležité

Pokud chcete nainstalovat vlastní knihovny pomocí metody Azure DataLake Storage, musíte mít oprávnění Přispěvatel dat objektů blob služby Storage nebo Vlastník dat objektů blob služby Storage v primárním účtu úložiště Gen2, který je propojený s pracovním prostorem Azure Synapse Analytics.

Další kroky

- Zobrazení výchozích knihoven: Podpora verzí Apache Sparku

- Řešení chyb instalace knihovny: Řešení chyb knihovny

- Vytvoření privátního kanálu Conda pomocí účtu Azure Data Lake Storage: Privátní kanály Conda