Správa knihoven pro fondy Apache Sparku ve službě Azure Synapse Analytics

Jakmile identifikujete balíčky Scala, Java, R (Preview) nebo Python, které chcete použít nebo aktualizovat pro aplikaci Spark, můžete je nainstalovat nebo odebrat z fondu Spark. Knihovny na úrovni fondu jsou k dispozici pro všechny poznámkové bloky a úlohy spuštěné ve fondu.

Knihovna se dá nainstalovat do fondu Sparku dvěma primárními způsoby:

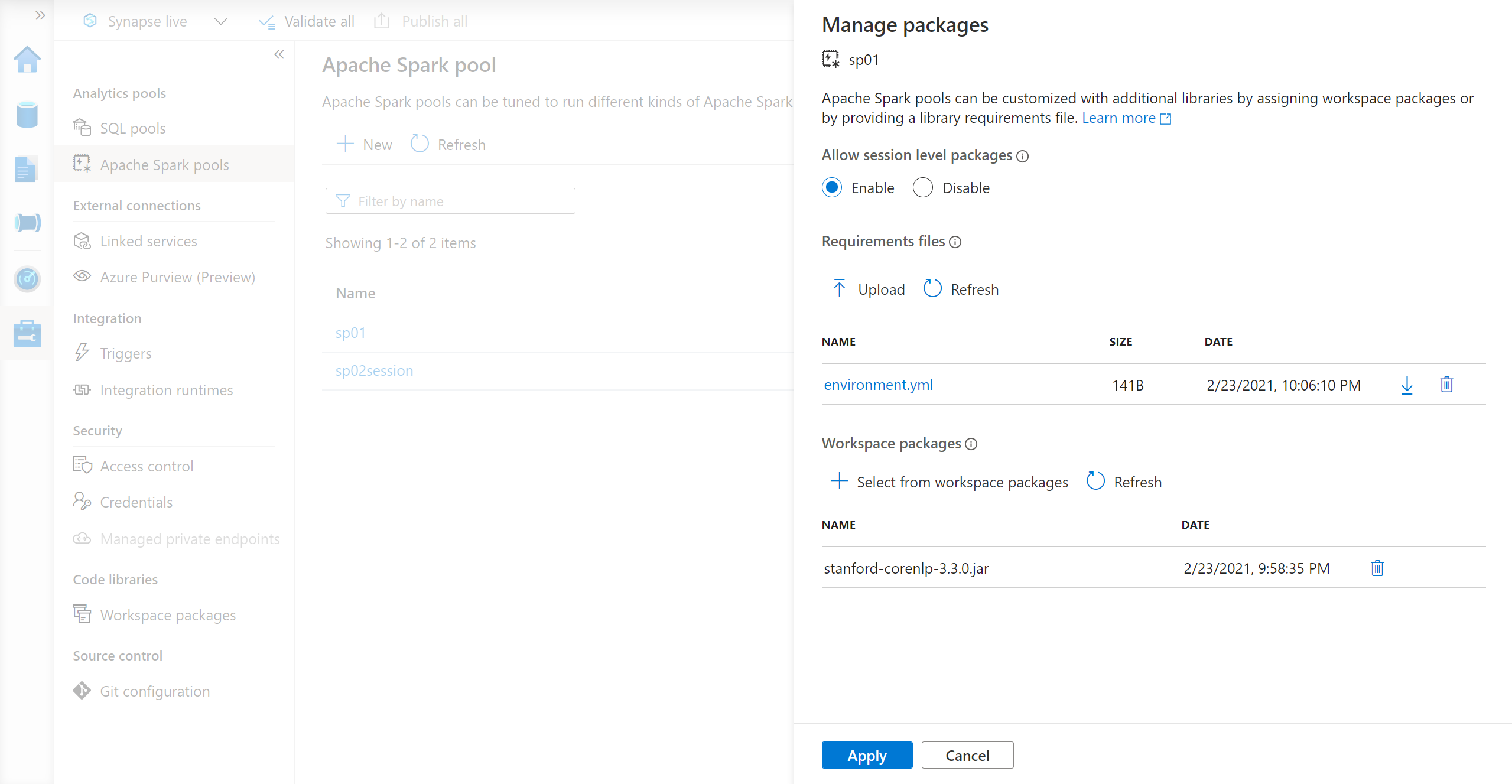

- Nainstalujte knihovnu pracovního prostoru, která se nahrála jako balíček pracovního prostoru.

- Pokud chcete aktualizovat knihovny Pythonu, zadejte requirements.txt nebo soubor specifikace prostředí Conda environment.yml pro instalaci balíčků z úložišť, jako je PyPI nebo Conda-Forge. Další informace najdete v části Formáty specifikace prostředí.

Po uložení změn spustí úloha Sparku instalaci a uloží výsledné prostředí do mezipaměti pro pozdější použití. Po dokončení úlohy používají nové úlohy Sparku nebo relace poznámkového bloku aktualizované knihovny fondu.

Důležité

- Pokud je balíček, který instalujete, velký nebo trvá dlouhou dobu, než se nainstaluje, dojde k ovlivnění doby spuštění instance Sparku.

- Změna verze PySpark, Python, Scala/Java, .NET, R nebo Spark se nepodporuje.

- Instalace balíčků z externích úložišť, jako jsou PyPI, Conda-Forge nebo výchozí kanály Conda, se v pracovních prostorech s povolenou ochranou před exfiltrací dat nepodporuje.

Správa balíčků ze sady Synapse Studio nebo webu Azure Portal

Knihovny fondu Sparku je možné spravovat buď ze sady Synapse Studio, nebo z webu Azure Portal.

Na webu Azure Portal přejděte do svého pracovního prostoru Azure Synapse Analytics.

V části Fondy analýz vyberte kartu Fondy Apache Sparku a ze seznamu vyberte fond Sparku.

V části Nastavení fondu Spark vyberte balíčky.

Pro knihovny informačních kanálů Pythonu nahrajte konfigurační soubor prostředí pomocí selektoru souborů v části Balíčky na stránce.

Můžete také vybrat další balíčky pracovního prostoru pro přidání souborů Jar, Wheel nebo Tar.gz do fondu.

Můžete také odebrat zastaralé balíčky z oddílu Balíčky pracovních prostorů a fond už tyto balíčky nepřipojí.

Po uložení změn se aktivuje systémová úloha pro instalaci a uložení zadaných knihoven do mezipaměti. Tento proces pomáhá zkrátit celkovou dobu spuštění relace.

Po úspěšném dokončení úlohy si všechny nové relace vyberou aktualizované knihovny fondu.

Důležité

Výběrem možnosti Vynutit nová nastavení ukončíte všechny aktuální relace pro vybraný fond Sparku. Jakmile budou relace ukončeny, musíte počkat, až se fond restartuje.

Pokud toto nastavení není zaškrtnuto, musíte počkat na ukončení aktuální relace Sparku nebo ji ručně zastavit. Po skončení relace je potřeba nechat fond restartovat.

Sledovat průběh instalace

Úloha Sparku rezervovaná systémem se zahájí pokaždé, když se fond aktualizuje novou sadou knihoven. Tato úloha Sparku pomáhá monitorovat stav instalace knihovny. Pokud se instalace nezdaří kvůli konfliktům knihovny nebo jiným problémům, fond Sparku se vrátí do předchozího nebo výchozího stavu.

Kromě toho mohou uživatelé kontrolovat protokoly instalace a identifikovat konflikty závislostí nebo zjistit, které knihovny byly nainstalovány během aktualizace fondu.

Zobrazení těchto protokolů:

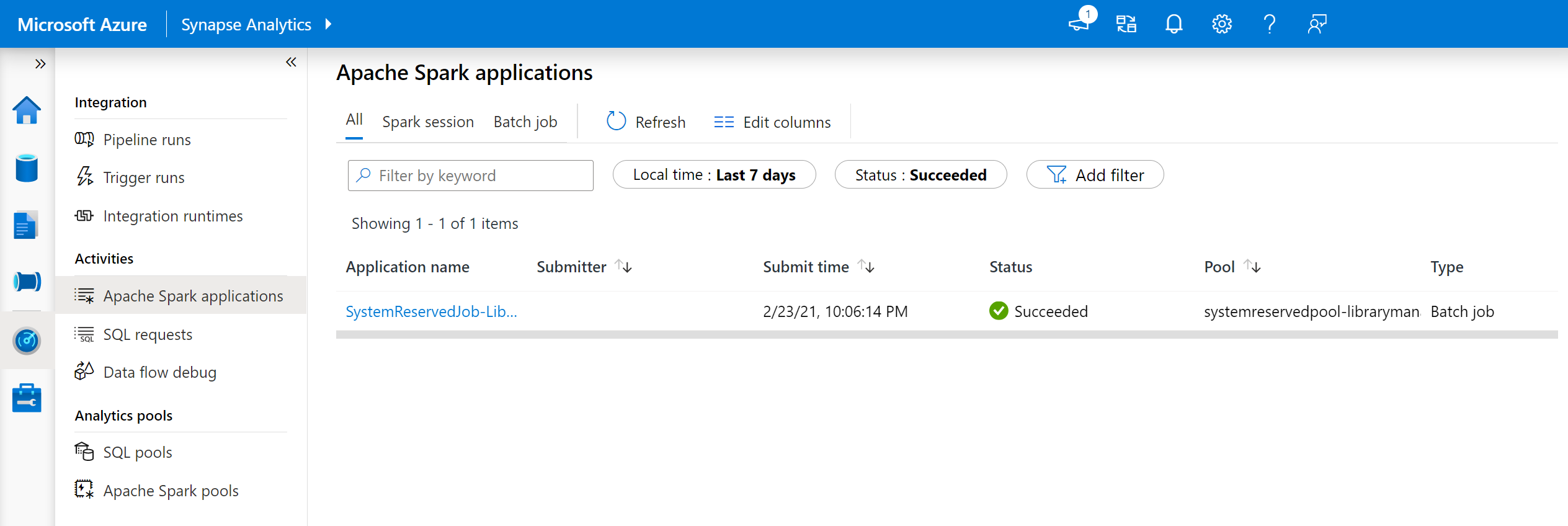

V nástroji Synapse Studio přejděte na seznam aplikací Spark na kartě Monitorování .

Vyberte systémovou úlohu aplikace Sparku, která odpovídá vaší aktualizaci fondu. Tyto systémové úlohy se spouští pod názvem SystemReservedJob-LibraryManagement.

Přepnutím zobrazíte protokoly ovladače a stdout.

Výsledky obsahují protokoly související s instalací závislostí.

Formáty specifikace prostředí

PIP requirements.txt

K upgradu prostředí je možné použít soubor requirements.txt (výstup z pip freeze příkazu). Po aktualizaci fondu se balíčky uvedené v tomto souboru stáhnou z PyPI. Úplné závislosti se pak uloží do mezipaměti a uloží se pro pozdější opakované použití fondu.

Následující fragment kódu ukazuje formát souboru požadavků. Název balíčku PyPI je uveden spolu s přesnou verzí. Tento soubor se řídí formátem popsaným v referenční dokumentaci k zablokování pip .

Tento příklad připne konkrétní verzi.

absl-py==0.7.0

adal==1.2.1

alabaster==0.7.10

Formát YML

Kromě toho můžete poskytnout soubor environment.yml pro aktualizaci prostředí fondu. Balíčky uvedené v tomto souboru se stáhnou z výchozích kanálů Conda, Conda-Forge a PyPI. Pomocí možností konfigurace můžete zadat jiné kanály nebo odebrat výchozí kanály.

Tento příklad určuje kanály a závislosti Conda/PyPI.

name: stats2

channels:

- defaults

dependencies:

- bokeh

- numpy

- pip:

- matplotlib

- koalas==1.7.0

Podrobnosti o vytvoření prostředí z tohoto souboru environment.yml najdete v tématu Aktivace prostředí.