Filtrování a ingestování do Azure Data Lake Storage Gen2 pomocí Stream Analytics bez editoru kódu

Tento článek popisuje, jak můžete pomocí editoru kódu snadno vytvořit úlohu Stream Analytics. Průběžně čte ze služby Event Hubs, filtruje příchozí data a výsledky pak průběžně zapisuje do Azure Data Lake Storage Gen2.

Požadavky

- Vaše prostředky služby Azure Event Hubs musí být veřejně přístupné a nesmí být za bránou firewall nebo zabezpečeny ve službě Azure Virtual Network.

- Data ve službě Event Hubs musí být serializovaná ve formátu JSON, CSV nebo Avro.

Vývoj úlohy Stream Analytics pro filtrování a ingestování dat v reálném čase

Na webu Azure Portal vyhledejte a vyberte instanci služby Azure Event Hubs.

Vyberte Funkce>Zpracovat data a pak vyberte Spustit na kartě Filtr a ingestování na kartu ADLS Gen2.

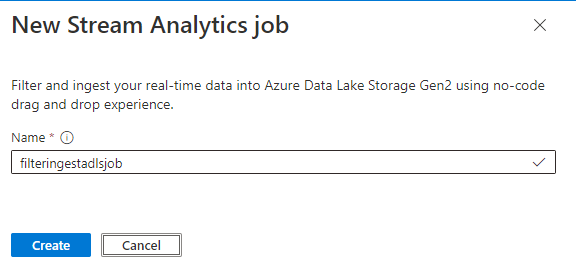

Zadejte název úlohy Stream Analytics a pak vyberte Vytvořit.

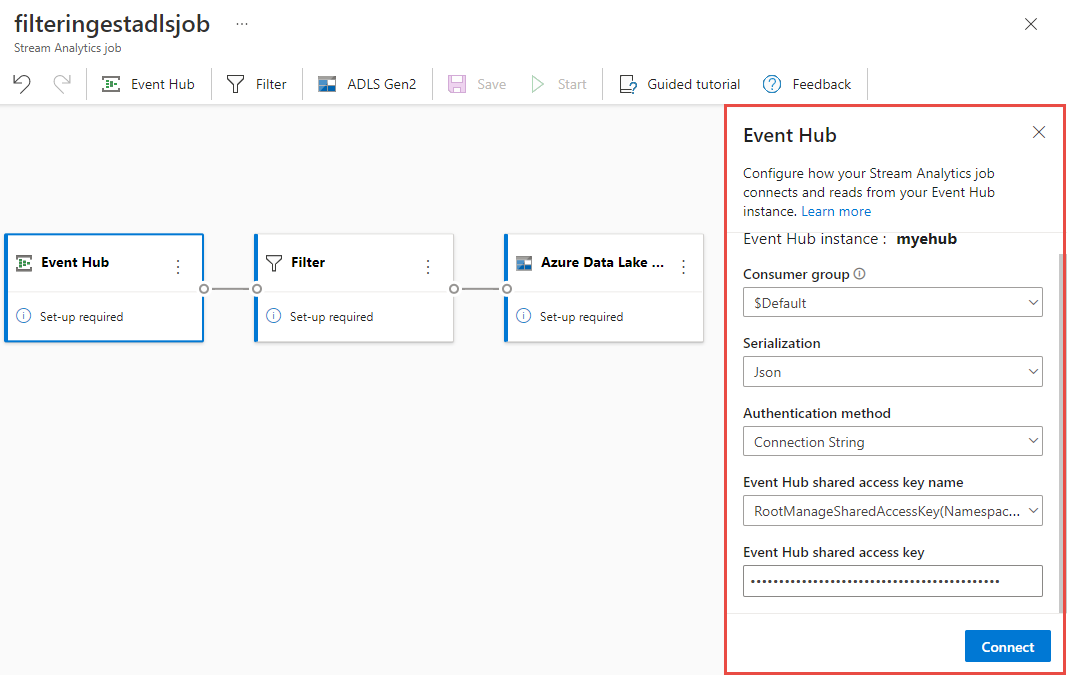

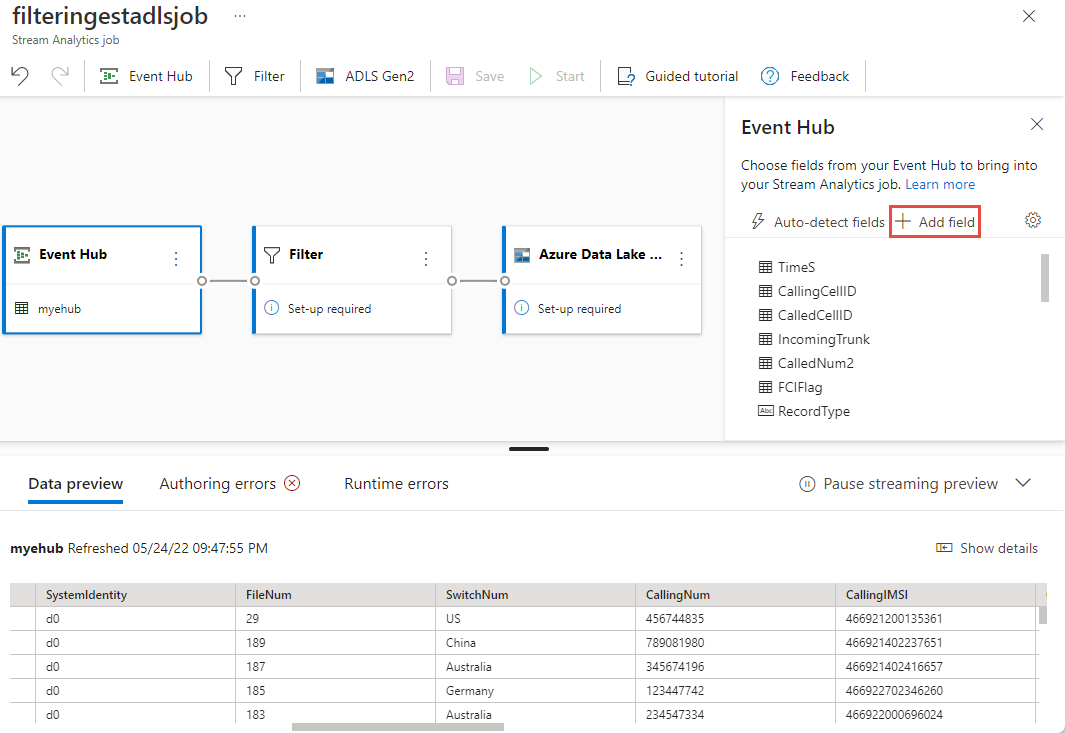

V okně Event Hubs zadejte typ serializace dat a metodu ověřování, kterou bude úloha používat pro připojení ke službě Event Hubs. Pak vyberte Připojit.

Pokud se připojení úspěšně naváže a máte datové proudy, které proudí do instance služby Event Hubs, okamžitě uvidíte dvě věci:

- Pole, která se nacházejí ve vstupních datech Můžete zvolit Přidat pole nebo vybrat tři tečky vedle každého pole a odebrat, přejmenovat nebo změnit jeho typ.

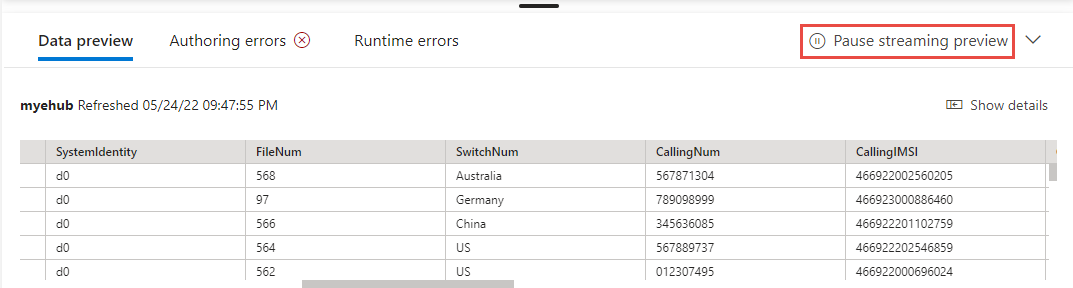

- Živá ukázka příchozích dat v tabulce náhledu dat v zobrazení diagramu Pravidelně se aktualizuje. Pokud chcete zobrazit statické zobrazení ukázkových vstupních dat, můžete vybrat Možnost Pozastavit náhled streamování.

- Pole, která se nacházejí ve vstupních datech Můžete zvolit Přidat pole nebo vybrat tři tečky vedle každého pole a odebrat, přejmenovat nebo změnit jeho typ.

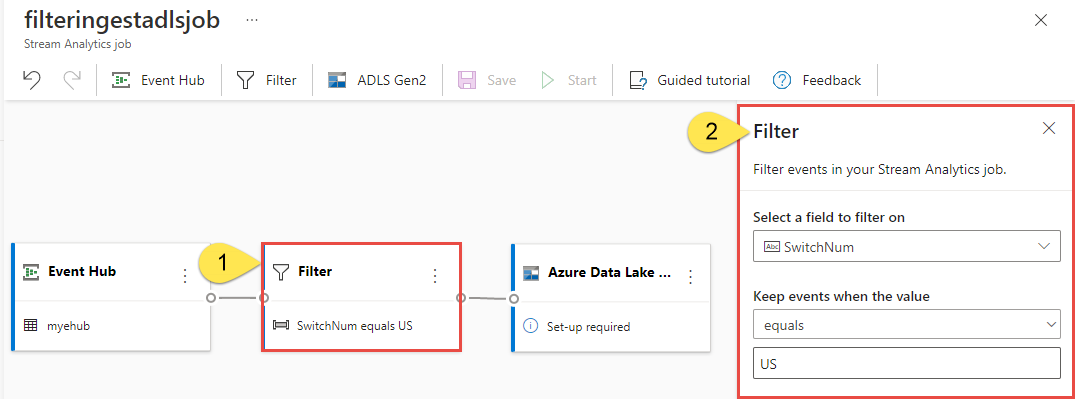

Vyberte dlaždici Filtr . V oblasti Filtru vyberte pole pro filtrování příchozích dat pomocí podmínky.

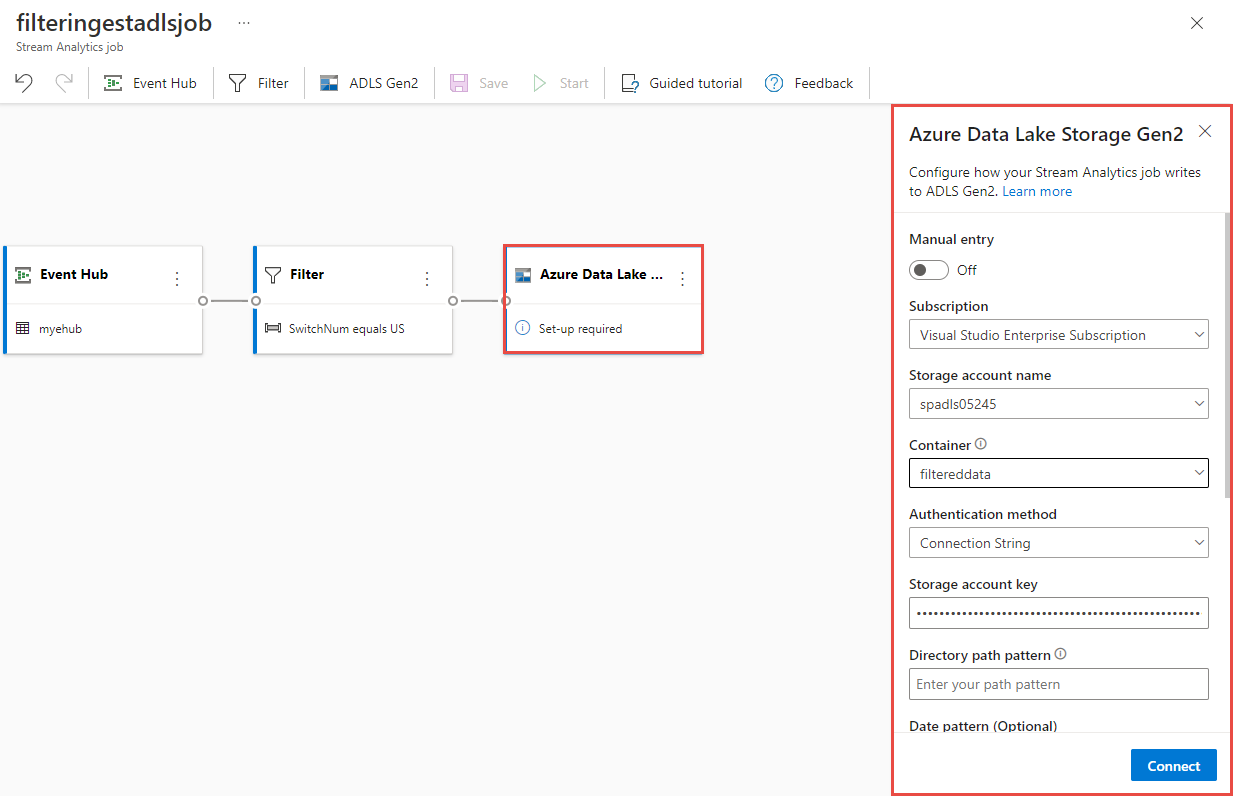

Vyberte dlaždici Azure Data Lake Storage Gen2 . Vyberte účet Azure Data Lake Gen2 a odešlete filtrovaná data:

- V rozevírací nabídce vyberte předplatné, název účtu úložiště a kontejner.

- Po výběru předplatného by se metoda ověřování a klíč účtu úložiště měly vyplnit automaticky. Vyberte Připojit.

Další informace o polích a zobrazení příkladů vzoru cesty najdete v tématu Úložiště objektů blob a výstup Azure Data Lake Gen2 ze služby Azure Stream Analytics.

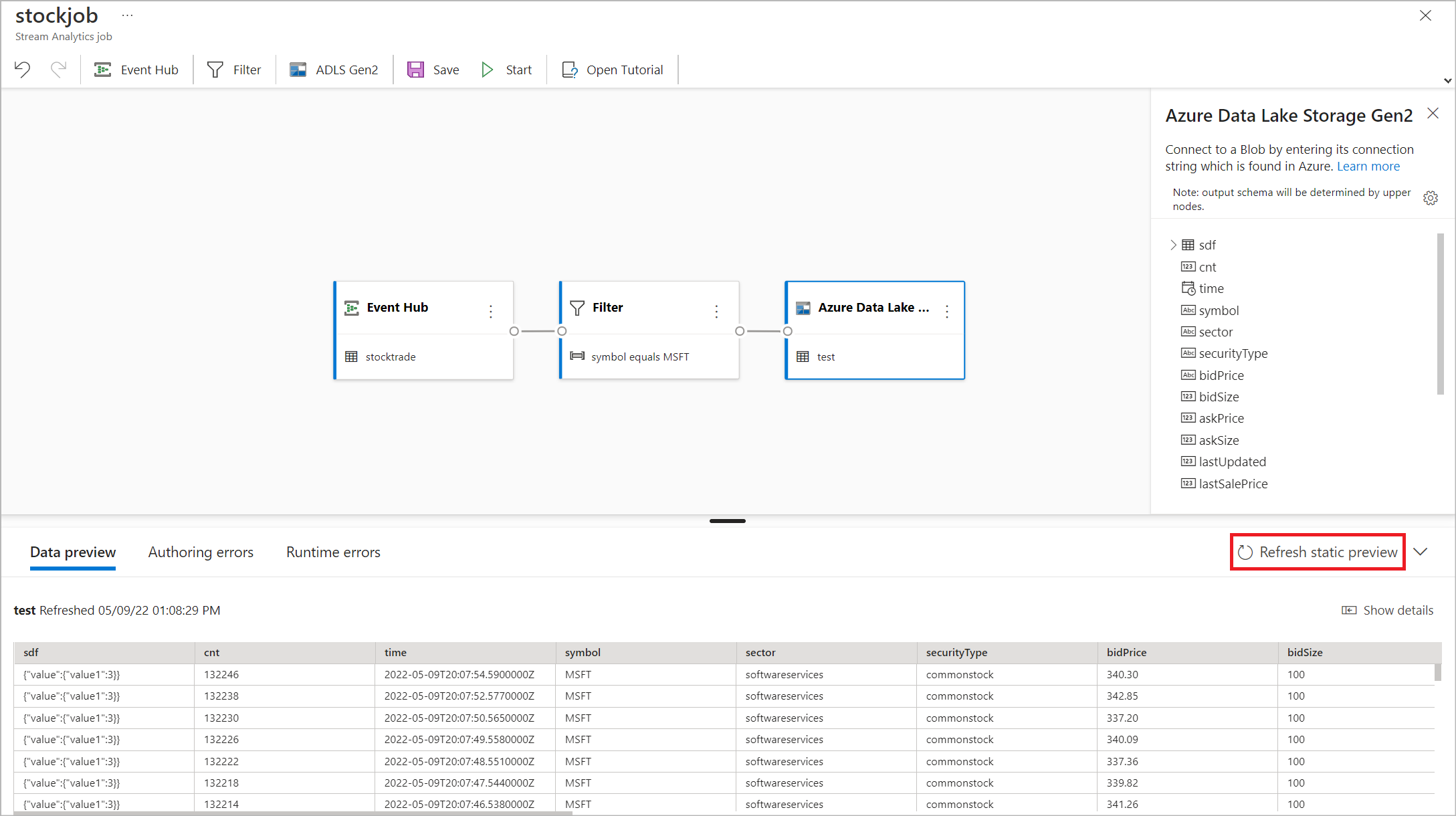

Volitelně můžete vybrat Získat statickou verzi Preview nebo Aktualizovat statickou verzi Preview a zobrazit náhled dat, která se budou ingestovat z Azure Data Lake Storage Gen2.

Vyberte Uložit a pak vyberte Spustit úlohu Stream Analytics.

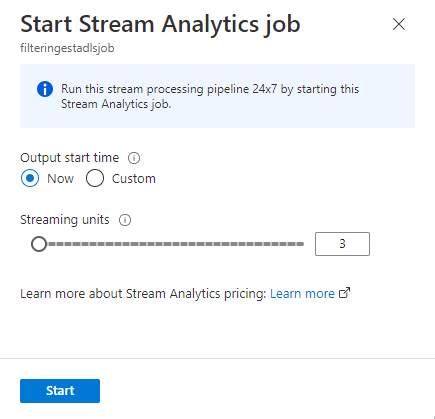

Pokud chcete úlohu spustit, zadejte počet jednotek streamování (SU), se kterými se úloha spouští. SU představuje množství výpočetních prostředků a paměti přidělené úloze. Doporučujeme, abyste začali se třemi a pak podle potřeby upravte.

Po výběru možnosti Start se úloha spustí během dvou minut a metriky se otevřou v části karta níže.

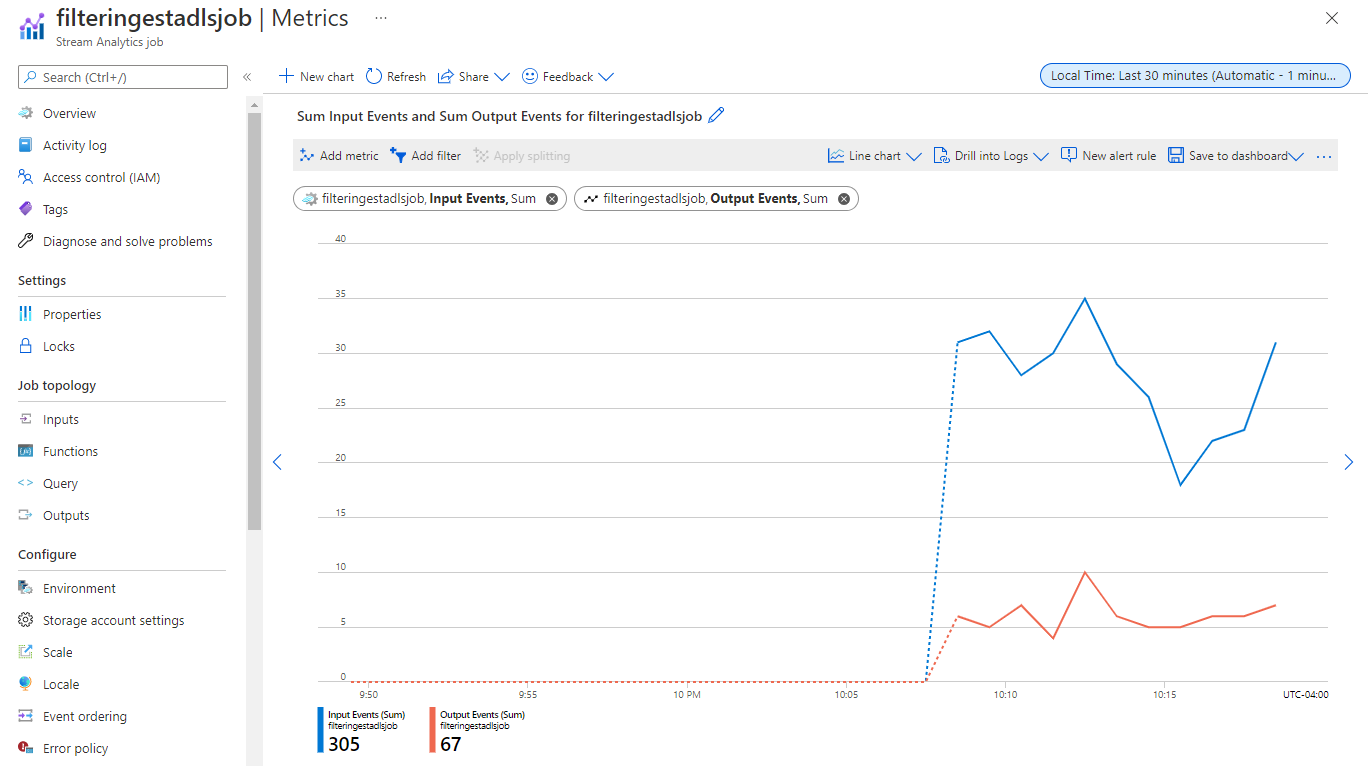

Úlohu můžete zobrazit v části Zpracovat data na kartě Úlohy Stream Analytics. Vyberte Aktualizovat , dokud neuvidíte stav úlohy Spuštěno. Vyberte Otevřít metriky a podle potřeby je monitorujte nebo zastavte a restartujte.

Tady je ukázková stránka Metriky :

Ověření dat ve službě Data Lake Storage

Měli byste vidět soubory vytvořené v kontejneru, který jste zadali.

Stáhněte a otevřete soubor, abyste potvrdili, že se zobrazují jenom filtrovaná data. V následujícím příkladu uvidíte data s přepínačem SwitchNum nastaveným na USA.

{"RecordType":"MO","SystemIdentity":"d0","FileNum":"548","SwitchNum":"US","CallingNum":"345697969","CallingIMSI":"466921402416657","CalledNum":"012332886","CalledIMSI":"466923101048691","DateS":"20220524","TimeType":0,"CallPeriod":0,"ServiceType":"S","Transfer":0,"OutgoingTrunk":"419","MSRN":"1416960750071","callrecTime":"2022-05-25T02:07:10Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:09.5140000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"552","SwitchNum":"US","CallingNum":"012351287","CallingIMSI":"262021390056324","CalledNum":"012301973","CalledIMSI":"466922202613463","DateS":"20220524","TimeType":3,"CallPeriod":0,"ServiceType":"V","Transfer":0,"OutgoingTrunk":"442","MSRN":"886932428242","callrecTime":"2022-05-25T02:07:13Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:12.7350000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"559","SwitchNum":"US","CallingNum":"456757102","CallingIMSI":"466920401237309","CalledNum":"345617823","CalledIMSI":"466923000886460","DateS":"20220524","TimeType":1,"CallPeriod":696,"ServiceType":"V","Transfer":1,"OutgoingTrunk":"419","MSRN":"886932429155","callrecTime":"2022-05-25T02:07:22Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:21.9190000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null}

Důležité informace o použití funkce geografické replikace služby Event Hubs

Služba Azure Event Hubs nedávno spustila funkci geografické replikace ve verzi Public Preview. Tato funkce se liší od funkce geografického zotavení po havárii služby Azure Event Hubs.

Pokud je typ převzetí služeb při selhání vynucený a konzistence replikace asynchronní, úloha Stream Analytics nezaručuje přesně jeden výstup výstupu do výstupu služby Azure Event Hubs.

Azure Stream Analytics, jako producent s centrem událostí výstup, může sledovat zpoždění meze úlohy během doby trvání převzetí služeb při selhání a během omezování službou Event Hubs v případě, že prodleva replikace mezi primární a sekundární dosáhne maximální nakonfigurované prodlevy.

Azure Stream Analytics, jako uživatel se službou Event Hubs jako vstupem, může během doby trvání převzetí služeb při selhání sledovat zpoždění vodoznaku a po dokončení převzetí služeb při selhání může přeskočit data nebo najít duplicitní data.

Vzhledem k těmto upozorněním doporučujeme restartovat úlohu Stream Analytics s odpovídajícím časem spuštění hned po dokončení převzetí služeb při selhání služby Event Hubs. Vzhledem k tomu, že funkce geografické replikace služby Event Hubs je ve verzi Public Preview, nedoporučujeme tento model používat pro produkční úlohy Stream Analytics v tuto chvíli. Aktuální chování Stream Analytics se zlepší, než bude funkce geografické replikace služby Event Hubs obecně dostupná a dá se použít v produkčních úlohách Stream Analytics.

Další kroky

Přečtěte si další informace o Azure Stream Analytics a o tom, jak monitorovat úlohu, kterou jste vytvořili.