Otevření nástroje LLM modelu

Nástroj Open Model LLM umožňuje využití různých modelů Open Model a Základních modelů, jako je Falcon a Llama 2, pro zpracování přirozeného jazyka v toku výzvy azure Machine Learning.

Upozornění

Oznámení o vyřazení: Nástroj OPEN Model LLM je ve prospěch nástroje LLM, který poskytuje podporu pro všechny modely podporované rozhraním API pro odvozování modelů Azure AI, a proto poskytuje větší flexibilitu.

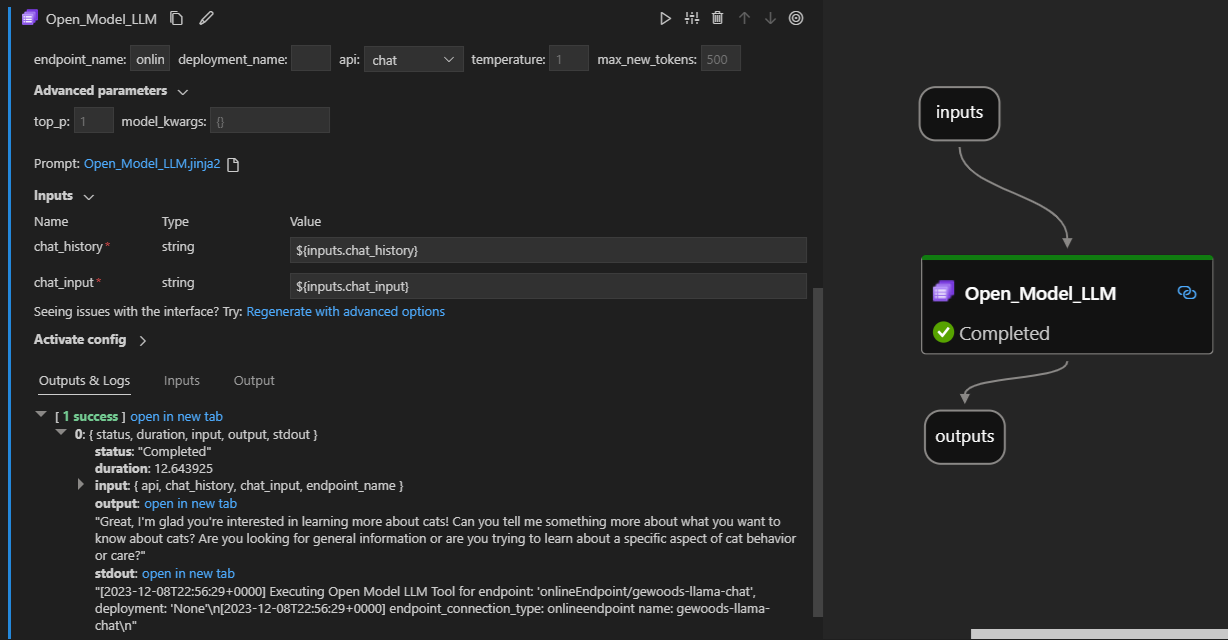

Tady je postup, jak vypadá v akci s rozšířením toku výzvy editoru Visual Studio Code. V tomto příkladu se nástroj používá k volání koncového bodu chatu LlaMa-2 a dotaz "Co je CI?".

Tento nástroj toku výzvy podporuje dva různé typy rozhraní LLM API:

- Chat: Zobrazený v předchozím příkladu. Typ rozhraní API chatu usnadňuje interaktivní konverzace s textovými vstupy a odpověďmi.

- Dokončení: Typ rozhraní API pro dokončování se používá k vygenerování dokončování textu s jednou odpovědí na základě zadaného zadání výzvy.

Rychlý přehled: Návody použít nástroj Open Model LLM?

- Vyberte model z katalogu modelů Azure Machine Learning a nasaďte ho.

- Připojte se k nasazení modelu.

- Nakonfigurujte nastavení otevřených nástrojů llm modelu.

- Připravte výzvu.

- Spuštění toku.

Požadavky: Nasazení modelu

- V katalogu modelů Azure Machine Learning vyberte model, který odpovídá vašemu scénáři.

- Pomocí tlačítka Nasadit nasaďte model do koncového bodu pro odvozování online služby Azure Machine Learning.

- Použijte jednu z možností nasazení s průběžnou platbou.

Další informace najdete v tématu Nasazení základních modelů do koncových bodů pro odvozování.

Požadavky: Připojení k modelu

Abyste mohli zobrazit tok výzvy k použití nasazeného modelu, musíte se k němu připojit. Existují dva způsoby připojení.

Připojení koncových bodů

Jakmile je tok přidružený k pracovnímu prostoru Azure Machine Learning nebo Azure AI Studio, může nástroj Open Model LLM používat koncové body v tomto pracovním prostoru.

Použití pracovních prostorů Azure Machine Learning nebo Azure AI Studio: Pokud používáte tok výzvy v jednom z pracovních prostorů prohlížečů založených na webových stránkách, budou online koncové body dostupné v tomto pracovním prostoru, který se automaticky spustí.

Nejdřív pomocí VS Code nebo kódu: Pokud používáte tok výzvy ve VS Code nebo některou z nabídek Code First, musíte se připojit k pracovnímu prostoru. Nástroj OPEN Model LLM používá k autorizaci klienta azure.identity DefaultAzureCredential. Jedním ze způsobů je nastavení hodnot přihlašovacích údajů prostředí.

Vlastní připojení

Nástroj Open Model LLM používá CustomConnection. Tok výzvy podporuje dva typy připojení:

Připojení pracovního prostoru – Připojení uložená jako tajné kódy v pracovním prostoru Služby Azure Machine Learning I když se tato připojení dají používat na mnoha místech, běžně se vytvářejí a spravují v uživatelském rozhraní studia. Pokud chcete zjistit, jak vytvořit vlastní připojení v uživatelském rozhraní studia, přečtěte si , jak vytvořit vlastní připojení.

Místní připojení – Připojení uložená místně na vašem počítači. Tato připojení nejsou dostupná v uživatelském prostředí sady Studio, ale je možné je použít s rozšířením VS Code. Pokud chcete zjistit, jak vytvořit místní vlastní připojení, přečtěte si , jak vytvořit místní připojení.

Požadované klíče, které je potřeba nastavit, jsou:

- endpoint_url

- Tuto hodnotu najdete v dříve vytvořeném koncovém bodu odvozování.

- endpoint_api_key

- Ujistěte se, že je nastavíte jako tajnou hodnotu.

- Tuto hodnotu najdete v dříve vytvořeném koncovém bodu odvozování.

- model_family

- Podporované hodnoty: LLAMA, DOLLY, GPT2 nebo FALCON

- Tato hodnota závisí na typu nasazení, na které cílíte.

Spuštění nástroje: Vstupy

Nástroj OPEN Model LLM má mnoho parametrů, z nichž některé jsou povinné. Podrobnosti najdete v následující tabulce. Tyto parametry můžete shodovat s předchozím snímkem obrazovky, abyste měli přehlednost vizuálu.

| Name | Typ | Popis | Povinní účastníci |

|---|---|---|---|

| api | string | Režim rozhraní API, který závisí na použitém modelu a vybraném scénáři. Podporované hodnoty: (Dokončení | Chat) | Ano |

| endpoint_name | string | Název koncového bodu pro odvozování online s podporovaným modelem, který je na něm nasazený. Má přednost před připojením. | Ano |

| Teplota | float (číslo s plovoucí řádovou čárkou) | Náhodnost vygenerovaného textu Výchozí hodnota je 1. | No |

| max_new_tokens | integer | Maximální počet tokenů, které se mají vygenerovat v dokončení. Výchozí hodnota je 500. | No |

| top_p | float (číslo s plovoucí řádovou čárkou) | Pravděpodobnost použití nejlepší volby z vygenerovaných tokenů. Výchozí hodnota je 1. | No |

| model_kwargs | slovník | Tento vstup slouží k poskytnutí konfigurace specifické pro použitý model. Například model Llama-02 může používat {"temperature":0,4}. Výchozí: {} | No |

| deployment_name | string | Název nasazení, které se má cílit na koncový bod pro odvozování online Pokud se nepředá žádná hodnota, použijí se nastavení provozu nástroje pro vyrovnávání zatížení odvozování. | No |

| pobídnout | string | Text prompt that the language model uses to generate its response. | Ano |

Výstupy

| rozhraní API | Návratový typ | Popis |

|---|---|---|

| Dokončení | string | Text jednoho předpovězeného dokončení |

| Chat | string | Text jedné odpovědi v konverzaci |

Nasazení do online koncového bodu

Když nasadíte tok obsahující nástroj Open Model LLM do online koncového bodu, je potřeba provést další krok pro nastavení oprávnění. Během nasazování prostřednictvím webových stránek existuje volba mezi typy identit přiřazených systémem a přiřazenými uživatelem. Buď pomocí webu Azure Portal (nebo podobné funkce), přidejte k identitě v pracovním prostoru Azure Machine Learning nebo projektu Ai Studio roli funkce Čtenář, která je hostitelem koncového bodu. Nasazení toku výzvy může být potřeba aktualizovat.