Jak používat rodinu modelů Meta Llama s studio Azure Machine Learning

V tomto článku se dozvíte o rodině modelů Meta Llama (LLM). Modely a nástroje Meta Llama jsou kolekce předem natrénovaných a jemně vyladěných generovaných textových a obrázkových modelů AI – od SLM (1B, 3B base and instruct models) for on-device and edge inferencing - to mid-size LLMs (7B, 8B and 70B Base and Instruct models) and high performant models like Meta Llama 3.1 405B Instruct for synthetic data generation and destil use cases.

Tip

Podívejte se na naše oznámení o modelech řady Llama 3.2, které jsou teď k dispozici na webu Azure AI Model Catalog prostřednictvím blogu Meta a blogu Microsoft Tech Community.

Projděte si následující ukázky GitHubu a prozkoumejte integrace s LangChain, LiteLLM, OpenAI a rozhraním Azure API.

Důležité

Tato funkce je v současné době ve verzi Public Preview. Tato verze Preview je poskytována bez smlouvy o úrovni služeb a nedoporučujeme ji pro produkční úlohy. Některé funkce se nemusí podporovat nebo mohou mít omezené možnosti.

Další informace najdete v dodatečných podmínkách použití pro verze Preview v Microsoft Azure.

Řada modelů Meta Llama

Řada modelů Meta Llama zahrnuje následující modely:

K dispozici je teď kolekce SLM a modelů pro odůvodnění obrázků llama 3.2. Llama 3.2 11B Vision Instruct a Llama 3.2 90B Vision Instruct budou k dispozici jako bezserverový koncový bod rozhraní API prostřednictvím modelů jako služby. Od dnešního dne budou pro nasazení prostřednictvím spravovaných výpočetních prostředků k dispozici následující modely:

- Llama 3.2 1B

- Llama 3.2 3B

- Llama 3.2 1B – pokyn

- Llama 3.2 3B – pokyn

- Llama Guard 3 1B

- Llama Guard 11B Vision

- Llama 3.2 11B Vision Instruct

- Llama 3.2 90B Vision Instruct jsou k dispozici pro spravované nasazení výpočetních prostředků.

Požadavky

Předplatné Azure s platným způsobem platby. Bezplatná nebo zkušební předplatná Azure nebudou fungovat. Pokud nemáte předplatné Azure, vytvořte si placený účet Azure, abyste mohli začít.

Pracovní prostor Azure Machine Learning a výpočetní instance. Pokud tyto možnosti nemáte, vytvořte je pomocí kroků v rychlém startu : Vytvoření článku o prostředcích pracovního prostoru. Nabídka nasazení bezserverového modelu rozhraní API pro Meta Llama 3.1 a Llama 3 je k dispozici pouze s pracovními prostory vytvořenými v těchto oblastech:

- East US

- USA – východ 2

- USA – středosever

- Středojižní USA

- USA – západ

- USA – západ 3

- Švédsko – střed

Seznam oblastí dostupných pro každý z modelů podporujících nasazení koncových bodů bez serveru najdete v tématu Dostupnost oblastí pro modely v koncových bodech bezserverového rozhraní API.

Řízení přístupu na základě role v Azure (Azure RBAC) slouží k udělení přístupu k operacím ve službě Azure Machine Learning. Pokud chcete provést kroky v tomto článku, musí mít váš uživatelský účet přiřazenou roli vlastníka nebo přispěvatele pro dané předplatné Azure. Případně můžete svému účtu přiřadit vlastní roli, která má následující oprávnění:

V předplatném Azure – pokud chcete přihlásit pracovní prostor k odběru nabídky Azure Marketplace, jednou pro každý pracovní prostor pro každou nabídku:

Microsoft.MarketplaceOrdering/agreements/offers/plans/readMicrosoft.MarketplaceOrdering/agreements/offers/plans/sign/actionMicrosoft.MarketplaceOrdering/offerTypes/publishers/offers/plans/agreements/readMicrosoft.Marketplace/offerTypes/publishers/offers/plans/agreements/readMicrosoft.SaaS/register/action

Ve skupině prostředků – vytvoření a použití prostředku SaaS:

Microsoft.SaaS/resources/readMicrosoft.SaaS/resources/write

V pracovním prostoru – nasazení koncových bodů (role datového vědce Azure Machine Learning už tato oprávnění obsahuje):

Microsoft.MachineLearningServices/workspaces/marketplaceModelSubscriptions/*Microsoft.MachineLearningServices/workspaces/serverlessEndpoints/*

Další informace o oprávněních najdete v tématu Správa přístupu k pracovnímu prostoru Azure Machine Learning.

Vytvoření nového nasazení

Vytvoření nasazení:

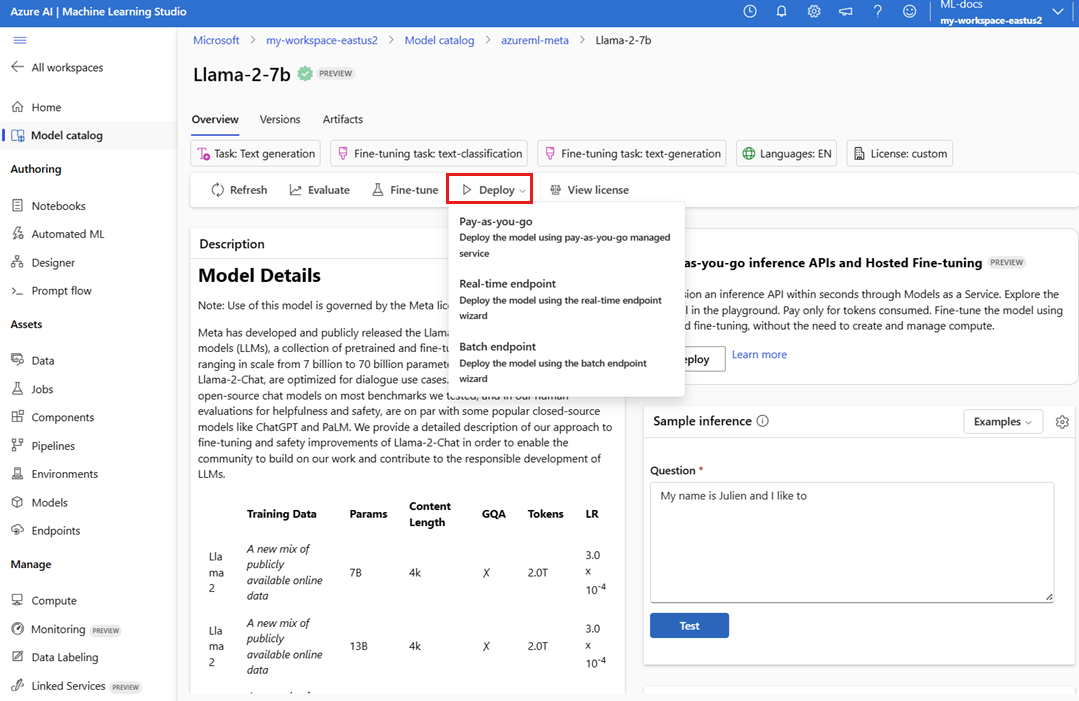

Přejděte na studio Azure Machine Learning.

Vyberte pracovní prostor, ve kterém chcete modely nasadit. Pokud chcete použít nabídku nasazení modelu s průběžným platbami, musí váš pracovní prostor patřit do jedné z dostupných oblastí uvedených v požadavcích tohoto článku.

Zvolte

Meta-Llama-3.1-405B-Instructnasazení z katalogu modelů.Případně můžete zahájit nasazení tak, že přejdete do pracovního prostoru a vyberete Koncové body bezserverové>koncové body>Vytvořit.

Na stránce Podrobnosti vyberte

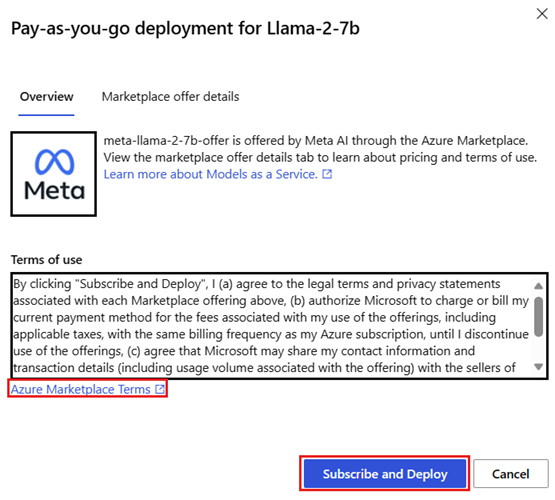

Meta-Llama-3.1-405B-InstructNasadit a pak vyberte Bezserverové rozhraní API s Azure AI Content Safety.V průvodci nasazením vyberte odkaz na podmínky Azure Marketplace, kde najdete další informace o podmínkách použití. Můžete také vybrat kartu Podrobnosti nabídky Marketplace, kde se dozvíte o cenách vybraného modelu.

Pokud model nasazujete v pracovním prostoru poprvé, musíte se přihlásit k odběru pracovního prostoru pro konkrétní nabídku (například

Meta-Llama-3.1-405B-Instruct) z Azure Marketplace. Tento krok vyžaduje, aby váš účet má oprávnění předplatného Azure a oprávnění skupiny prostředků uvedená v požadavcích. Každý pracovní prostor má vlastní předplatné konkrétní nabídky Azure Marketplace, která umožňuje řídit a monitorovat útratu. Vyberte Přihlášení k odběru a nasazení.Poznámka:

Přihlášení k odběru pracovního prostoru konkrétní nabídce Azure Marketplace (v tomto případě Llama-3-70B) vyžaduje, aby váš účet získal přístup přispěvatele nebo vlastníka na úrovni předplatného, ve které je projekt vytvořen. Případně můžete svému uživatelskému účtu přiřadit vlastní roli, která má oprávnění předplatného Azure a oprávnění skupiny prostředků uvedená v požadavcích.

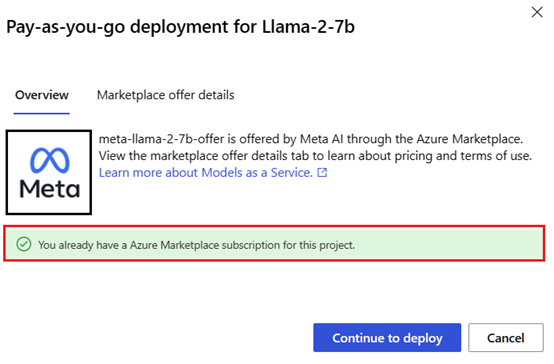

Jakmile si zaregistrujete pracovní prostor pro konkrétní nabídku Azure Marketplace, následná nasazení stejné nabídky ve stejném pracovním prostoru nevyžadují opětovné přihlášení k odběru. Proto nemusíte mít oprávnění na úrovni předplatného pro následná nasazení. Pokud se tento scénář týká vás, vyberte Pokračovat k nasazení.

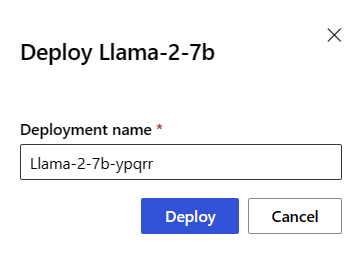

Pojmenujte nasazení. Tento název se stane součástí adresy URL rozhraní API nasazení. Tato adresa URL musí být v každé oblasti Azure jedinečná.

Vyberte Nasadit. Počkejte, až se nasazení dokončí, a budete přesměrováni na stránku bezserverových koncových bodů.

Výběrem koncového bodu otevřete stránku s podrobnostmi.

Vyberte kartu Test a začněte s modelem pracovat.

Můžete si také poznamenat cílovou adresu URL a tajný klíč pro volání nasazení a generování dokončení.

Podrobnosti koncového bodu, adresu URL a přístupové klíče můžete kdykoli najít tak, že přejdete na koncové body bezserverové>koncové body pracovního prostoru.>

Další informace o fakturaci modelů Meta Llama nasazených jako bezserverové rozhraní API najdete v tématu Aspekty nákladů a kvót pro modely Meta Llama nasazené jako bezserverové rozhraní API.

Využívání modelů Meta Llama jako služby

Modely nasazené jako služba je možné využívat pomocí chatu nebo rozhraní API pro dokončování v závislosti na typu modelu, který jste nasadili.

V pracovním prostoru vyberte koncové body bez serveru koncové body>.

Vyhledejte a vyberte nasazení,

Meta-Llama-3.1-405B-Instructkteré jste vytvořili.Zkopírujte cílovou adresu URL a hodnoty tokenu klíče.

Vytvořte požadavek rozhraní API na základě typu modelu, který jste nasadili.

- Pro modely dokončení, jako

Llama-3-8Bje například , použijte<target_url>/v1/completionsrozhraní API. - Pro modely chatu

/chat/completions, jakoMeta-Llama-3.1-405B-Instructje například , použijte rozhraní API.

Další informace o používání rozhraní API najdete v referenční části.

- Pro modely dokončení, jako

Referenční informace pro modely Meta Llama 3.1 nasazené bezserverové rozhraní API

Modely Llama přijímají rozhraní API pro odvozování modelů Azure AI na trase /chat/completions nebo rozhraní API chatu Llama na ./v1/chat/completions Stejným způsobem je možné dokončování textu vygenerovat pomocí rozhraní API pro odvozování modelů Azure AI na trase /completions nebo rozhraní API pro doplňování llama na /v1/completions

Schéma rozhraní API pro odvozování modelů Azure AI najdete v referenčních informacích k článku o dokončování chatu a specifikaci OpenAPI lze získat ze samotného koncového bodu.

Rozhraní API pro dokončování

Pomocí metody POST odešlete požadavek na trasu /v1/completions :

Požádat

POST /v1/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

Schéma požadavku

Datová část je formátovaný řetězec JSON obsahující následující parametry:

| Klíč | Typ | Výchozí | Popis |

|---|---|---|---|

prompt |

string |

Nemá žádnou výchozí hodnotu. Tato hodnota musí být zadána. | Výzva k odeslání do modelu. |

stream |

boolean |

False |

Streamování umožňuje generovat tokeny, které se odesílají jako události odesílané jen pro data, kdykoli budou k dispozici. |

max_tokens |

integer |

16 |

Maximální počet tokenů, které se mají vygenerovat v dokončení. Počet tokenů výzvy plus max_tokens nesmí překročit délku kontextu modelu. |

top_p |

float |

1 |

Alternativou k odběru vzorků s teplotou, označovanou jako vzorkování jádra, kde model bere v úvahu výsledky tokenů s top_p hmotností pravděpodobnosti. Hodnota 0,1 tedy znamená, že se považují pouze tokeny, které tvoří 10% hmotnost pravděpodobnosti. Obecně doporučujeme měnit top_p nebo temperature, ale ne obojí. |

temperature |

float |

1 |

Teplota vzorkování, která se má použít, mezi 0 a 2. Vyšší hodnoty znamenají, že vzorky modelu obecněji distribuují tokeny. Nula znamená vzorkování greedy. Doporučujeme toto nebo top_p, ale ne obojí. |

n |

integer |

1 |

Kolik dokončení se má vygenerovat pro každou výzvu. Poznámka: Protože tento parametr generuje mnoho dokončení, může rychle spotřebovat kvótu tokenu. |

stop |

array |

null |

Řetězec nebo seznam řetězců obsahující slovo, ve kterém rozhraní API přestane generovat další tokeny. Vrácený text nebude obsahovat sekvenci zastavení. |

best_of |

integer |

1 |

Vygeneruje best_of dokončení na straně serveru a vrátí "nejlepší" (ten s nejnižší pravděpodobností protokolu na token). Výsledky se nedají streamovat. Při použití ns , best_of určuje počet dokončení kandidáta a n určuje, kolik se má vrátit – best_of musí být větší než n. Poznámka: Protože tento parametr generuje mnoho dokončení, může rychle spotřebovat kvótu tokenu. |

logprobs |

integer |

null |

Číslo označující zahrnutí pravděpodobností protokolu u logprobs nejpravděpodobnějších tokenů a vybraných tokenů. Pokud je například logprobs 10, vrátí rozhraní API seznam 10 nejpravděpodobnějších tokenů. Rozhraní API vždy vrací protokolprob vzorkovaného tokenu, takže v odpovědi může být až logprobs+1 prvků. |

presence_penalty |

float |

null |

Číslo mezi -2,0 a 2,0 Kladné hodnoty sankují nové tokeny na základě toho, jestli se zatím zobrazují v textu, což zvyšuje pravděpodobnost, že model mluví o nových tématech. |

ignore_eos |

boolean |

True |

Zda se má ignorovat token EOS a pokračovat v generování tokenů po vygenerování tokenu EOS. |

use_beam_search |

boolean |

False |

Zda použít vyhledávání paprsků místo vzorkování. V takovém případě best_of musí být větší než 1 a temperature musí být 0. |

stop_token_ids |

array |

null |

Seznam ID tokenů, které po vygenerování zastaví další generování tokenů. Vrácený výstup obsahuje tokeny zastavení, pokud tokeny stop nejsou speciální tokeny. |

skip_special_tokens |

boolean |

null |

Zda se mají ve výstupu přeskočit speciální tokeny. |

Příklad

Text

{

"prompt": "What's the distance to the moon?",

"temperature": 0.8,

"max_tokens": 512,

}

Schéma odpovědi

Datová část odpovědi je slovník s následujícími poli.

| Klíč | Typ | Popis |

|---|---|---|

id |

string |

Jedinečný identifikátor dokončení. |

choices |

array |

Seznam voleb dokončení, které model vygeneroval pro vstupní výzvu. |

created |

integer |

Časové razítko unixu (v sekundách) doby vytvoření dokončení. |

model |

string |

Model_id použité k dokončení. |

object |

string |

Typ objektu, který je vždy text_completion. |

usage |

object |

Statistiky využití žádosti o dokončení |

Tip

V režimu streamování je pro každý blok odpovědí vždy null, s výjimkou posledního, finish_reason který je ukončen datovou částí [DONE].

Objekt choices je slovník s následujícími poli.

| Klíč | Typ | Popis |

|---|---|---|

index |

integer |

Index voleb. Když best_of> 1, index v tomto poli nemusí být v pořadí a nemusí být 0 až n-1. |

text |

string |

Výsledek dokončení |

finish_reason |

string |

Důvod, proč model přestal generovat tokeny: - stop: Model dosáhl přirozeného bodu zastavení nebo zadané sekvence zastavení. - length: Pokud byl dosažen maximální počet tokenů. - content_filter: Při moderování RAI a CMP vynutí moderování. - content_filter_error: Při moderování došlo k chybě a nemohla se rozhodnout o odpovědi. - null: Odezva rozhraní API stále probíhá nebo je neúplná. |

logprobs |

object |

Pravděpodobnosti protokolu vygenerovaných tokenů ve výstupním textu. |

Objekt usage je slovník s následujícími poli.

| Klíč | Typ | Hodnota |

|---|---|---|

prompt_tokens |

integer |

Počet tokenů v příkazovém řádku |

completion_tokens |

integer |

Počet tokenů vygenerovaných v dokončení |

total_tokens |

integer |

Celkový počet tokenů |

Objekt logprobs je slovník s následujícími poli:

| Klíč | Typ | Hodnota |

|---|---|---|

text_offsets |

array z integers |

Pozice nebo index každého tokenu ve výstupu dokončení. |

token_logprobs |

array z float |

Vybráno logprobs ze slovníku v top_logprobs poli. |

tokens |

array z string |

Vybrané tokeny. |

top_logprobs |

array z dictionary |

Pole slovníku. V každém slovníku je klíčem token a hodnota je prob. |

Příklad

{

"id": "12345678-1234-1234-1234-abcdefghijkl",

"object": "text_completion",

"created": 217877,

"choices": [

{

"index": 0,

"text": "The Moon is an average of 238,855 miles away from Earth, which is about 30 Earths away.",

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 7,

"total_tokens": 23,

"completion_tokens": 16

}

}

Chat API

Pomocí metody POST odešlete požadavek na trasu /v1/chat/completions :

Požádat

POST /v1/chat/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

Schéma požadavku

Datová část je formátovaný řetězec JSON obsahující následující parametry:

| Klíč | Typ | Výchozí | Popis |

|---|---|---|---|

messages |

string |

Nemá žádnou výchozí hodnotu. Tato hodnota musí být zadána. | Zpráva nebo historie zpráv, které se mají použít k zobrazení výzvy k zobrazení výzvy modelu. |

stream |

boolean |

False |

Streamování umožňuje generovat tokeny, které se odesílají jako události odesílané jen pro data, kdykoli budou k dispozici. |

max_tokens |

integer |

16 |

Maximální počet tokenů, které se mají vygenerovat v dokončení. Počet tokenů výzvy plus max_tokens nesmí překročit délku kontextu modelu. |

top_p |

float |

1 |

Alternativou k odběru vzorků s teplotou, označovanou jako vzorkování jádra, kde model bere v úvahu výsledky tokenů s top_p hmotností pravděpodobnosti. Hodnota 0,1 tedy znamená, že se považují pouze tokeny, které tvoří 10% hmotnost pravděpodobnosti. Obecně doporučujeme měnit top_p nebo temperature, ale ne obojí. |

temperature |

float |

1 |

Teplota vzorkování, která se má použít, mezi 0 a 2. Vyšší hodnoty znamenají, že vzorky modelu obecněji distribuují tokeny. Nula znamená vzorkování greedy. Doporučujeme toto nebo top_p, ale ne obojí. |

n |

integer |

1 |

Kolik dokončení se má vygenerovat pro každou výzvu. Poznámka: Protože tento parametr generuje mnoho dokončení, může rychle spotřebovat kvótu tokenu. |

stop |

array |

null |

Řetězec nebo seznam řetězců obsahující slovo, ve kterém rozhraní API přestane generovat další tokeny. Vrácený text nebude obsahovat sekvenci zastavení. |

best_of |

integer |

1 |

Vygeneruje best_of dokončení na straně serveru a vrátí "nejlepší" (ten s nejnižší pravděpodobností protokolu na token). Výsledky se nedají streamovat. Při použití ns , best_of řídí počet kandidátských dokončení a n určuje, kolik se má vrátit –best_of musí být větší než n. Poznámka: Protože tento parametr generuje mnoho dokončení, může rychle spotřebovat kvótu tokenu. |

logprobs |

integer |

null |

Číslo označující zahrnutí pravděpodobností protokolu u logprobs nejpravděpodobnějších tokenů a vybraných tokenů. Pokud je například logprobs 10, vrátí rozhraní API seznam 10 nejpravděpodobnějších tokenů. Rozhraní API vždy vrátí protokolprob ukázkového tokenu, takže v odpovědi může být až logprobs+1 prvků. |

presence_penalty |

float |

null |

Číslo mezi -2,0 a 2,0 Kladné hodnoty sankují nové tokeny na základě toho, jestli se zatím zobrazují v textu, což zvyšuje pravděpodobnost, že model mluví o nových tématech. |

ignore_eos |

boolean |

True |

Zda se má ignorovat token EOS a pokračovat v generování tokenů po vygenerování tokenu EOS. |

use_beam_search |

boolean |

False |

Zda použít vyhledávání paprsků místo vzorkování. V takovém případě best_of musí být větší než 1 a temperature musí být 0. |

stop_token_ids |

array |

null |

Seznam ID tokenů, které po vygenerování zastaví další generování tokenů. Vrácený výstup obsahuje tokeny zastavení, pokud tokeny stop nejsou speciální tokeny. |

skip_special_tokens |

boolean |

null |

Zda se mají ve výstupu přeskočit speciální tokeny. |

Objekt messages má následující pole:

| Klíč | Typ | Hodnota |

|---|---|---|

content |

string |

Obsah zprávy. Obsah se vyžaduje pro všechny zprávy. |

role |

string |

Role autora zprávy Jeden z system, usernebo assistant. |

Příklad

Text

{

"messages":

[

{

"role": "system",

"content": "You are a helpful assistant that translates English to Italian."},

{

"role": "user",

"content": "Translate the following sentence from English to Italian: I love programming."

}

],

"temperature": 0.8,

"max_tokens": 512,

}

Schéma odpovědi

Datová část odpovědi je slovník s následujícími poli.

| Klíč | Typ | Popis |

|---|---|---|

id |

string |

Jedinečný identifikátor dokončení. |

choices |

array |

Seznam voleb dokončení, které model vygeneroval pro vstupní zprávy. |

created |

integer |

Časové razítko unixu (v sekundách) doby vytvoření dokončení. |

model |

string |

Model_id použité k dokončení. |

object |

string |

Typ objektu, který je vždy chat.completion. |

usage |

object |

Statistiky využití žádosti o dokončení |

Tip

V režimu streamování je pro každý blok odpovědí vždy null, s výjimkou posledního, finish_reason který je ukončen datovou částí [DONE]. V každém choices objektu se klíč pro messages změní pomocí delta.

Objekt choices je slovník s následujícími poli.

| Klíč | Typ | Popis |

|---|---|---|

index |

integer |

Index voleb. Když best_of1, index v tomto poli nemusí být v pořadí a nemusí být 0 n-1.> |

messages nebo delta |

string |

Výsledkem dokončení chatu je messages objekt. Při použití delta režimu streamování se použije klíč. |

finish_reason |

string |

Důvod, proč model přestal generovat tokeny: - stop: Model narazil na přirozený bod zastavení nebo zadanou sekvenci zastavení. - length: Pokud byl dosažen maximální počet tokenů. - content_filter: Při moderování RAI a CMP vynutí moderování - content_filter_error: Při moderování došlo k chybě a nemohla se rozhodnout o odpovědi. - null: Odezva rozhraní API stále probíhá nebo je neúplná. |

logprobs |

object |

Pravděpodobnosti protokolu vygenerovaných tokenů ve výstupním textu. |

Objekt usage je slovník s následujícími poli.

| Klíč | Typ | Hodnota |

|---|---|---|

prompt_tokens |

integer |

Počet tokenů v příkazovém řádku |

completion_tokens |

integer |

Počet tokenů vygenerovaných v dokončení |

total_tokens |

integer |

Celkový počet tokenů |

Objekt logprobs je slovník s následujícími poli:

| Klíč | Typ | Hodnota |

|---|---|---|

text_offsets |

array z integers |

Pozice nebo index každého tokenu ve výstupu dokončení. |

token_logprobs |

array z float |

Vybráno logprobs ze slovníku v top_logprobs poli. |

tokens |

array z string |

Vybrané tokeny. |

top_logprobs |

array z dictionary |

Pole slovníku. V každém slovníku je klíčem token a hodnota je prob. |

Příklad

Následuje příklad odpovědi.

{

"id": "12345678-1234-1234-1234-abcdefghijkl",

"object": "chat.completion",

"created": 2012359,

"model": "",

"choices": [

{

"index": 0,

"finish_reason": "stop",

"message": {

"role": "assistant",

"content": "Sure, I\'d be happy to help! The translation of ""I love programming"" from English to Italian is:\n\n""Amo la programmazione.""\n\nHere\'s a breakdown of the translation:\n\n* ""I love"" in English becomes ""Amo"" in Italian.\n* ""programming"" in English becomes ""la programmazione"" in Italian.\n\nI hope that helps! Let me know if you have any other sentences you\'d like me to translate."

}

}

],

"usage": {

"prompt_tokens": 10,

"total_tokens": 40,

"completion_tokens": 30

}

}

Nasazení modelů Meta Llama do spravovaného výpočetního prostředí

Kromě nasazení se spravovanou službou s průběžnými platbami můžete také nasadit modely Meta Llama 3.1 do spravovaného výpočetního prostředí v studio Azure Machine Learning. Při nasazení do spravovaného výpočetního prostředí můžete vybrat všechny podrobnosti o infrastruktuře, na které model běží, včetně virtuálních počítačů, které se mají použít, a počtu instancí pro zpracování očekávaného zatížení. Modely nasazené do spravované kvóty využití výpočetních prostředků z vašeho předplatného Na spravovaných výpočetních prostředcích jsou k dispozici následující modely z vlny vydání verze 3.1:

Meta-Llama-3.1-8B-Instruct(podporováno FT)Meta-Llama-3.1-70B-Instruct(podporováno FT)Meta-Llama-3.1-8B(podporováno FT)Meta-Llama-3.1-70B(podporováno FT)Llama Guard 3 8BPrompt Guard

Vytvoření nového nasazení

Pomocí těchto kroků nasaďte model, například Meta-Llama-3.1-70B-Instruct do spravovaného výpočetního prostředí v studio Azure Machine Learning.

Vyberte pracovní prostor, ve kterém chcete model nasadit.

Zvolte model, který chcete nasadit z katalogu modelů studia.

Případně můžete zahájit nasazení tak, že přejdete do pracovního prostoru a vyberete Vytvoření spravovaného výpočetního>objektu>koncových bodů.

Na stránce přehledu modelu vyberte Nasadit a pak spravované výpočetní prostředky bez zabezpečení obsahu Azure AI.

Na stránce Nasadit s využitím azure AI Content Safety (Preview) vyberte Přeskočit zabezpečení obsahu Azure AI, abyste mohli model dál nasazovat pomocí uživatelského rozhraní.

Tip

Obecně doporučujeme pro nasazení modelu Meta Llama vybrat možnost Povolit bezpečnost obsahu Azure AI (doporučeno). Tato možnost nasazení se v současné době podporuje jenom pomocí sady Python SDK a děje se to v poznámkovém bloku.

Vyberte Pokračovat.

Tip

Pokud ve vybraném projektu nemáte k dispozici dostatečnou kvótu, můžete použít možnost Použít sdílenou kvótu a potvrdím, že tento koncový bod se odstraní za 168 hodin.

Vyberte virtuální počítač a počet instancí, které chcete přiřadit k nasazení.

Vyberte, jestli chcete toto nasazení vytvořit jako součást nového koncového bodu nebo existujícího. Koncové body můžou hostovat více nasazení a současně udržovat konfiguraci prostředků výhradně pro každou z nich. Nasazení pod stejným koncovým bodem sdílejí identifikátor URI koncového bodu a jeho přístupové klíče.

Uveďte, jestli chcete povolit shromažďování dat odvozování (Preview).

Uveďte, jestli chcete povolit model balíčku (Preview).

Vyberte Nasadit. Po chvíli se otevře stránka podrobností koncového bodu.

Počkejte na dokončení vytváření a nasazení koncového bodu. Tento krok může trvat několik minut.

Vyberte stránku Využití koncového bodu a získejte ukázky kódu, které můžete použít k využívání nasazeného modelu ve vaší aplikaci.

Další informace o nasazení modelů do spravovaného výpočetního prostředí pomocí studia najdete v tématu Nasazení základních modelů do koncových bodů pro odvozování.

Využívání modelů Meta Llama nasazených do spravovaného výpočetního prostředí

Referenční informace o tom, jak vyvolat modely Meta Llama 3 nasazené do spravovaného výpočetního prostředí, najdete na kartě modelu v katalogu modelů studio Azure Machine Learning. Karta každého modelu má stránku s přehledem, která obsahuje popis modelu, ukázky pro odvozování založené na kódu, vyladění a vyhodnocení modelu.

Další příklady odvození

| Balíček | Ukázkový poznámkový blok |

|---|---|

| Rozhraní příkazového řádku s využitím webových požadavků CURL a Pythonu | webrequests.ipynb |

| OpenAI SDK (experimentální) | openaisdk.ipynb |

| LangChain | langchain.ipynb |

| LiteLLM SDK | litellm.ipynb |

Náklady a kvóty

Důležité informace o nákladech a kvótách pro modely Meta Llama 3.1 nasazené jako bezserverové rozhraní API

Modely Meta Llama 3.1 nasazené jako bezserverové rozhraní API nabízí Meta prostřednictvím Azure Marketplace a jsou integrované s studio Azure Machine Learning pro použití. Ceny na Azure Marketplace najdete při nasazování nebo dolaďování modelů.

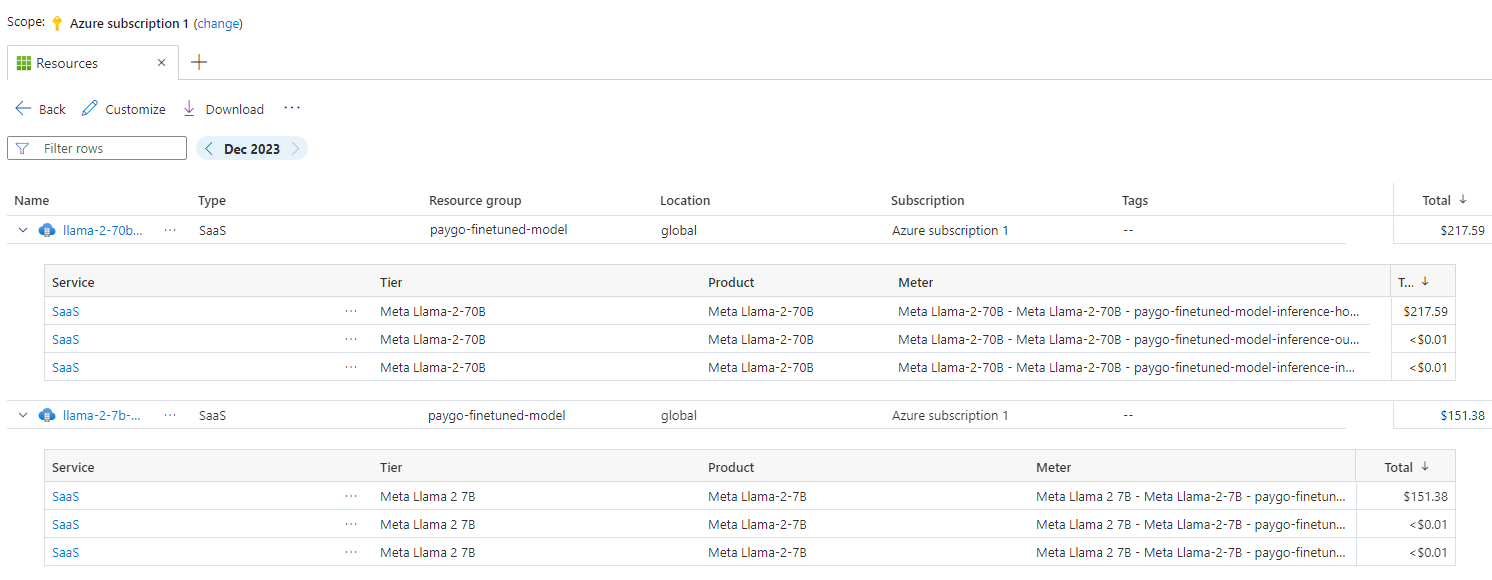

Pokaždé, když si pracovní prostor předplatí danou nabídku modelu z Azure Marketplace, vytvoří se nový zdroj pro sledování nákladů spojených s jeho spotřebou. Ke sledování nákladů spojených s odvozováním a dolaďováním se používá stejný zdroj, nicméně ke sledování každého scénáře je k dispozici více měřidel nezávisle.

Další informace o sledování nákladů naleznete v části Sledování nákladů na modely nabízené prostřednictvím služby Azure Marketplace.

Kvóta se spravuje podle nasazení. Každé nasazení má limit rychlosti 200 000 tokenů za minutu a 1 000 požadavků rozhraní API za minutu. V současné době ale omezujeme jedno nasazení na model na jeden projekt. Pokud aktuální limity sazeb pro vaše scénáře nestačí, obraťte se na podporu Microsoft Azure.

Důležité informace o nákladech a kvótách pro modely Meta Llama 3.1 nasazené spravované výpočetní prostředky

Pro nasazení a odvozování modelů Meta Llama 3.1 se spravovanými výpočetními prostředky využíváte kvótu jader virtuálního počítače přiřazenou k vašemu předplatnému v jednotlivých oblastech. Když si zaregistrujete Azure AI Studio, dostanete výchozí kvótu virtuálních počítačů pro několik rodin virtuálních počítačů dostupných v dané oblasti. Nasazení můžete dál vytvářet, dokud nedosáhnete limitu kvóty. Jakmile dosáhnete tohoto limitu, můžete požádat o navýšení kvóty.

Filtrování obsahu

Modely nasazené jako bezserverové rozhraní API jsou chráněné zabezpečením obsahu Azure AI. Při nasazení do spravovaných výpočetních prostředků se můžete z této funkce odhlásit. S povolenou bezpečností obsahu Azure AI prochází výzva i dokončení souborem klasifikačních modelů určených k detekci a zabránění výstupu škodlivého obsahu. Systém filtrování obsahu (Preview) detekuje a provádí akce s konkrétními kategoriemi potenciálně škodlivého obsahu ve vstupních výzev i dokončení výstupu. Přečtěte si další informace o bezpečnosti obsahu Azure AI.