Načtení rozšířené generace pomocí toku výzvy služby Azure Machine Learning (Preview)

Důležité

Tato funkce je v současné době ve verzi Public Preview. Tato verze Preview je poskytována bez smlouvy o úrovni služeb a nedoporučujeme ji pro produkční úlohy. Některé funkce se nemusí podporovat nebo mohou mít omezené možnosti.

Další informace najdete v dodatečných podmínkách použití pro verze Preview v Microsoft Azure.

Načtení rozšířené generace (RAG) je vzor, který funguje s předem natrénovanými velkými jazykovými modely (LLM) a vlastními daty pro generování odpovědí. Ve službě Azure Machine Learning nyní můžete implementovat RAG v toku instrukcí. Podpora pro RAG je v současné době ve verzi Public Preview.

Tento článek uvádí některé výhody RAG, poskytuje technický přehled a popisuje podporu RAG ve službě Azure Machine Learning.

Poznámka:

Začínáte s koncepty LLM a RAG? Tento videoklip z prezentace Microsoftu nabízí jednoduché vysvětlení.

Proč používat RAG?

Základní model se tradičně trénuje s daty k určitému bodu v čase, aby se zajistila jeho efektivita při provádění konkrétních úloh a přizpůsobení se požadované doméně. Někdy ale potřebujete pracovat s novějšími nebo více aktuálními daty. Dva přístupy můžou doplnit základní model: doladění nebo další trénování základního modelu s novými daty nebo RAG, které k doplnění nebo vedení modelu v reálném čase používají výzvu k vytvoření nebo vedení modelu.

Jemné ladění je vhodné pro kontinuální přizpůsobení domény, což umožňuje významná vylepšení kvality modelu, ale často způsobuje vyšší náklady. Rag naopak nabízí alternativní přístup, který umožňuje použití stejného modelu jako modul odůvodnění nad novými daty poskytnutými v příkazovém řádku. Tato technika umožňuje učení v kontextu bez nutnosti nákladného vyladění a umožňuje firmám efektivněji používat LLM.

RAG umožňuje firmám dosahovat přizpůsobených řešení při zachování relevance dat a optimalizaci nákladů. Díky přijetí RAG mohou společnosti využívat možnosti odůvodnění LLM, které využívají své stávající modely ke zpracování a generování odpovědí na základě nových dat. RAG usnadňuje pravidelné aktualizace dat, aniž by bylo nutné doladit a zjednodušit integraci LLM do firem.

- Uveďte doplňující data jako direktivu nebo výzvu k LLM.

- Přidá komponentu kontroly faktů do stávajících modelů.

- Trénování modelu na aktuálních datech bez nutnosti dalšího času a nákladů spojených s vyladěním

- Trénování dat specifických pro vaši firmu

Technický přehled používání RAG ve velkých jazykových modelech (LLM)

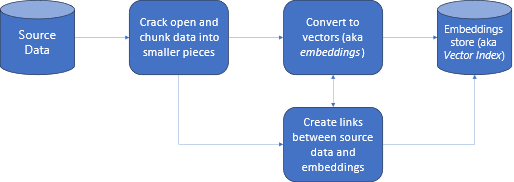

Při načítání informací je RAG přístup, který umožňuje využívat výkon LLM s vlastními daty. Povolení LLM pro přístup k vlastním datům zahrnuje následující kroky. Nejprve by se velká data měla rozdělit do spravovatelných částí. Za druhé, bloky dat je potřeba převést do prohledávatelného formátu. Za třetí by převedená data měla být uložena v umístění, které umožňuje efektivní přístup. Kromě toho je důležité ukládat relevantní metadata pro citace nebo odkazy, když LLM poskytuje odpovědi.

Podívejme se na diagram podrobněji.

Zdrojová data: tady jsou vaše data. Může se jednat o soubor nebo složku na vašem počítači, soubor v cloudovém úložišti, datový prostředek služby Azure Machine Learning, úložiště Git nebo databázi SQL.

Vytváření bloků dat: Data ve zdroji je potřeba převést na prostý text. Například wordové dokumenty nebo soubory PDF musí být prolomené otevřené a převedené na text. Text se pak rozdělí na menší části.

Převod textu na vektory: označuje se jako vkládání. Vektory jsou číselné reprezentace konceptů převedených na číselné sekvence, což usnadňuje počítačům pochopení vztahů mezi těmito koncepty.

Propojení mezi zdrojovými daty a vkládáním: Tyto informace se ukládají jako metadata na blocích, které se pak používají k usnadnění generování citací při generování odpovědí.

RAG se službou Azure Machine Learning (Preview)

RAG ve službě Azure Machine Learning je povolená integrací se službou Azure OpenAI pro velké jazykové modely a vektorizaci s podporou Faiss a Azure AI Search (dříve Cognitive Search) jako vektorových úložišť a podporou opensourcových nabídek a architektur, jako je LangChain pro vytváření bloků dat.

Aby bylo možné implementovat RAG, musí být splněno několik klíčových požadavků. Nejprve by se data měla naformátovat způsobem, který umožňuje efektivní vyhledávání před jejich odesláním do LLM, což nakonec snižuje spotřebu tokenů. Aby se zajistila účinnost RAG, je také důležité pravidelně aktualizovat data. Kromě toho vám schopnost vyhodnotit výstup z LLM pomocí vašich dat umožňuje měřit účinnost vašich technik. Azure Machine Learning vám umožňuje snadno začít s těmito aspekty, ale také umožňuje zlepšit a produkční prostředí RAG. Azure Machine Learning nabízí:

- Ukázky pro spouštění scénářů Q&A založených na RAG

- Uživatelské rozhraní založené na průvodci pro vytváření a správu dat a jejich začlenění do toků výzvy

- Schopnost měřit a vylepšit pracovní postupy RAG, včetně generování testovacích dat, automatického vytváření výzev a vizualizovaných metrik vyhodnocení výzvy

- Pokročilé scénáře s větší kontrolou pomocí nových integrovaných komponent RAG pro vytváření vlastních kanálů v poznámkových blocích

- Prostředí kódu, které umožňuje využití dat vytvořených pomocí opensourcových nabídek, jako je LangChain.

- Bezproblémová integrace pracovních postupů RAG do pracovních postupů MLOps pomocí kanálů a úloh

Závěr

Azure Machine Learning umožňuje začlenit rag do AI pomocí studio Azure Machine Learning nebo kódu s kanály Azure Machine Learning. Nabízí několik hodnot, jako je možnost měřit a vylepšit pracovní postupy RAG, generování testovacích dat, automatické vytváření výzev a vizualizaci metrik vyhodnocení výzvy. Umožňuje integraci pracovních postupů RAG do pracovních postupů MLOps pomocí kanálů. Data můžete použít také s opensourcovými nabídkami, jako je LangChain.

Další kroky

Použití vektorových úložišť se službou Azure Machine Learning (Preview)

Vytvoření vektorového indexu v toku výzvy služby Azure Machine Learning (Preview)