Transformace dat spuštěním definice úlohy Synapse Spark

PLATÍ PRO:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

Aktivita definice úlohy Azure Synapse Spark v kanálu spouští definici úlohy Synapse Spark v pracovním prostoru Azure Synapse Analytics. Tento článek vychází z článku o aktivitách transformace dat, který představuje obecný přehled transformace dat a podporovaných transformačních aktivit.

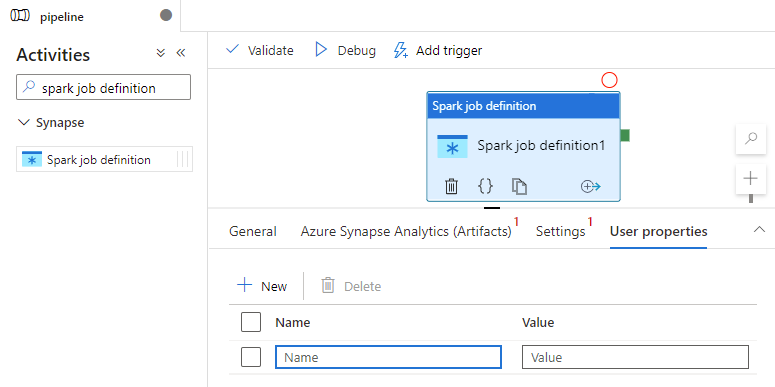

Nastavení plátna definice úlohy Apache Sparku

Pokud chcete v kanálu použít aktivitu definice úlohy Sparku pro Synapse, proveďte následující kroky:

Obecné nastavení

Vyhledejte definici úlohy Spark v podokně Aktivity kanálu a přetáhněte aktivitu definice úlohy Sparku pod Synapse na plátno kanálu.

Pokud ještě není vybraná, vyberte na plátně novou aktivitu definice úlohy Sparku.

Na kartě Obecné zadejte ukázku pro Název.

(Možnost) Můžete také zadat popis.

Časový limit: Maximální doba, po kterou může aktivita běžet. Výchozí hodnota je sedm dní, což je také maximální povolená doba. Formát je ve formátu D.HH:MM:SS.

Opakování: Maximální počet pokusů o opakování

Interval opakování: Počet sekund mezi jednotlivými pokusy o opakování.

Zabezpečený výstup: Při kontrole se výstup z aktivity nezachytí v protokolování.

Zabezpečený vstup: Při kontrole se vstup z aktivity nezachytí v protokolování.

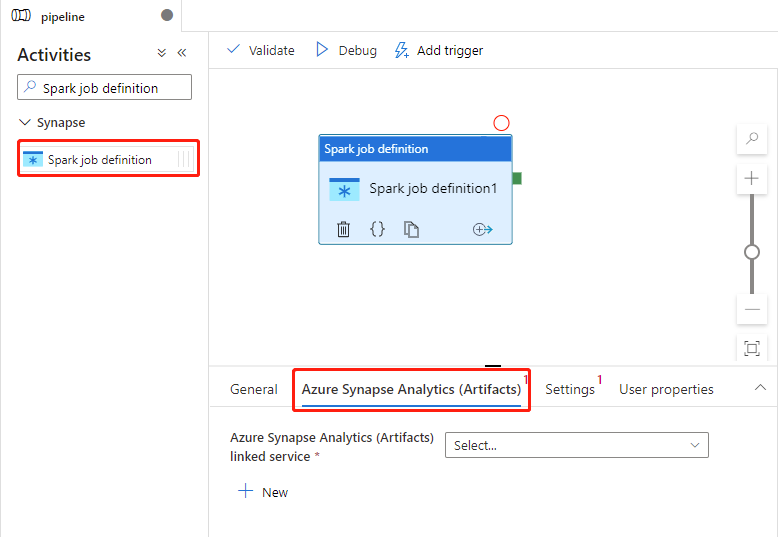

Nastavení Služby Azure Synapse Analytics (artefakty)

Pokud ještě není vybraná, vyberte na plátně novou aktivitu definice úlohy Sparku.

Výběrem karty Azure Synapse Analytics (Artefakty) vyberte nebo vytvořte novou propojenou službu Azure Synapse Analytics, která spustí aktivitu definice úlohy Sparku.

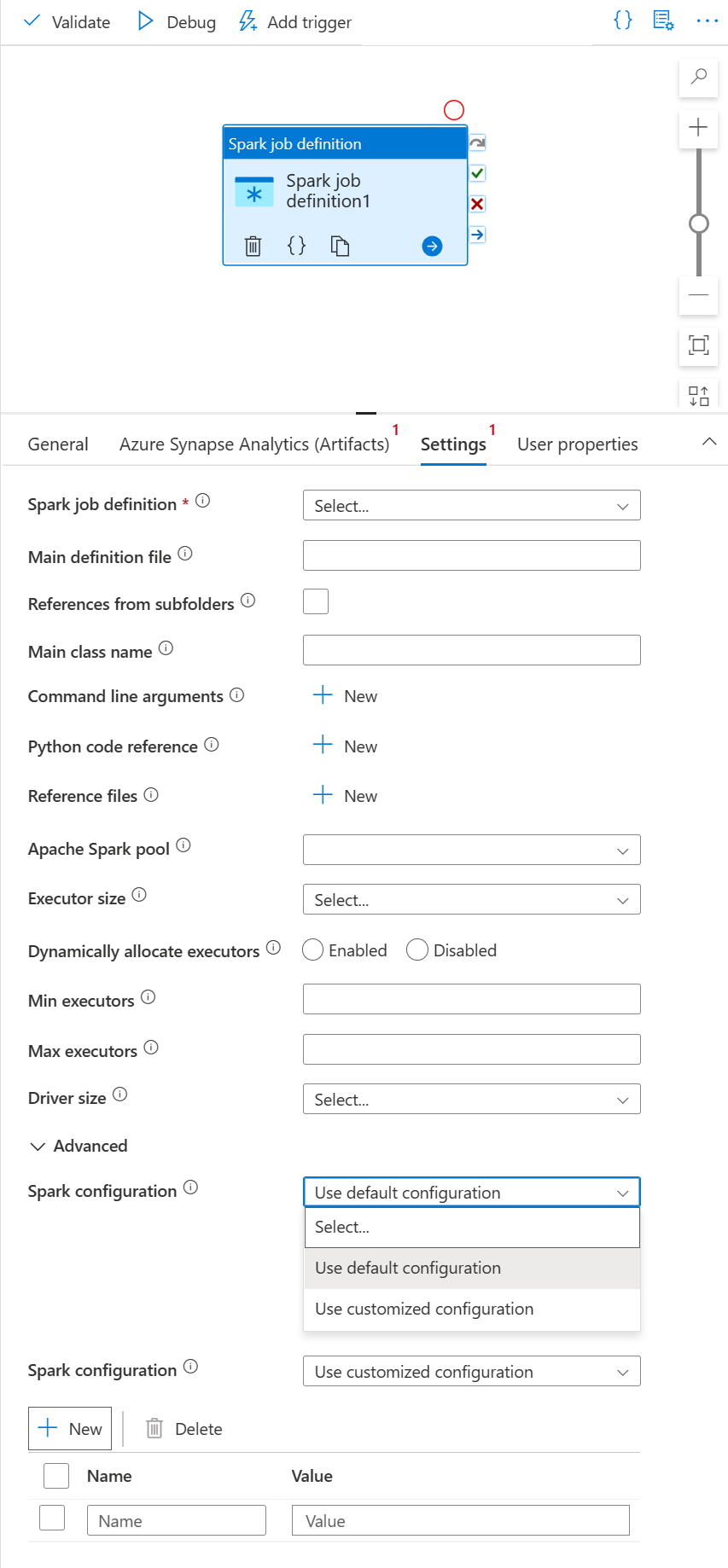

Karta Nastavení

Pokud ještě není vybraná, vyberte na plátně novou aktivitu definice úlohy Sparku.

Vyberte kartu Nastavení.

Rozbalte seznam definic úloh Sparku a v propojeném pracovním prostoru Azure Synapse Analytics můžete vybrat existující definici úlohy Apache Sparku.

(Volitelné) Můžete vyplnit informace o definici úlohy Apache Spark. Pokud jsou následující nastavení prázdná, použijí se ke spuštění nastavení samotné definice úlohy Spark. Pokud následující nastavení nejsou prázdná, tato nastavení nahradí nastavení samotné definice úlohy Spark.

Vlastnost Popis Hlavní definiční soubor Hlavní soubor použitý pro úlohu. V úložišti vyberte soubor PY/JAR/ZIP. Pokud chcete soubor nahrát do účtu úložiště, vyberte Nahrát soubor .

Ukázka:abfss://…/path/to/wordcount.jarOdkazy z podsložek Prohledání podsložek z kořenové složky hlavního definičního souboru se tyto soubory přidají jako referenční soubory. Složky s názvem "jars", "pyFiles", "files" nebo "archives" se naskenují a v názvu složek se rozlišují malá a velká písmena. Název hlavní třídy Plně kvalifikovaný identifikátor nebo hlavní třída, která je v hlavním definičním souboru.

Ukázka:WordCountArgumenty příkazového řádku Argumenty příkazového řádku můžete přidat kliknutím na tlačítko Nový . Je třeba poznamenat, že přidání argumentů příkazového řádku přepíše argumenty příkazového řádku definované definicí úlohy Spark.

Ukázka:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultFond Apache Sparku V seznamu můžete vybrat fond Apache Spark. Referenční informace k kódu Pythonu Další soubory kódu Pythonu používané pro referenci v hlavním definičním souboru.

Podporuje předávání souborů (.py, .py3, .zip) do vlastnosti "pyFiles". Přepíše vlastnost "pyFiles" definovanou v definici úlohy Sparku.Referenční soubory Další soubory používané pro referenci v hlavním definičním souboru. Fond Apache Sparku V seznamu můžete vybrat fond Apache Spark. Dynamicky přidělovat exekutory Toto nastavení se mapuje na vlastnost dynamického přidělení v konfiguraci Sparku pro přidělení exekutorů aplikací Sparku. Minimální exekutory Minimální počet exekutorů, které se mají přidělit v zadaném fondu Sparku pro úlohu. Maximální počet exekutorů Maximální počet exekutorů, které se mají přidělit v zadaném fondu Sparku pro úlohu. Velikost ovladače Počet jaderachch Konfigurace Sparku Zadejte hodnoty pro vlastnosti konfigurace Sparku uvedené v tématu: Konfigurace Sparku – Vlastnosti aplikace. Uživatelé můžou použít výchozí konfiguraci a přizpůsobenou konfiguraci.

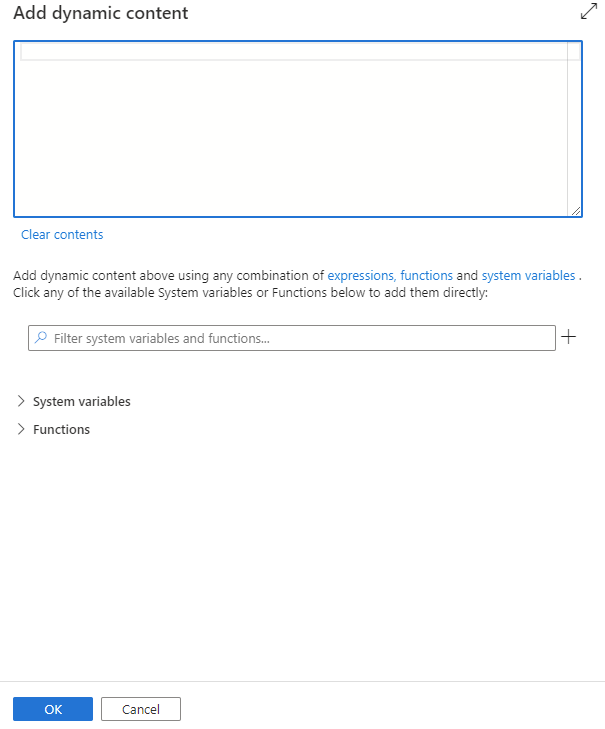

Dynamický obsah můžete přidat kliknutím na tlačítko Přidat dynamický obsah nebo stisknutím klávesové zkratky Alt+Shift+D. Na stránce Přidat dynamický obsah můžete k dynamickému obsahu použít libovolnou kombinaci výrazů, funkcí a systémových proměnných.

Karta Vlastnosti uživatele

Na tomto panelu můžete přidat vlastnosti aktivity definice úlohy Apache Spark.

Definice aktivity definice úlohy Sparku Azure Synapse

Tady je ukázková definice JSON aktivity poznámkového bloku Azure Synapse Analytics:

{

"activities": [

{

"name": "Spark job definition1",

"type": "SparkJob",

"dependsOn": [],

"policy": {

"timeout": "7.00:00:00",

"retry": 0,

"retryIntervalInSeconds": 30,

"secureOutput": false,

"secureInput": false

},

"typeProperties": {

"sparkJob": {

"referenceName": {

"value": "Spark job definition 1",

"type": "Expression"

},

"type": "SparkJobDefinitionReference"

}

},

"linkedServiceName": {

"referenceName": "AzureSynapseArtifacts1",

"type": "LinkedServiceReference"

}

}

],

}

Vlastnosti definice úlohy Azure Synapse Spark

Následující tabulka popisuje vlastnosti JSON použité v definici JSON:

| Vlastnost | Popis | Povinní účastníci |

|---|---|---|

| name | Název aktivity v kanálu | Ano |

| description | Text popisující, co aktivita dělá. | No |

| type | U aktivity definice úlohy Sparku Azure Synapse je typ aktivity SparkJob. | Ano |

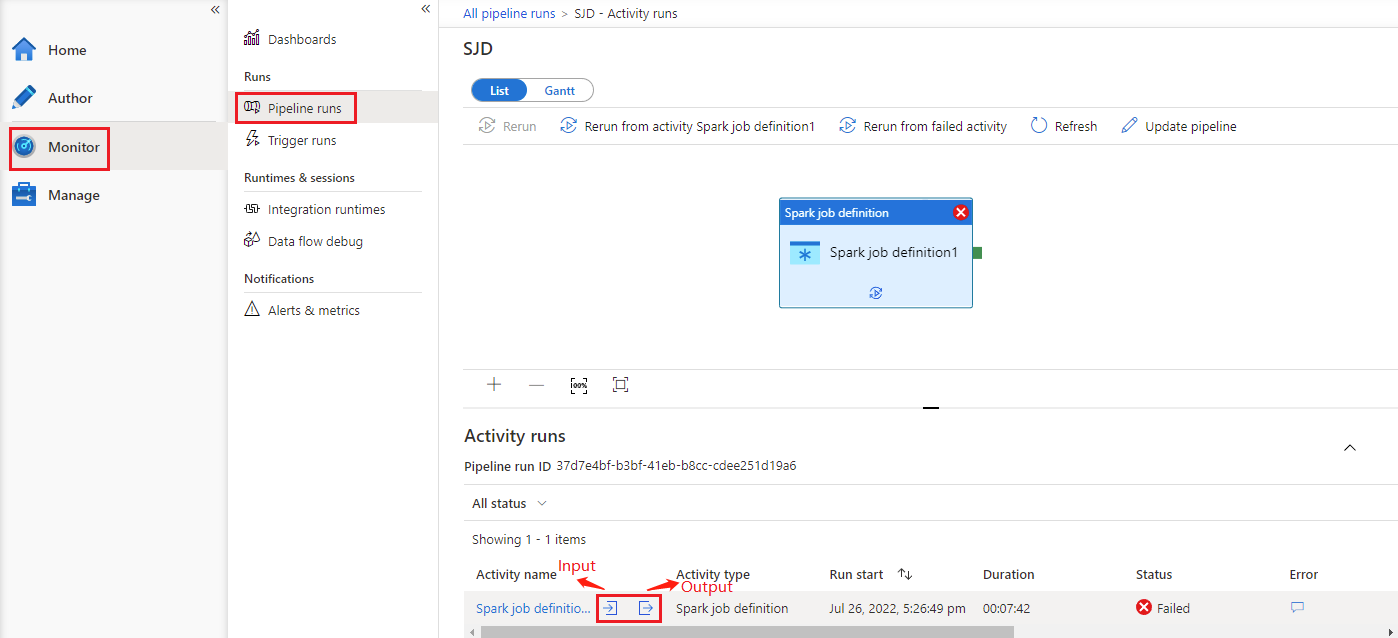

Zobrazení historie spuštění aktivity spuštění úlohy Azure Synapse Sparku

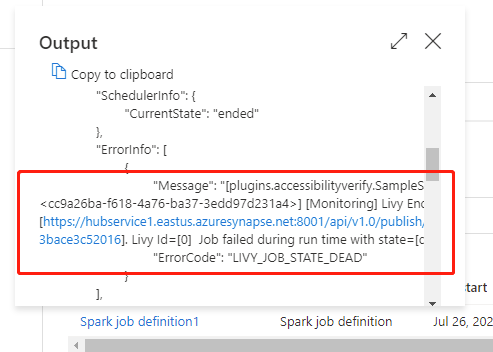

Na kartě Monitorování přejděte na spuštění kanálu. Zobrazí se kanál, který jste aktivovali. Otevřete kanál, který obsahuje aktivitu definice úlohy Azure Synapse Spark, abyste viděli historii spuštění.

Vstup nebo výstup aktivity poznámkového bloku můžete zobrazit výběrem vstupního nebo výstupního tlačítka. Pokud váš kanál selhal s chybou uživatele, výběrem výstupu zkontrolujte pole výsledků a prohlédněte si podrobné trasování chyb uživatele.