Srovnávací testy výkonu velkých objemů služby Azure NetApp Files pro Linux

Tento článek popisuje otestované možnosti výkonu jednoho velkého svazku Azure NetApp Files, protože se týká případů použití Linuxu. Testy prozkoumaly scénáře pro úlohy čtení a zápisu se škálováním na více instancí i úloh, které zahrnují jeden a mnoho virtuálních počítačů. Znalost obálky výkonu velkých svazků vám pomůže usnadnit změnu velikosti svazku.

Souhrn testování

Funkce velkých svazků Azure NetApp Files nabízí tři úrovně služeb, z nichž každá má omezení propustnosti. Úrovně služeb je možné vertikálně navýšit nebo snížit nedisruptivně, protože se mění vaše požadavky na výkon.

- Ultra servisní úroveň: 12 800 MiB/s

- Úroveň služby Premium: 6 400 MiB/s

- Standardní úroveň služby: 1 600 MiB/s

Úroveň služby Ultra byla použita v těchto testech.

Sekvenční zápisy: 100 % sekvenčních zápisů v těchto srovnávacích testech max. přibližně 8 500 MiB za sekundu. (Maximální propustnost jednoho velkého svazku je ve službě omezena na 12 800 MiB/s, takže je možná větší možná propustnost.)

Sekvenční čtení: 100% sekvenční čtení v těchto srovnávacích testech dosáhne maximálního počtu přibližně 12 761 MiB/sekund. (Propustnost jednoho velkého svazku je omezena na 12 800 MiB za sekundu. Tento výsledek se v tuto chvíli blíží maximální dosažitelné propustnosti.)

Náhodné vstupně-výstupní operace: Stejný velký objem poskytuje více než 700 000 operací za sekundu.

Úlohy náročné na metadata jsou výhodné pro velké svazky Azure NetApp File kvůli zvýšenému paralelismu velkého svazku. Výhody výkonu jsou patrné u úloh náročných při vytváření souborů, zrušení propojení a přejmenování souborů jako typické u aplikací VCS a úloh EDA, u kterých je k dispozici vysoký počet souborů. Další informace o výkonu úloh s vysokými metadaty najdete v tématu Výhody používání služby Azure NetApp Files pro automatizaci elektronického návrhu.

K řízení těchto výsledků testů se použilo FIO, syntetický generátor úloh navržený jako zátěžový test úložiště. V zásadě existují dva modely testování výkonu úložiště:

- Výpočetní prostředky se škálováním na více instancí, které odkazují na použití několika virtuálních počítačů k vygenerování maximálního možného zatížení na jednom svazku Azure NetApp Files.

- Vertikálně navyšte kapacitu výpočetních prostředků, která označuje použití velkého virtuálního počítače k otestování horních hranic jednoho klienta na jednom svazku Azure NetApp Files.

Test škálování na více systémů Linux

Testy zaznamenaly prahové hodnoty výkonu jednoho velkého svazku ve velkém měřítku a prováděly se s následující konfigurací:

| Komponenta | Konfigurace |

|---|---|

| Velikost virtuálního počítače Azure | E32s_v5 |

| Omezení šířky pásma výchozího přenosu dat virtuálního počítače Azure | 2000MiB/s (2GiB/s) |

| Operační systém | RHEL 8.4 |

| Velikost velkého svazku | 101 TiB Ultra (propustnost 12 800 MiB/s) |

| Možnosti připojení | hard,rsize=65536,wsize=65536,vers=3 POZNÁMKA: Použití 262144 i 65536 mělo podobné výsledky výkonu. |

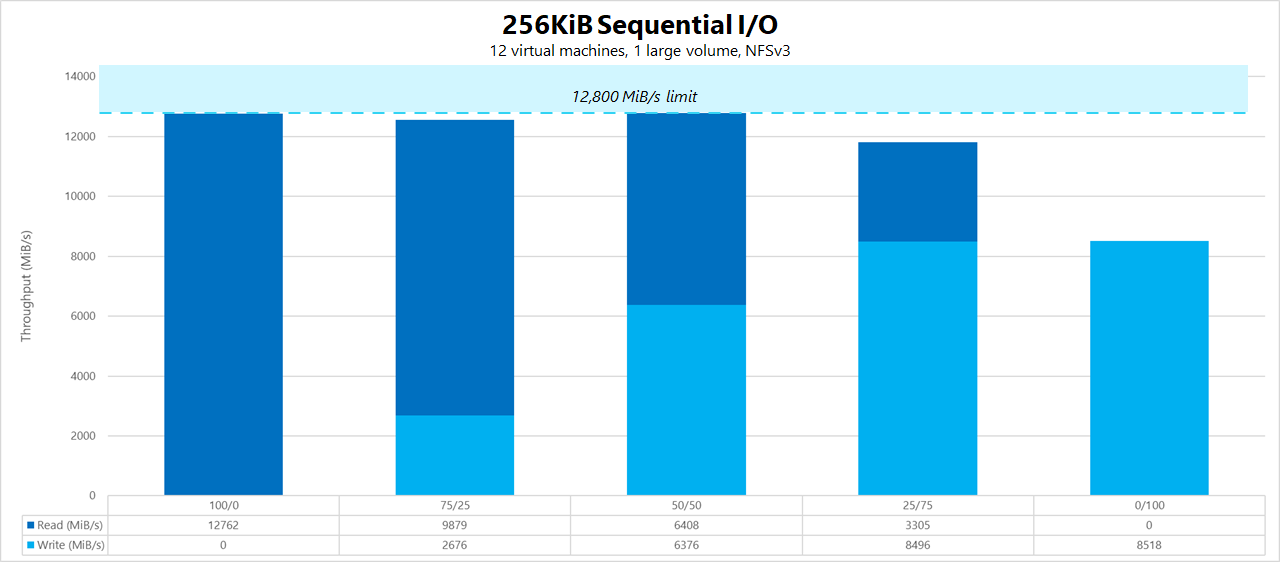

256-KiB sekvenčních úloh (MiB/s)

Graf představuje sekvenční úlohu 256 KiB pomocí 12 virtuálních počítačů, které čtou a zapisují do jednoho velkého svazku pomocí pracovní sady 1 TiB. Graf ukazuje, že jeden velký svazek Azure NetApp Files dokáže zpracovat přibližně 8 518 MiB/s čistých sekvenčních zápisů a 12 761 MiB/s čistě sekvenční čtení.

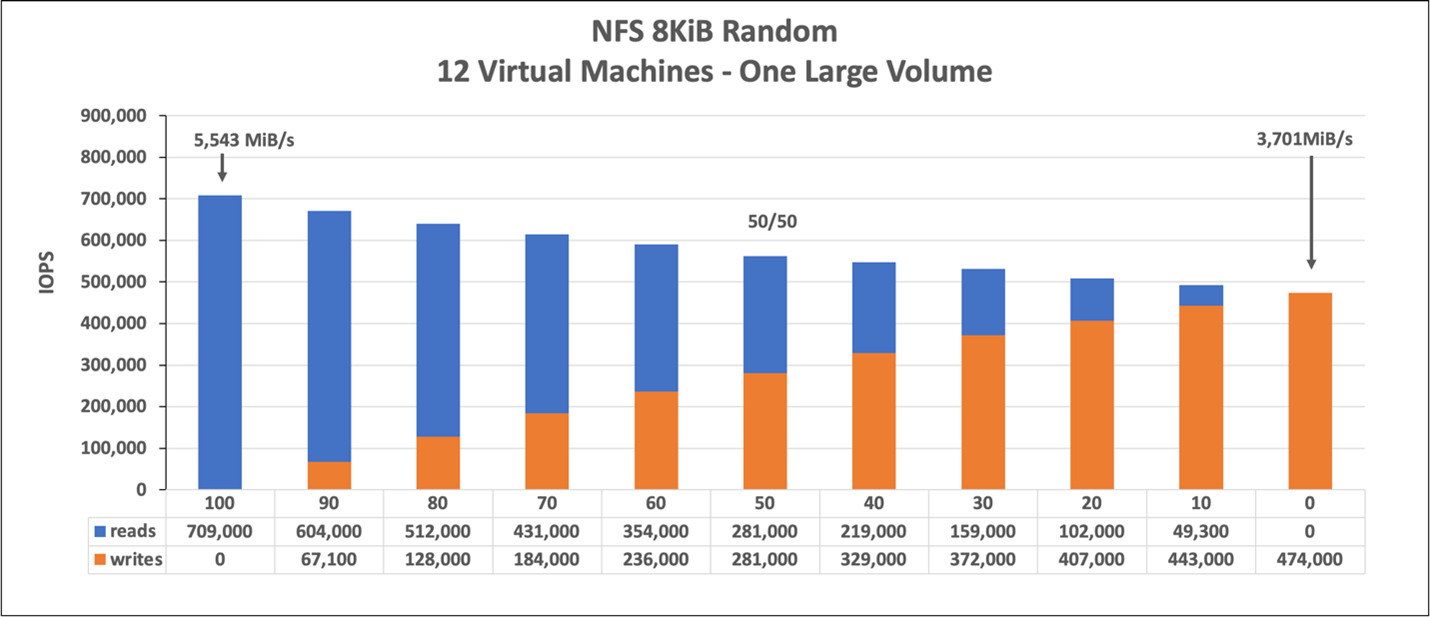

Náhodná úloha 8 KiB (IOPS)

Graf představuje náhodnou úlohu 8 KiB a pracovní sadu 1 TiB. Graf ukazuje, že velký svazek Azure NetApp Files dokáže zpracovat přibližně 474 000 čistých náhodných zápisů a přibližně 709 000 čistých náhodných čtení.

Testy vertikálního navýšení kapacity Linuxu

Zatímco testy se škálováním na více instancí jsou navržené tak, aby zjistily limity jednoho velkého objemu, testy vertikálního navýšení kapacity jsou navržené tak, aby našly horní limity jedné instance na uvedený velký objem. Azure u svých virtuálních počítačů umístí omezení výchozího přenosu dat sítě; pro síťové připojené úložiště znamená, že šířka pásma zápisu je omezena na virtuální počítač. Tyto testy vertikálního navýšení kapacity demonstrují možnosti s ohledem na velký dostupný limit šířky pásma a s dostatečnými procesory pro řízení uvedených úloh.

Testy v této části byly spuštěny s následující konfigurací:

| Komponenta | Konfigurace |

|---|---|

| Velikost virtuálního počítače Azure | E104id_v5 |

| Omezení šířky pásma výchozího přenosu dat virtuálního počítače Azure | 12 500MiB/s (12.2GiB/s) |

| Operační systém | RHEL 8.4 |

| Velikost velkého svazku | 101 TiB Ultra (propustnost 12 800 MiB/s) |

| Možnosti připojení | hard,rsize=65536,wsize=65536,vers=3 POZNÁMKA: Použití 262144 i 65536 mělo podobné výsledky výkonu |

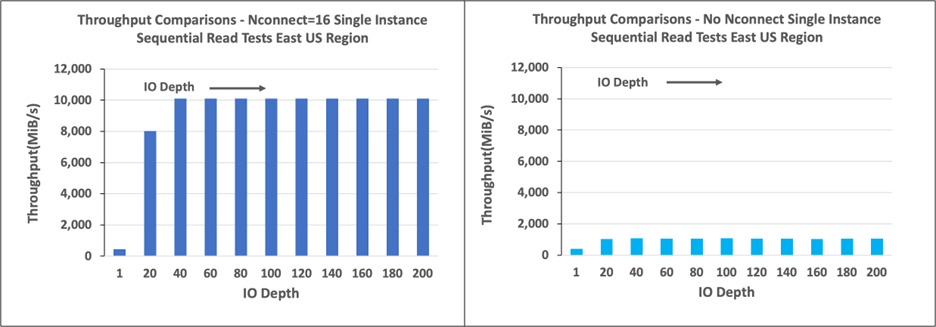

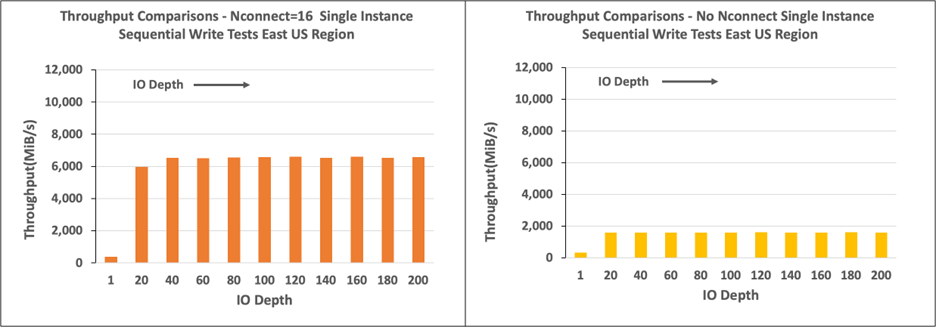

Grafy v této části zobrazují výsledky pro možnost nconnect připojení na straně klienta s NFSv3. Další informace najdete v tématu Osvědčené postupy pro možnosti připojení systému souborů NFS pro Linux pro Azure NetApp File.

Následující grafy porovnávají výhody nconnect s připojeným svazkem NFS bez nconnect. V testech fio vygenerovalo úlohu z jedné instance E104id-v5 v oblasti Azure – východ pomocí sekvenční úlohy 64 KiB; Byla použita velikost 256 V/0, což je největší vstupně-výstupní velikost doporučená službou Azure NetApp Files, výsledkem jsou srovnatelná čísla výkonu. Další informace najdete v tématech rsize a wsize.

Propustnost čtení v Linuxu

Následující grafy znázorňují 256-KiB sekvenční čtení přibližně 10 000 iB/s s , nconnectcož je přibližně desetkrát dosažená propustnost bez nconnect.

Mějte na paměti, že 10 000 MiB/s je přibližně rychlost řádků síťové karty 100 Gb/s připojená k E104id_v5.

Propustnost zápisu v Linuxu

Následující grafy zobrazují sekvenční zápisy. Použití nconnect poskytuje pozorovatelné výhody pro sekvenční zápisy s rychlostí 6 600 MiB/s, zhruba čtyřikrát od přípojných zařízení bez nconnect.

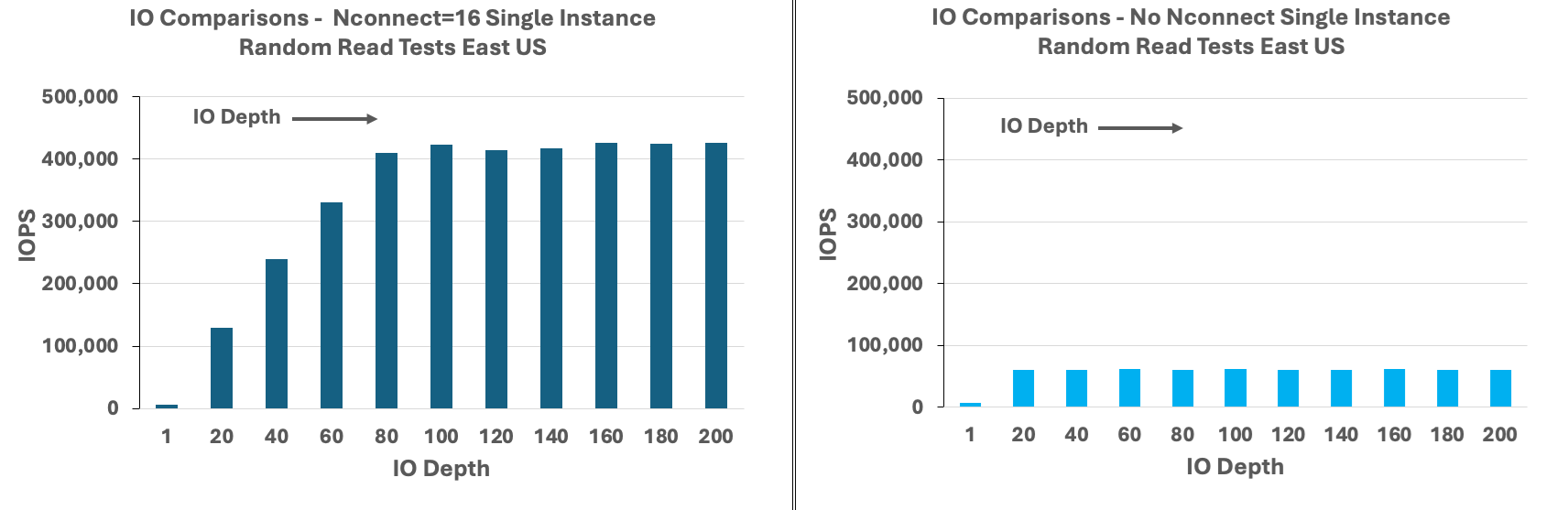

IOPS pro čtení v Linuxu

Následující grafy ukazují 8-KiB náhodné čtení ~426 000 čtení IOPS s nconnectpřibližně sedmkrát pozorovaným bez nconnect.

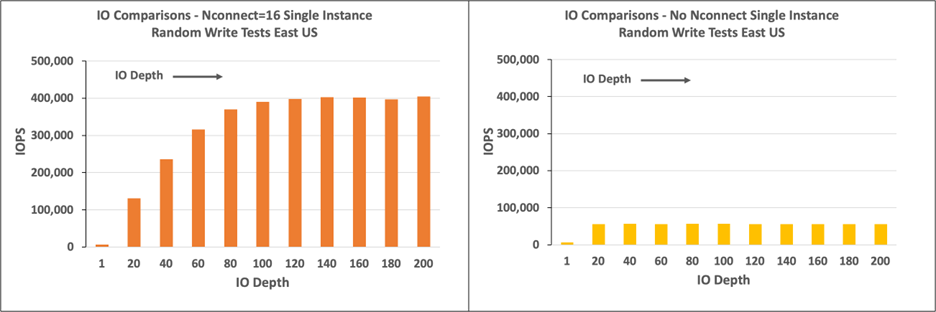

IOPS zápisu v Linuxu

Následující grafy ukazují 8-KiB náhodné zápisy o ~405 000 zápisu IOPS s nconnectpřibližně 7,2násobkem toho, co je pozorováno bez nconnect.