Ukázky pravidel shromažďování dat (DCR) ve službě Azure Monitor

Tento článek obsahuje ukázková pravidla shromažďování dat (DCR) pro běžné scénáře shromažďování dat ve službě Azure Monitor. Tyto definice DCR můžete upravit podle potřeby pro vaše prostředí a vytvořit řadič domény pomocí pokynů v části Vytvoření nebo úprava pravidla shromažďování dat. Můžete také použít a zkombinovat základní strategie v těchto ukázkách k vytvoření řadičů domény pro jiné scénáře.

Tyto ukázky vyžadují znalost struktury DCR, jak je popsáno ve struktuře pravidla shromažďování dat ve službě Azure Monitor. Několik se dá nakonfigurovat pomocí webu Azure Portal bez podrobných znalostí struktury DCR. Tyto ukázky použijte v případě, že potřebujete pracovat se samotnou definicí DCR, abyste mohli provádět pokročilejší konfigurace nebo automatizovat vytváření řadičů domény.

Každá z těchto ukázek se zaměřuje na konkrétní zdroj dat, i když v jednom dcR můžete kombinovat více zdrojů dat různých typů. Zahrňte tok dat pro každý z nich, aby se data odesílala do příslušného cíle. Neexistuje žádný funkční rozdíl mezi kombinováním více zdrojů dat v jednom řadiči domény nebo vytvořením samostatných řadičů domény pro každý zdroj dat. Volba závisí na vašich požadavcích na správu a monitorování shromažďování dat.

Poznámka:

Tyto ukázky ukazují v tomto článku zdrojový kód JSON potřebný k vytvoření DCR. Po vytvoření bude dcR mít další vlastnosti, jak je popsáno ve struktuře pravidla shromažďování dat ve službě Azure Monitor.

DcRs pro agenta Azure Monitoru

Agent Služby Azure Monitor běží na virtuálních počítačích, škálovacích sadách virtuálních počítačů a clusterech Kubernetes. Podporuje přehledy virtuálních počítačů a přehledy kontejnerů a podporuje různé scénáře shromažďování dat pro virtuální počítače popsané v shromažďování dat agenta služby Azure Monitor.

Následující ukázky ukazují řadiče domény pro shromažďování různých druhů dat pomocí agenta Služby Azure Monitor.

Události systému Windows

Žádosti o přenos dat pro události Windows používají windowsEventLogs zdroj dat s příchozím streamem Microsoft-Event . Schéma tohoto datového proudu je známé, takže nemusí být definováno v oddílu dataSources . Události, které se mají shromažďovat, jsou zadány ve xPathQueries vlastnosti. Další podrobnosti o použití XPaths k filtrování konkrétních dat, která chcete shromáždit, najdete v tématu Shromažďování událostí Windows pomocí agenta Azure Monitoru. Abyste mohli začít, můžete pomocí pokynů v tomto článku vytvořit DCR pomocí webu Azure Portal a pak zkontrolovat JSON s využitím pokynů v definici DCR.

Do vlastnosti počítaných sloupců a k dalšímu filtrování dat můžete přidat transformaci dataFlows , měli byste ale pomocí XPaths filtrovat data v agentu co nejvíce z hlediska efektivity a vyhnout se potenciálním poplatkům za příjem dat.

Následující ukázkový řadič domény provádí následující akce:

- Shromažďuje události aplikací a systému Windows s úrovní upozornění, chyb nebo kritických událostí.

- Odesílá data do tabulky událostí v pracovním prostoru.

- Používá jednoduchou transformaci,

sourcekterá neprovádí žádné změny příchozích dat.

{

"location": "eastus",

"properties": {

"dataSources": {

"windowsEventLogs": [

{

"name": "eventLogsDataSource",

"streams": [

"Microsoft-Event"

],

"xPathQueries": [

"System!*[System[(Level = 1 or Level = 2 or Level = 3)]]",

"Application!*[System[(Level = 1 or Level = 2 or Level = 3)]]"

]

}

]

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "centralWorkspace"

}

]

},

"dataFlows": [

{

"streams": [

"Microsoft-Event"

],

"destinations": [

"centralWorkspace"

],

"transformKql": "source",

"outputStream": "Microsoft-Event"

}

]

}

}

Události protokolu syslog

Žádosti o přenos dat pro události Syslogu používají syslog zdroj dat s příchozím Microsoft-Syslog streamem. Schéma tohoto datového proudu je známé, takže nemusí být definováno v oddílu dataSources . Události, které se mají shromáždit, jsou zadané v objektech facilityNames a logLevels vlastnostech. Další podrobnosti najdete v tématu Shromažďování událostí Syslogu pomocí agenta služby Azure Monitor. Abyste mohli začít, můžete pomocí pokynů v tomto článku vytvořit DCR pomocí webu Azure Portal a pak zkontrolovat JSON s využitím pokynů v definici DCR.

Do vlastnosti můžete přidat transformaci dataFlows pro další funkce a další filtrování dat, ale měli byste použít facilityNames a logLevels filtrovat co nejvíce, abyste se vyhnuli potenciálním poplatkům za příjem dat.

Následující ukázkový řadič domény provádí následující akce:

- Shromažďuje všechny události ze

cronzařízení. WarningShromažďuje a vyšší události zsyslogadaemonzařízení.- Odesílá data do tabulky Syslog v pracovním prostoru.

- Používá jednoduchou transformaci,

sourcekterá neprovádí žádné změny příchozích dat.

{

"location": "eastus",

"properties": {

"dataSources": {

"syslog": [

{

"name": "cronSyslog",

"streams": [

"Microsoft-Syslog"

],

"facilityNames": [

"cron"

],

"logLevels": [

"Debug",

"Info",

"Notice",

"Warning",

"Error",

"Critical",

"Alert",

"Emergency"

]

},

{

"name": "syslogBase",

"streams": [

"Microsoft-Syslog"

],

"facilityNames": [

"daemon",

"syslog"

],

"logLevels": [

"Warning",

"Error",

"Critical",

"Alert",

"Emergency"

]

}

]

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "centralWorkspace"

}

]

},

"dataFlows": [

{

"streams": [

"Microsoft-Syslog"

],

"destinations": [

"centralWorkspace"

],

"transformKql": "source",

"outputStream": "Microsoft-Syslog"

}

]

}

}

Čítače výkonu

Řadiče domény pro data výkonu performanceCounters používají zdroj dat s příchozími Microsoft-InsightsMetrics a Microsoft-Perf streamy. Microsoft-InsightsMetrics slouží k odesílání dat do metrik služby Azure Monitor, zatímco Microsoft-Perf slouží k odesílání dat do pracovního prostoru služby Log Analytics. Pokud odesíláte data o výkonu do obou cílů, můžete do dcR zahrnout oba zdroje dat. Schémata těchto datových proudů jsou známá, takže není nutné je v části definovat dataSources .

Čítače výkonu, které se mají shromáždit, jsou zadány counterSpecifiers ve vlastnosti. Další podrobnosti najdete v tématu Shromažďování čítačů výkonu pomocí agenta služby Azure Monitor. Abyste mohli začít, můžete pomocí pokynů v tomto článku vytvořit DCR pomocí webu Azure Portal a pak zkontrolovat JSON s využitím pokynů v definici DCR.

Do vlastnosti můžete přidat transformaci dataFlows pro Microsoft-Perf další funkce a další filtrování dat, ale měli byste vybrat pouze čítače, které counterSpecifiers požadujete, aby se zabránilo potenciálním poplatkům za příjem dat.

Následující ukázkový řadič domény provádí následující akce:

- Shromažďuje sadu čítačů výkonu každých 60 sekund a další sadu každých 30 sekund.

- Odesílá data do metrik Služby Azure Monitor a do pracovního prostoru služby Log Analytics.

- Používá jednoduchou transformaci,

sourcekterá neprovádí žádné změny příchozích dat.

{

"location": "eastus",

"properties": {

"dataSources": {

"performanceCounters": [

{

"name": "perfCounterDataSource60",

"streams": [

"Microsoft-Perf",

"Microsoft-InsightsMetrics"

],

"samplingFrequencyInSeconds": 60,

"counterSpecifiers": [

"\\Processor(_Total)\\% Processor Time",

"\\Memory\\Committed Bytes",

"\\LogicalDisk(_Total)\\Free Megabytes",

"\\PhysicalDisk(_Total)\\Avg. Disk Queue Length"

]

},

{

"name": "perfCounterDataSource30",

"streams": [

"Microsoft-Perf"

],

"samplingFrequencyInSeconds": 30,

"counterSpecifiers": [

"\\Process(_Total)\\Thread Count"

]

}

]

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "centralWorkspace"

}

],

"azureMonitorMetrics":

{

"name": "azureMonitorMetrics-default"

}

},

"dataFlows": [

{

"streams": [

"Microsoft-Perf"

],

"destinations": [

"centralWorkspace"

],

"transformKql": "source",

"outputStream": "Microsoft-Perf"

},

{

"streams": [

"Microsoft-Perf"

],

"destinations": [

"azureMonitorMetrics-default"

],

"outputStream": "Microsoft-InsightsMetrics"

}

]

}

}

Textové protokoly

Řadiče domény pro textové protokoly mají logfiles zdroj dat, který obsahuje podrobnosti o souborech protokolu, které by měl agent shromažďovat. To zahrnuje název datového proudu, který musí být definován ve streamDeclarations sloupcích příchozích dat. Toto je aktuálně nastavený seznam, jak je popsáno v části Shromažďování protokolů z textového souboru pomocí agenta služby Azure Monitor.

Přidejte do dataFlows vlastnosti transformaci, která vyfiltruje záznamy, které nechcete shromažďovat, a formátovat data tak, aby odpovídala schématu cílové tabulky. Běžným scénářem je parsování souboru protokolu s oddělovači do více sloupců, jak je popsáno v souborech protokolu s oddělovači.

Následující ukázkový řadič domény provádí následující akce:

- Shromažďuje položky ze všech souborů s příponou

.txtvec:\logssložce počítače agenta. - Pomocí transformace rozdělí příchozí data do sloupců na základě oddělovače čárky (

,). Tato transformace je specifická pro formát souboru protokolu a musí být upravena pro soubory protokolu s jinými formáty. - Odešle shromážděné protokoly do vlastní tabulky s názvem

MyTable_CL. Tato tabulka už musí existovat a mít výstup sloupců podle transformace. FilePathShromažďuje textový protokol,Computerjak je popsáno v příchozím datovém proudu. Tyto sloupce musí existovat také v cílové tabulce.

{

"location": "eastus",

"properties": {

"dataCollectionEndpointId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.Insights/dataCollectionEndpoints/my-dce",

"streamDeclarations": {

"Custom-MyLogFileFormat": {

"columns": [

{

"name": "TimeGenerated",

"type": "datetime"

},

{

"name": "RawData",

"type": "string"

},

{

"name": "FilePath",

"type": "string"

},

{

"name": "Computer",

"type": "string"

}

]

}

},

"dataSources": {

"logFiles": [

{

"streams": [

"Custom-MyLogFileFormat"

],

"filePatterns": [

"C:\\logs\\*.txt"

],

"format": "text",

"settings": {

"text": {

"recordStartTimestampFormat": "ISO 8601"

}

},

"name": "myLogFileFormat-Windows"

}

]

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "MyDestination"

}

]

},

"dataFlows": [

{

"streams": [

"Custom-MyLogFileFormat"

],

"destinations": [

"MyDestination"

],

"transformKql": "source | project d = split(RawData,\",\") | project TimeGenerated=todatetime(d[0]), Code=toint(d[1]), Severity=tostring(d[2]), Module=tostring(d[3]), Message=tostring(d[4])",

"outputStream": "Custom-MyTable_CL"

}

]

}

}

Protokoly JSON

Řadiče domény pro protokoly Json mají logfiles zdroj dat, který obsahuje podrobnosti o souborech protokolu, které by měl agent shromažďovat. To zahrnuje název datového proudu, který musí být definován ve streamDeclarations sloupcích příchozích dat. Další podrobnosti najdete v tématu Shromažďování protokolů ze souboru JSON pomocí agenta služby Azure Monitor.

Přidejte do dataFlows vlastnosti transformaci, která vyfiltruje záznamy, které nechcete shromažďovat, a formátovat data tak, aby odpovídala schématu cílové tabulky.

Následující ukázkový řadič domény provádí následující akce:

- Shromažďuje položky ze všech souborů s příponou

.jsonvec:\logssložce počítače agenta. Soubor musí být naformátovaný ve formátu JSON a musí obsahovat sloupce uvedené v deklaraci datového proudu. - Odešle shromážděné protokoly do vlastní tabulky s názvem

MyTable_CL. Tato tabulka již musí existovat a musí mít stejné sloupce jako příchozí datový proud. Pokud se sloupce neshoduje, musíte upravit transformaci vetransformKqlvlastnosti tak, aby formátovala data pro cílovou tabulku.

{

"location": "eastus",

"properties": {

"dataCollectionEndpointId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.Insights/dataCollectionEndpoints/my-dce",

"streamDeclarations": {

"Custom-Json-stream": {

"columns": [

{

"name": "TimeGenerated",

"type": "datetime"

},

{

"name": "FilePath",

"type": "string"

},

{

"name": "Code",

"type": "int"

},

{

"name": "Module",

"type": "string"

},

{

"name": "Message",

"type": "string"

}

]

}

},

"dataSources": {

"logFiles": [

{

"streams": [

"Custom-Json-stream"

],

"filePatterns": [

"C:\\logs\\*.json"

],

"format": "json",

"name": "MyJsonFile"

}

]

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "MyDestination"

}

]

},

"dataFlows": [

{

"streams": [

"Custom-Json-stream"

],

"destinations": [

"MyDestination"

],

"transformKql": "source",

"outputStream": "Custom-MyTable_CL"

}

]

}

}

Odesílání dat do služby Event Hubs nebo úložiště

Řadiče domény odesílající data do center událostí nebo účtů úložiště používají stejné zdroje dat jako jiné řadiče domény, které shromažďují data pomocí agenta služby Azure Monitor (AMA), ale mají jeden nebo několik následujících cílů. Další podrobnosti najdete v tématu Odesílání dat do služby Event Hubs a úložiště (Preview ).

eventHubsDirectstorageBlobsDirectstorageTablesDirect

Poznámka:

Řadiče domény, které odesílají data do center událostí nebo účtů úložiště, musí mít "kind": "AgentDirectToStore"

Následující ukázkový řadič domény provádí následující akce:

- Shromažďuje čítače výkonu a události Windows z počítačů s Windows pomocí agenta služby Azure Monitor (AMA).

- Odešle data do centra událostí, úložiště objektů blob a úložiště tabulek.

{

"location": "eastus",

"kind": "AgentDirectToStore",

"properties": {

"dataSources": {

"performanceCounters": [

{

"streams": [

"Microsoft-Perf"

],

"samplingFrequencyInSeconds": 10,

"counterSpecifiers": [

"\\Process(_Total)\\Working Set - Private",

"\\Memory\\% Committed Bytes In Use",

"\\LogicalDisk(_Total)\\% Free Space",

"\\Network Interface(*)\\Bytes Total/sec"

],

"name": "perfCounterDataSource"

}

],

"windowsEventLogs": [

{

"streams": [

"Microsoft-Event"

],

"xPathQueries": [

"Application!*[System[(Level=2)]]",

"System!*[System[(Level=2)]]"

],

"name": "eventLogsDataSource"

}

]

},

"destinations": {

"eventHubsDirect": [

{

"eventHubResourceId": "/subscriptions/71b36fb6-4fe4-4664-9a7b-245dc62f2930/resourceGroups/my-resource-group/providers/Microsoft.EventHub/namespaces/my-eventhub-namespace/eventhubs/my-eventhub",

"name": "myEh"

}

],

"storageBlobsDirect": [

{

"storageAccountResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourcegroups/my-resource-group/providers/Microsoft.Storage/storageAccounts/mystorageaccount",

"containerName": "myperfblob",

"name": "PerfBlob"

},

{

"storageAccountResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourcegroups/my-resource-group/providers/Microsoft.Storage/storageAccounts/mystorageaccount",

"containerName": "myeventblob",

"name": "EventBlob"

}

],

"storageTablesDirect": [

{

"storageAccountResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourcegroups/my-resource-group/providers/Microsoft.Storage/storageAccounts/mystorageaccount",

"containerName": "myperftable",

"name": "PerfTable"

},

{

"storageAccountResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourcegroups/my-resource-group/providers/Microsoft.Storage/storageAccounts/mystorageaccount",

"containerName": "mymyeventtable",

"name": "EventTable"

}

]

},

"dataFlows": [

{

"streams": [

"Microsoft-Perf"

],

"destinations": [

"myEh",

"PerfBlob",

"PerfTable"

]

},

{

"streams": [

"Microsoft-Event"

],

"destinations": [

"myEh",

"EventBlob",

"EventTable"

]

},

]

}

}

Rozhraní API pro příjem protokolů

Řadiče domény pro rozhraní API pro příjem protokolů musí definovat schéma příchozího datového proudu v streamDeclarations části definice DCR. Příchozí data musí být naformátovaná ve formátu JSON se schématem odpovídajícím sloupcům v této definici. Pokud toto schéma odpovídá schématu cílové tabulky, nevyžaduje se žádná transformace. Pokud se schémata neshodují, musíte do dataFlows vlastnosti přidat transformaci, aby se data naformátovaly. Další podrobnosti najdete v rozhraní API pro příjem protokolů ve službě Azure Monitor .

Níže uvedený ukázkový řadič domény obsahuje následující podrobnosti:

- Odesílá data do tabulky volané

MyTable_CLv pracovním prostoru s názvemmy-workspace. Před instalací tohoto řadiče domény byste museli vytvořit tabulku s následujícími sloupci:- TimeGenerated

- Počítač

- AdditionalContext

- ExtendedColumn (definovaný v transformaci)

- Použije transformaci na příchozí data a naformátuje data pro cílovou tabulku.

Důležité

Tato ukázka neobsahuje dataCollectionEndpointId vlastnost, protože se vytvoří automaticky při vytvoření řadiče domény. Potřebujete hodnotu této vlastnosti, protože se jedná o adresu URL, do které bude aplikace odesílat data. Řadič domény musí mít kind:Direct vytvořenou tuto vlastnost. Další podrobnosti najdete v tématu Vlastnosti .

{

"location": "eastus",

"kind": "Direct",

"properties": {

"streamDeclarations": {

"Custom-MyTable": {

"columns": [

{

"name": "Time",

"type": "datetime"

},

{

"name": "Computer",

"type": "string"

},

{

"name": "AdditionalContext",

"type": "string"

}

]

}

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/cefingestion/providers/microsoft.operationalinsights/workspaces/my-workspace",

"name": "LogAnalyticsDest"

}

]

},

"dataFlows": [

{

"streams": [

"Custom-MyTable"

],

"destinations": [

"LogAnalyticsDest"

],

"transformKql": "source | extend jsonContext = parse_json(AdditionalContext) | project TimeGenerated = Time, Computer, AdditionalContext = jsonContext, ExtendedColumn=tostring(jsonContext.CounterName)",

"outputStream": "Custom-MyTable_CL"

}

]

}

}

DcR transformace pracovního prostoru

Transformační řadiče domény pracovního prostoru mají prázdnou datasources část, protože transformace se použijí na všechna data odesílaná do podporovaných tabulek v pracovním prostoru. Musí obsahovat jednu a pouze položku pro workspaceResourceId a položku dataFlows pro každou tabulku s transformací. Musí mít "kind": "WorkspaceTransforms"také .

Níže uvedený ukázkový řadič domény obsahuje následující podrobnosti:

- Transformace tabulky

LAQueryLogs, která filtruje dotazy samotné tabulky, a přidá sloupec s názvem pracovního prostoru. - Transformace tabulky

Event, která filtruje události informace a odebereParameterXmlsloupec. To platí jenom pro data přicházející z zastaralého agenta Log Analytics, nikoli agenta Azure Monitoru, jak je vysvětleno v dcR transformace pracovního prostoru.

{

"kind": "WorkspaceTransforms",

"location": "eastus",

"properties": {

"dataSources": {},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "clv2ws1"

}

]

},

"dataFlows": [

{

"streams": [

"Microsoft-Table-LAQueryLogs"

],

"destinations": [

"clv2ws1"

],

"transformKql": "source | where QueryText !contains 'LAQueryLogs' | extend Context = parse_json(RequestContext) | extend Workspace_CF = tostring(Context['workspaces'][0]) | project-away RequestContext, Context"

},

{

"streams": [

"Microsoft-Table-Event"

],

"destinations": [

"clv2ws1"

],

"transformKql": "source | where EventLevelName in ('Error', 'Critical', 'Warning') | project-away ParameterXml"

}

]

}

}

Odeslání dat do více tabulek

Existuje několik důvodů, proč můžete chtít odesílat data z jednoho zdroje dat do více tabulek ve stejném pracovním prostoru služby Log Analytics, včetně následujících:

- Ušetřete náklady na příjem dat odesláním záznamů používaných pro občasné řešení potíží do základní tabulky protokolů.

- Odesílání záznamů nebo sloupců s citlivými daty do tabulky s různými oprávněními nebo nastavením uchovávání informací

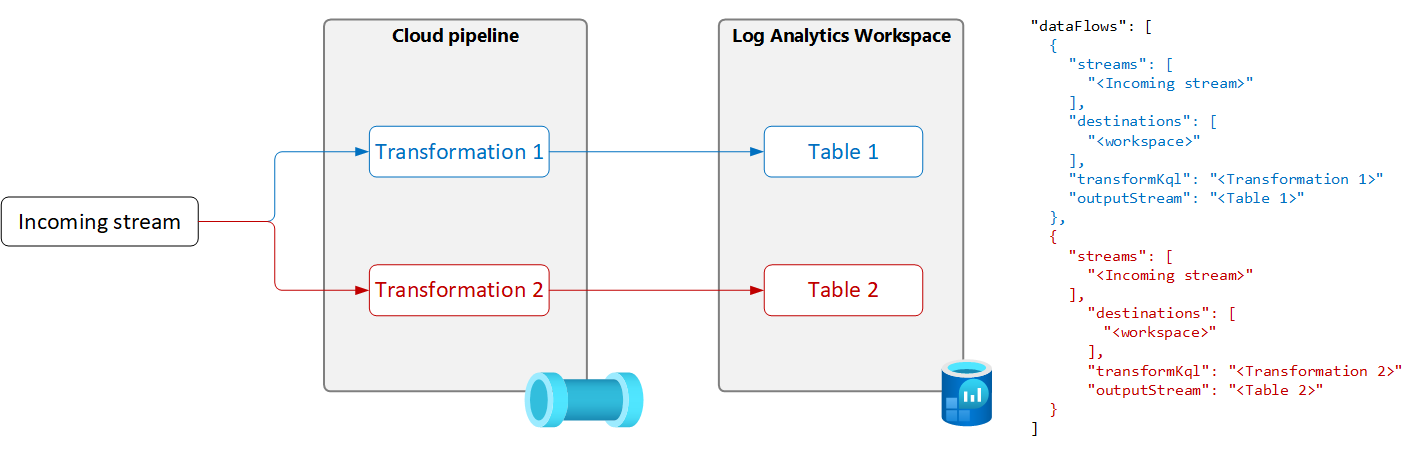

Pokud chcete odesílat data z jednoho zdroje dat do více tabulek, vytvořte v DCR několik toků dat s jedinečným transformačním dotazem a výstupní tabulkou pro každý z nich, jak je znázorněno v následujícím diagramu.

Důležité

V současné době musí být tabulky v DCR ve stejném pracovním prostoru služby Log Analytics. Pokud chcete odesílat do více pracovních prostorů z jednoho zdroje dat, použijte více řadičů domény a nakonfigurujte aplikaci tak, aby do každého z nich odesílala data.

Následující ukázka filtruje záznamy odeslané do tabulky událostí agentem služby Azure Monitor. Do tabulky Událost se odesílají pouze upozornění a chybové události. Další události se odesílají do kopie tabulky událostí s názvem Event_CL, která je nakonfigurovaná pro základní protokoly.

Poznámka:

Tato ukázka vyžaduje kopii tabulky událostí vytvořené ve stejném pracovním prostoru s názvem Event_CL.

{

"location": "eastus",

"properties": {

"dataSources": {

"windowsEventLogs": [

{

"name": "eventLogsDataSource",

"streams": [

"Microsoft-Event"

],

"xPathQueries": [

"System!*[System[(Level = 1 or Level = 2 or Level = 3)]]",

"Application!*[System[(Level = 1 or Level = 2 or Level = 3)]]"

]

}

]

},

"destinations": {

"logAnalytics": [

{

"workspaceResourceId": "/subscriptions/aaaa0a0a-bb1b-cc2c-dd3d-eeeeee4e4e4e/resourceGroups/my-resource-group/providers/Microsoft.OperationalInsights/workspaces/my-workspace",

"name": "MyDestination"

}

]

},

"dataFlows": [

{

"streams": [

"Microsoft-Event"

],

"destinations": [

"MyDestination"

],

"transformKql": "source | where EventLevelName in ('Error', 'Warning')",

"outputStream": "Microsoft-Event"

},

{

"streams": [

"Microsoft-Event"

],

"destinations": [

"MyDestination"

],

"transformKql": "source | where EventLevelName !in ('Error', 'Warning')",

"outputStream": "Custom-Event_CL"

}

]

}

}