Požadavky na síť pro Azure Local

Platí pro: Azure Local 2311.2 a novější

Toto téma popisuje aspekty a požadavky na hostování sítí pro místní Azure. Informace o architekturách datacenter a fyzických připojeních mezi počítači najdete v tématu Požadavky na fyzickou síť.

Informace o tom, jak zjednodušit sítě hostitelů pomocí síťové ATC, naleznete v tématu Zjednodušení sítí v síti ATC.

Typy síťového provozu

Provoz místní sítě Azure je možné klasifikovat zamýšleným účelem:

- Provoz správy: Provoz přicházející z vnějšího systému nebo odcházející mimo místní systém. Například provoz repliky úložiště nebo provoz používaný správcem pro správu systému, jako je Vzdálená plocha, Windows Admin Center, Active Directory atd.

- Výpočetní provoz: Provoz pocházející z virtuálního počítače nebo určený do virtuálního počítače.

- Přenosy dat úložiště: Provoz pomocí protokolu SMB (Server Message Block), například Přímý přístup k úložným prostorám nebo živá migrace založená na protokolu SMB. Tento provoz je provoz druhé vrstvy a není směrovatelný.

Důležité

Replika úložiště používá provoz SMB, který není založený na RDMA. Směrová povaha tohoto provozu (sever–jih) je v souladu s provozem „správy“, jak je uvedeno výše, a podobá se tradičnímu sdílení souborů.

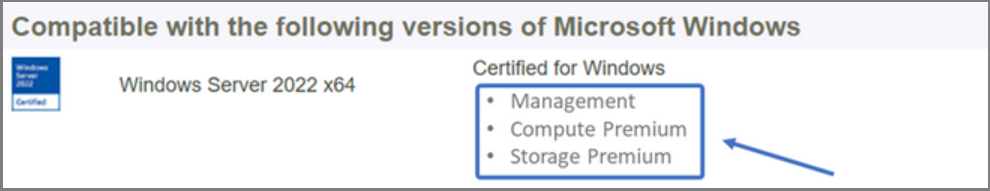

Výběr síťového adaptéru

Síťové adaptéry jsou kvalifikovány podle typů síťového provozu (viz výše), pro které jsou určeny k použití. Při kontrole katalogu Windows Server nyní certifikace systému Windows Server 2022 poukazuje na jednu nebo více rolí z následujícího seznamu. Před nákupem počítače pro Místní Azure musíte mít minimálně jeden adaptér, který je kvalifikovaný pro správu, výpočetní prostředky a úložiště, protože všechny tři typy přenosů se vyžadují v Azure Local. Network ATC pak můžete použít ke konfiguraci adaptérů pro příslušné typy provozu.

Další informace o této kvalifikaci síťové karty založené na rolích najdete v tomto blogovém příspěvku Windows Serveru.

Důležité

Použití adaptéru mimo jeho kvalifikovaný typ provozu není podporováno.

| Úroveň | Role správy | Výpočetní role | Role úložiště |

|---|---|---|---|

| Rozdíl na základě role | Management | Výpočetní standard | Standard úložiště |

| Maximální cena | Nevztahuje se | Compute Premium | Prémiové úložiště |

Poznámka:

Nejvyšší kvalifikace pro všechny adaptéry v našem ekosystému bude obsahovat kvalifikace Management, Compute Premium a Storage Premium .

Požadavky na ovladač

Ovladače doručené pošty nejsou podporovány pro použití s místním prostředím Azure. Pokud chcete zjistit, jestli váš adaptér používá integrovaný ovladač, spusťte následující příkaz. Adaptér používá integrovaný ovladač, pokud vlastnost DriverProvider je Microsoft.

Get-NetAdapter -Name <AdapterName> | Select *Driver*

Přehled možností klíčových síťových adaptérů

Mezi důležité možnosti síťového adaptéru používané službou Azure Local patří:

- Dynamická více fronta virtuálních počítačů (dynamic VMMQ nebo d.VMMQ)

- Vzdálený přímý přístup do paměti (RDMA)

- Hostovaný přímý přístup do paměti (RDMA)

- Switch Embedded Teaming (SET)

Dynamické VMMQ

Všechny síťové adaptéry s kvalifikací Compute (Premium) podporují dynamické VMMQ. Dynamické VMMQ vyžaduje použití technologie Switch Embedded Teaming.

Použitelné typy provozu: výpočty

Požadované certifikace: Compute (Premium)

Dynamic VMMQ je inteligentní technologie na straně příjmu. Navazuje na své předchůdce, jako jsou vyrovnávací fronta virtuálních strojů (VMQ), virtuální škálování na straně příjmu (vRSS) a VMMQ, aby poskytl tři klíčová vylepšení:

- Optimalizuje efektivitu hostitele pomocí menšího počtu jader procesoru.

- Automatické ladění zpracování síťového provozu na jádra procesoru, což umožňuje virtuálním počítačům splňovat a udržovat očekávanou propustnost.

- Umožňuje „nárazové“ pracovní zatížení přijímat očekávaný objem provozu.

Další informace o dynamic VMMQ naleznete v blogovém příspěvku Syntetické akcelerace.

RDMA

RDMA je přesměrování zátěže zásobníku sítě na síťový adaptér. Umožňuje, aby provoz úložiště SMB obešel operační systém ke zpracování.

RDMA umožňuje sítě s vysokou propustností a nízkou latencí s využitím minimálních prostředků procesoru hostitele. Tyto prostředky procesoru hostitele je pak možné použít ke spouštění dalších virtuálních počítačů nebo kontejnerů.

Použitelné typy provozu: hostitelské úložiště

Požadované certifikace: Storage (Standard)

Všechny adaptéry s kvalifikací Storage (Standard) nebo Storage (Premium) podporují RDMA na straně hostitele. Další informace o používání RDMA s úlohami hosta najdete v části Host RDMA dále v tomto článku.

Azure Local podporuje RDMA buď s implementacemi protokolu Internet Wide Area RDMA (iWARP) nebo s implementacemi protokolu RDMA přes konvergovaný Ethernet (RoCE).

Důležité

Adaptéry RDMA fungují jenom s jinými adaptéry RDMA, které implementují stejný protokol RDMA (iWARP nebo RoCE).

Ne všechny síťové adaptéry od dodavatelů podporují RDMA. Následující tabulka uvádí dodavatele (v abecedním pořadí), kteří nabízejí certifikované adaptéry RDMA. V tomto seznamu však nejsou zahrnuti dodavatelé hardwaru, kteří podporují také RDMA. Pokud chcete najít adaptéry s kvalifikací Storage (Standard) nebo Storage (Premium), které vyžadují podporu RDMA, najdete v katalogu Windows Serveru.

Poznámka:

Místní Azure nepodporuje InfiniBand (IB).

| Dodavatel síťových adaptérů | iWARP | RoCE |

|---|---|---|

| Broadcom | Ne | Ano |

| Intel | Ano | Ano (některé modely) |

| Marvell (Qlogic) | Ano | Ano |

| Nvidia | Ne | Ano |

Důrazně doporučujeme použít Network ATC pro další informace o nasazení RDMA na hostitele. Informace o ručním nasazení najdete v úložišti SDN Na GitHubu.

iWARP

Protokol iWARP používá protokol TCP (Transmission Control Protocol) a lze ho volitelně rozšířit pomocí řízení toku založeného na prioritě (PFC) a rozšířené služby přenosu (ETS).

Použijte iWARP, pokud:

- Nemáte zkušenosti se správou sítí RDMA.

- Nespravujete nebo se necítíte komfortně při správě přepínačů ToR (Top-of-Rack).

- Po nasazení nebudete řešení spravovat.

- Už máte nasazení, která používají iWARP.

- Nejste si jistí, kterou možnost zvolit.

RoCE

RoCE používá protokol UDP (User Datagram Protocol) a k zajištění spolehlivosti vyžaduje PFC a ETS.

Použijte RoCE, pokud:

- V datacentru už máte nasazení s RoCE.

- Jste schopni spravovat požadavky na síť DCB.

Hostovaný přímý přístup do paměti (RDMA)

Hostovaný RDMA umožňuje úlohám SMB pro virtuální počítače získat stejné výhody použití RDMA na hostitelích.

Použitelné typy provozu: Hostované úložiště

Požadované certifikace: Compute (Premium)

Hlavními výhodami používání RDMA typu host jsou:

- Procesor se přesměruje na síťovou kartu pro zpracování síťového provozu.

- Extrémně nízká latence.

- Vysoká propustnost.

Pro více informací si stáhněte dokument z úložiště SDN GitHub repo.

Switch Embedded Teaming (SET)

SET je softwarová seskupovací technologie, která je součástí operačního systému Windows Server od verze Windows Server 2016. SET je jediná technologie seskupování podporovaná službou Azure Local. SET dobře funguje s provozem spojeným s výpočty, úložištěm a správou a podporuje až osm adaptérů ve stejném týmu.

Použitelné typy provozu: výpočty, úložiště a správa

Požadované certifikace: Compute (Standard) nebo Compute (Premium)

SET je jediná technologie seskupování podporovaná službou Azure Local. SET dobře funguje s datovými přenosy výpočetních prostředků, úložiště a správy.

Důležité

Azure Local nepodporuje seskupování síťových adaptérů s použitím starší metody Load Balancing/Failover (LBFO). Další informace o LBFO v Azure Local najdete v blogovém příspěvku Teaming v Azure Local.

Sada SET je důležitá pro Azure Local, protože je to jediná technologie seskupování, která umožňuje:

- Seskupování adaptérů RDMA (v případě potřeby)

- Guest RDMA.

- Dynamické VMMQ.

- Další klíčové místní funkce Azure (viz Seskupování v Azure Local).

SET vyžaduje použití symetrických (identických) adaptérů. Symetrické síťové adaptéry jsou ty, které mají stejné tyto položky:

- výrobce (dodavatel)

- model (verze)

- rychlost (propustnost)

- konfigurace

Ve verzi 22H2 síťová ATC automaticky rozpozná a informuje vás, jestli zvolené adaptéry jsou asymetrické. Nejjednodušší způsob, jak ručně zjistit, jestli jsou adaptéry symetrické, je pokud se rychlosti a popisy rozhraní přesně shodují. Mohou se odchylovat pouze v číslicích uvedených v popisu. Pomocí rutiny Get-NetAdapterAdvancedProperty ověřte, že hlášené seznamy konfigurací obsahují stejné hodnoty vlastností.

Příklad popisů rozhraní, které se liší pouze číslicemi (#), najdete v následující tabulce:

| Název | Popis rozhraní | Rychlost propojení |

|---|---|---|

| NIC1 | Síťový adaptér č. 1 | 25 Gb/s |

| NIC2 | Síťový adaptér č. 2 | 25 Gbps |

| NIC3 | Síťový adaptér č. 3 | 25 Gbps |

| NIC4 | Síťový adaptér č. 4 | 25 Gb/s |

Poznámka:

SET podporuje pouze konfiguraci nezávislou na přepínači pomocí dynamických algoritmů nebo algoritmů vyrovnávání zatížení portů Hyper-V. Pokud chcete dosáhnout nejlepšího výkonu, doporučuje se u všech síťových karet, které fungují rychlostí 10 Gbps a více, použít port Hyper-V. Síťová ATC vytvoří všechny požadované konfigurace pro SET.

Důležité informace o provozu RDMA

Pokud implementujete DCB, musíte zajistit, aby byla správně implementována konfigurace PFC a ETS napříč všemi síťovými porty, včetně síťových přepínačů. DcB se vyžaduje pro RoCE a volitelný pro iWARP.

Pro podrobné informace o nasazení RDMA si stáhněte dokument z úložiště SDN na GitHubu.

Místní implementace Azure založené na RoCE vyžadují konfiguraci tří tříd provozu PFC, včetně výchozí třídy provozu napříč prostředky infrastruktury a všemi hostiteli.

Třída systémového provozu

Tato třída provozu zajišťuje, že je dostatek šířky pásma vyhrazeno pro systémové pulzy systému.

- Povinné: Ano

- S podporou PFC: Ne

- Doporučená priorita provozu: Priorita 7

- Doporučená rezervace šířky pásma:

- 10 GbE nebo nižší sítě RDMA = 2 procenta

- 25 GbE nebo vyšší sítě RDMA = 1 procento

Třída provozu RDMA

Tato třída provozu zajišťuje, že je dostatek šířky pásma vyhrazeno pro bezeztrátovou komunikaci RDMA pomocí SMB Direct.

- Povinné: Ano

- S podporou PFC: Ano

- Doporučená priorita provozu: Priorita 3 nebo 4

- Doporučená rezervace šířky pásma: 50 procent

Výchozí třída provozu

Tato třída provozu nese všechny ostatní přenosy, které nejsou definovány v třídách provozu systému nebo RDMA, včetně provozu virtuálního počítače a provozu správy:

- Povinné: Ve výchozím nastavení (na hostiteli není nutná žádná konfigurace)

- Řízení toku (PFC)- povoleno: Ne

- Doporučená třída provozu: Ve výchozím nastavení (Priorita 0)

- Doporučená rezervace šířky pásma: Ve výchozím nastavení (nevyžaduje se žádná konfigurace hostitele)

Modely provozu úložiště

Protokol SMB poskytuje mnoho výhod jako protokol úložiště pro Azure Local, včetně SMB Multichannel. Protokol SMB Multichannel není popsaný v tomto článku, ale je důležité si uvědomit, že provoz je multiplexovaný přes všechny možné propojení, které může protokol SMB Multichannel používat.

Poznámka:

K oddělení provozu úložiště v Azure Local doporučujeme použít více podsítí a sítí VLAN.

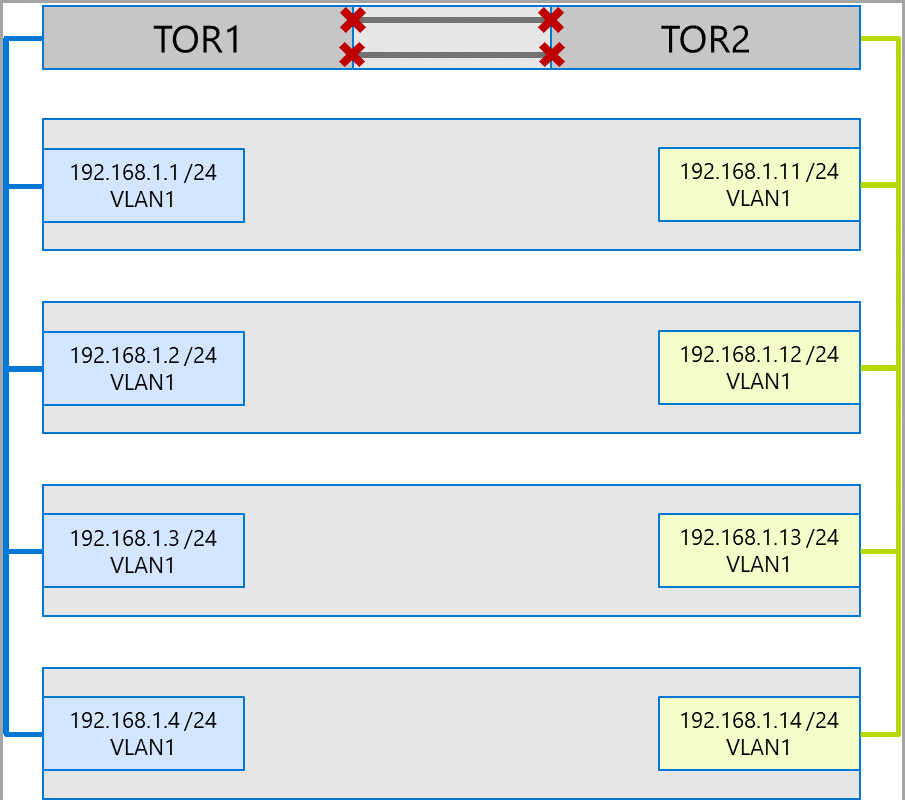

Podívejte se na následující příklad systému se čtyřmi uzly. Každý počítač má dva porty úložiště (vlevo a vpravo). Vzhledem k tomu, že každý adaptér je ve stejné podsíti a síti VLAN, SMB Multichannel rozdělí připojení mezi všechny dostupné spoje. Proto levý port na prvním počítači (192.168.1.1.1) vytvoří připojení k levému portu na druhém počítači (192.168.1.2). Pravý port na prvním počítači (192.168.1.12) se připojí k pravému portu na druhém počítači. Podobná připojení jsou vytvořena pro třetí a čtvrtý počítač.

To však vytváří zbytečná připojení a způsobuje zahlcení v propojení MC-LAG (agregace více šasi), které spojuje přepínače ToR (označené X). Podívejte se na následující diagram:

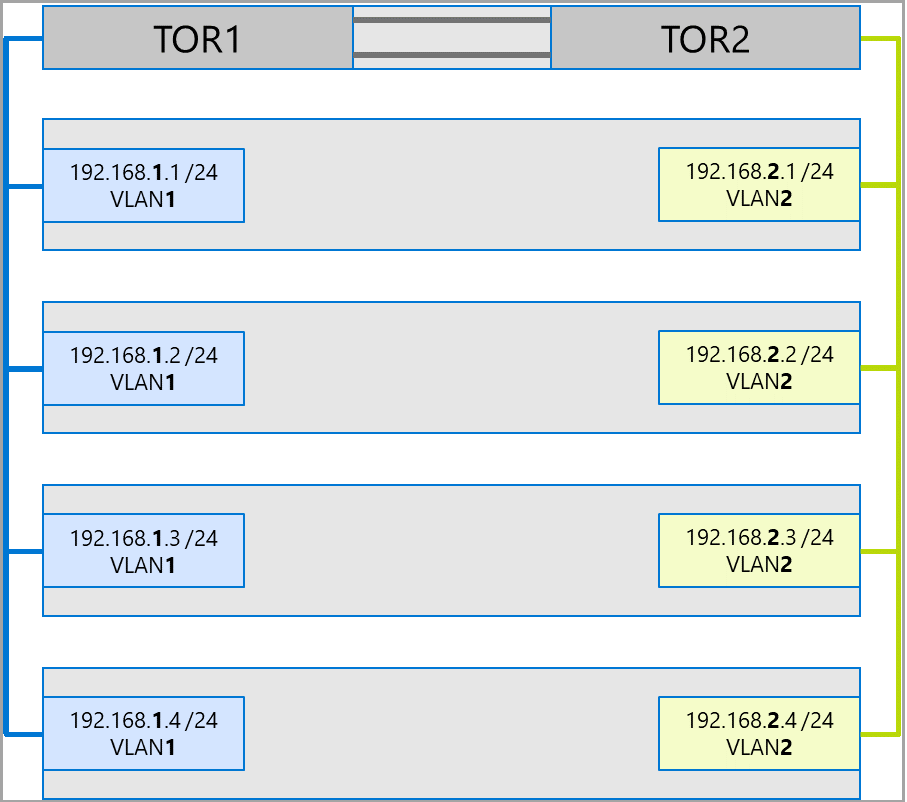

Doporučeným přístupem je použití samostatných podsítí a sítí VLAN pro každou sadu adaptérů. V následujícím diagramu teď pravé porty používají podsíť 192.168.2.x /24 a VLAN2. To umožňuje, aby provoz na portech na levé straně zůstal na TOR1 a provoz na pravých portech zůstal na TOR2.

Přidělení šířky pásma provozu

Následující tabulka ukazuje příklad přidělování šířky pásma různých typů provozu s využitím běžných rychlostí adaptérů v Azure Local. Všimněte si, že toto je příklad sblíženého řešení, kdy všechny typy provozu (výpočetní prostředky, úložiště a správa) běží přes stejné fyzické adaptéry a jsou seskupené pomocí set.

Vzhledem k tomu, že tento případ použití představuje největší omezení, představuje dobrý směrný plán. Nicméně vzhledem k permutacím počtu adaptérů a rychlostí by se to mělo považovat za příklad, a ne požadavek na podporu.

V tomto příkladu jsou provedeny následující předpoklady:

Každý tým má dva adaptéry.

Vrstva sběrnice úložiště (SBL), sdílený svazek clusteru (CSV) a datový provoz Hyper-V (Live Migration):

- Použijte stejné fyzické adaptéry.

- Použijte protokol SMB.

SMB je přiděleno 50 procent šířky pásma pomocí DCB.

- SBL/CSV je provoz s nejvyšší prioritou a přijímá 70 procent rezervace šířky pásma SMB.

- Migrace za provozu (LM) je limitována pomocí

Set-SMBBandwidthLimitrutiny a přijímá 29 procent zbývající šířky pásma.Pokud je dostupná šířka pásma pro migraci za provozu >= 5 Gb/s a síťové adaptéry to podporují, použijte RDMA. K tomu použijte následující příkaz cmdlet:

Set-VMHost -VirtualMachineMigrationPerformanceOption SMBPokud je dostupná šířka pásma pro migraci za provozu menší než < 5 Gb/s, použijte kompresi k redukci dob výpadku. K tomu použijte následující cmdlet:

Set-VMHost -VirtualMachineMigrationPerformanceOption Compression

Pokud pro přenosy migrace za provozu používáte RDMA, ujistěte se, že provoz migrace za provozu nemůže využívat celou šířku pásma přidělenou třídě přenosů RDMA pomocí limitu šířky pásma SMB. Buďte opatrní, protože tato rutina přijímá vstup v bajtech za sekundu (Bps), zatímco síťové adaptéry jsou uvedeny v bitech za sekundu (bps). Pomocí následující rutiny nastavte limit šířky pásma 6 Gb/s, například:

Set-SMBBandwidthLimit -Category LiveMigration -BytesPerSecond 750MBPoznámka:

750 MB/s v tomto příkladu odpovídá 6 Gb/s.

Tady je příklad tabulky přidělení šířky pásma:

| Rychlost síťové karty | Seskupené šířky pásma | Rezervace šířky pásma SMB** | SBL/CSV % | Šířka pásma SBL/CSV | Migrace za provozu % | Maximální šířka pásma migrace za provozu | Srdeční tep % | Šířka pásma signálu heartbeat |

|---|---|---|---|---|---|---|---|---|

| 10 Gbps | 20 Gb/s | 10 Gbps | 70 % | 7 Gb/s | * | 200 Mb/s | ||

| 25 Gb/s | 50 Gb/s | 25 Gbps | 70 % | 17,5 Gb/s | 29 % | 7,25 Gb/s | 1 % | 250 MB/s |

| 40 Gbps | 80 Gb/s | 40 Gbps | 70 % | 28 Gbps | 29 % | 11,6 Gb/s | 1 % | 400 Mb/s |

| 50 Gbps | 100 Gbps | 50 Gbps | 70 % | 35 Gbps | 29 % | 14,5 Gb/s | 1 % | 500 Mb/s |

| 100 Gbps | 200 Gbps | 100 Gbps | 70 % | 70 Gbps | 29 % | 29 Gbps | 1 % | 1 Gbps |

| 200 Gbps | 400 Gb/s | 200 Gbps | 70 % | 140 Gb/s | 29 % | 58 Gb/s | 1 % | 2 Gbps |

* Použijte kompresi místo RDMA, protože pro provoz Live Migration je přidělená šířka pásma <5 Gb/s.

** 50 procent je příkladem rezervace šířky pásma.

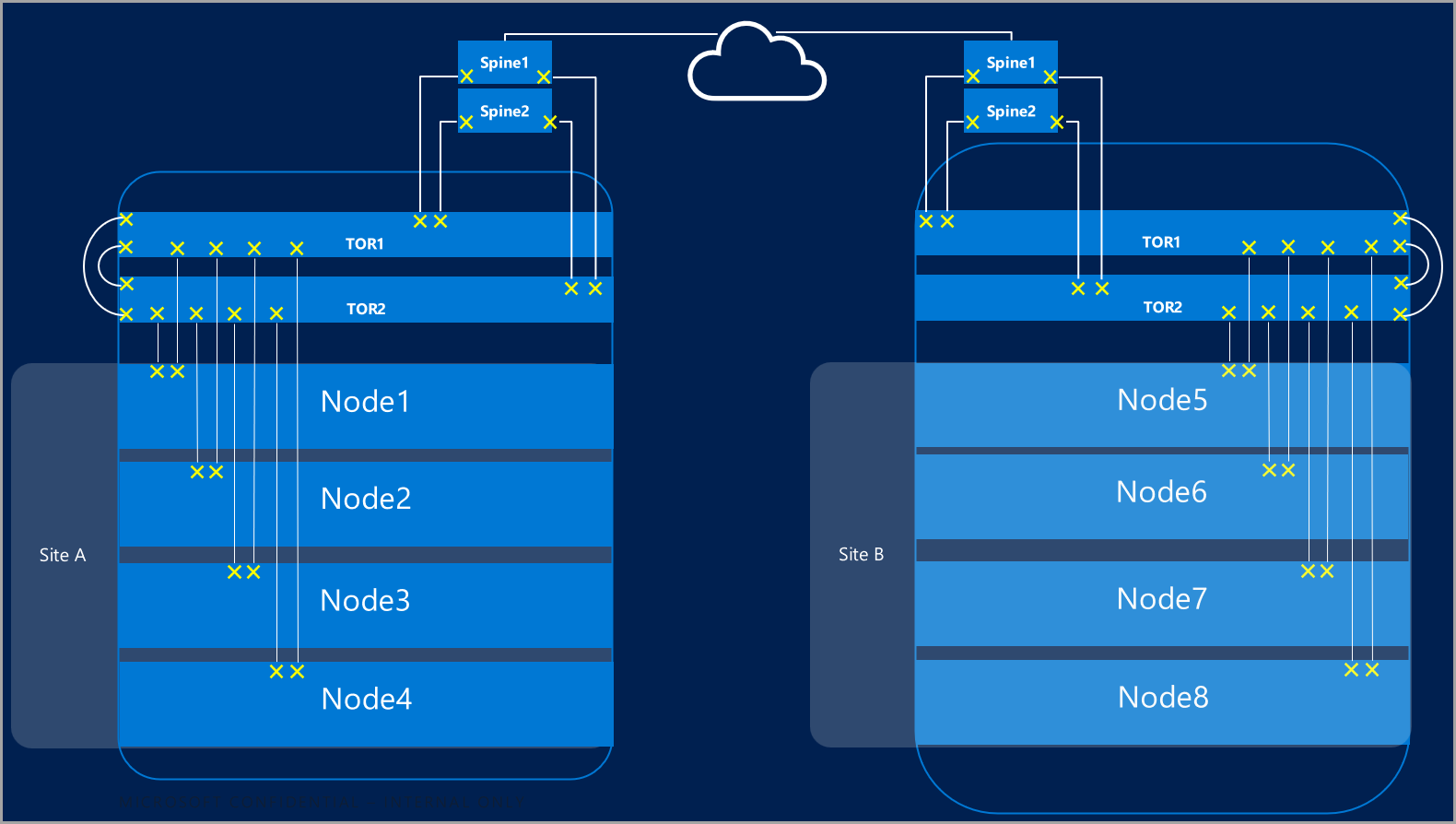

Roztažené shluky

Roztažené clustery poskytují zotavení po havárii, které zahrnuje více datacenter. V nejjednodušší podobě vypadá roztažený cluster Azure Local takto:

Požadavky na roztažené clustery

Důležité

Funkce roztaženého clusteru je dostupná jenom v místním Azure verze 22H2.

Roztažené clustery mají následující požadavky a charakteristiky:

Přímý přístup do paměti (RDMA) je omezený na jednu lokalitu a nepodporuje se napříč různými lokalitami nebo podsítěmi.

Počítače ve stejné lokalitě musí být umístěny ve stejném racku a hranici vrstvy 2.

Komunikace mezi lokalitami musí překračovat hranice vrstvy 3; Roztažené topologie vrstvy 2 se nepodporují.

Máte dostatečnou šířku pásma pro spouštění úloh na druhé lokalitě. V případě převzetí služeb při selhání bude muset náhradní lokalita přebrat veškerý provoz. Doporučujeme zřídit weby s využitím 50 procent jejich dostupné síťové kapacity. Není to však požadavek, pokud dokážete během převzetí služeb při selhání tolerovat nižší výkon.

Adaptéry používané pro komunikaci mezi lokalitami:

Může to být fyzický nebo virtuální (hostitelský vNIC). Pokud jsou adaptéry virtuální, musíte zřídit jeden vNIC ve své vlastní podsíti a síti VLAN pro každý fyzický adaptér.

Musí být ve vlastní podsíti a virtuální síti LAN (VLAN), které se můžou směrovat mezi jednotlivými lokalitami.

RDMA musí být zakázán pomocí rutiny

Disable-NetAdapterRDMA. Doporučujeme explicitně vyžadovat, aby replika úložiště používala konkrétní rozhraní pomocí rutinySet-SRNetworkConstraint.Musí splňovat jakékoli další požadavky pro Storage Replica.

Další kroky

- Seznamte se s požadavky na síťový přepínač a fyzickou síť. Viz požadavky na fyzickou síť.

- Zjistěte, jak zjednodušit síťové funkce hostitele pomocí Network ATC. Viz Zjednodušte síťování hostitelů pomocí Network ATC.

- Zdokonalte se v základech síťování u clusterů s podporou převzetí služeb při selhání.

- Viz Nasazení pomocí webu Azure Portal.

- Viz Nasazení pomocí šablony Azure Resource Manageru.