Vyhodnocení Azure OpenAI (Preview)

Vyhodnocení velkých jazykových modelů je kritickým krokem při měření jejich výkonu v různých úlohách a dimenzích. To je zvlášť důležité pro jemně vyladěné modely, kdy je důležité vyhodnotit zvýšení výkonu (nebo ztráty) z trénování. Důkladné vyhodnocení vám může pomoct pochopit, jak mohou různé verze modelu ovlivnit vaši aplikaci nebo scénář.

Vyhodnocení Azure OpenAI umožňuje vývojářům vytvářet testovací běhy pro testování podle očekávaných párů vstupu a výstupu, vyhodnocení výkonu modelu napříč klíčovými metrikami, jako je přesnost, spolehlivost a celkový výkon.

Podpora vyhodnocení

Regionální dostupnost

- USA – východ 2

- Severní střed USA

- Švédsko – střed

- Švýcarsko – západ

Podporované typy nasazení

- Standard

- Globální standard

- Standard datové zóny

- Zřízená spravovaná

- Globální zřízená spravovaná

- Zřízená datová zóna

Kanál vyhodnocení

Testovací data

Potřebujete sestavit základní datovou sadu pravdy, na které chcete testovat. Vytvoření datové sady je obvykle iterativní proces, který zajišťuje, aby vaše vyhodnocení zůstalo relevantní pro vaše scénáře v průběhu času. Tato základní datová sada pravdy je obvykle ručně ručně chovaná a představuje očekávané chování modelu. Datová sada je také označená a obsahuje očekávané odpovědi.

Poznámka:

Některé zkušební testy, jako je mínění a platný kód JSON nebo XML , nevyžadují základní pravdivá data.

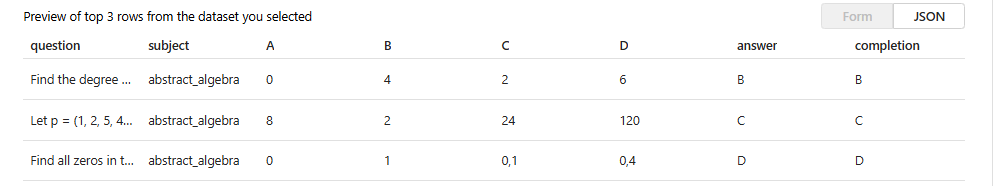

Váš zdroj dat musí být ve formátu JSONL. Níže jsou uvedeny dva příklady datových sad pro vyhodnocení JSONL:

Formát vyhodnocení

{"question": "Find the degree for the given field extension Q(sqrt(2), sqrt(3), sqrt(18)) over Q.", "subject": "abstract_algebra", "A": "0", "B": "4", "C": "2", "D": "6", "answer": "B", "completion": "B"}

{"question": "Let p = (1, 2, 5, 4)(2, 3) in S_5 . Find the index of <p> in S_5.", "subject": "abstract_algebra", "A": "8", "B": "2", "C": "24", "D": "120", "answer": "C", "completion": "C"}

{"question": "Find all zeros in the indicated finite field of the given polynomial with coefficients in that field. x^5 + 3x^3 + x^2 + 2x in Z_5", "subject": "abstract_algebra", "A": "0", "B": "1", "C": "0,1", "D": "0,4", "answer": "D", "completion": "D"}

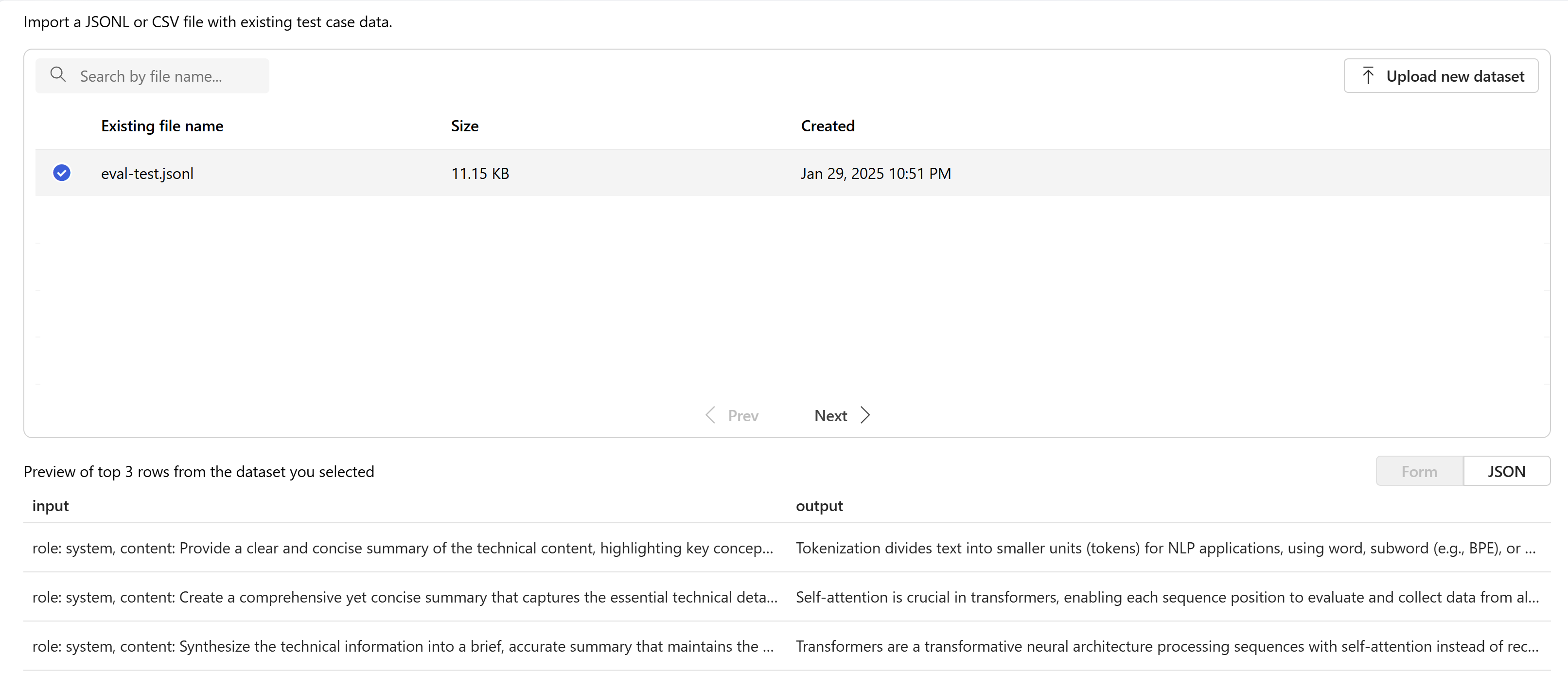

Když nahrajete a vyberete zkušební soubor, vrátí se náhled prvních tří řádků:

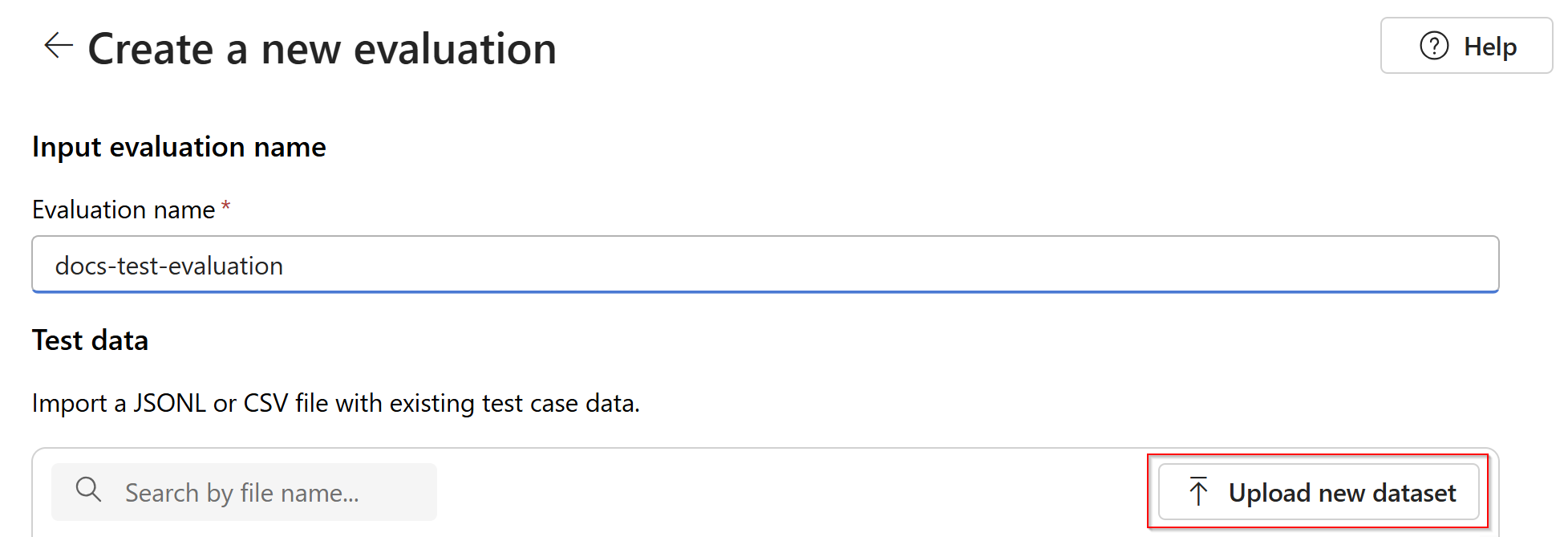

Můžete zvolit všechny existující dříve nahrané datové sady nebo nahrát novou datovou sadu.

Vytváření odpovědí (volitelné)

Výzva, kterou použijete ve svém vyhodnocení, by se měla shodovat s výzvou, kterou plánujete použít v produkčním prostředí. Tyto výzvy obsahují pokyny, podle které má model postupovat. Podobně jako u prostředí dětského hřiště můžete vytvořit několik vstupů, které do výzvy zahrnou několik příkladů. Další informace najdete v tématu Výzvy techniky přípravy k podrobnostem o některých pokročilých technikách návrhu výzvy a návrhu výzvy.

Vstupní data můžete odkazovat v rámci výzev pomocí {{input.column_name}} formátu, kde column_name odpovídá názvům sloupců ve vstupním souboru.

Výstupy vygenerované během vyhodnocení budou odkazovány v následných krocích pomocí {{sample.output_text}} formátu.

Poznámka:

Abyste měli jistotu, že na data odkazujete správně, musíte použít dvojité složené závorky.

Nasazení modelu

Při vytváření hodnocení si vyberete modely, které se mají použít při generování odpovědí (volitelné) a také modely, které se mají použít při známkování modelů s konkrétními testovacími kritérii.

V Azure OpenAI budete přiřazovat konkrétní nasazení modelu, která se budou používat jako součást vyhodnocení. V rámci jednoho zkušebního spuštění můžete porovnat více nasazení modelu.

Můžete vyhodnotit nasazení základního nebo jemně vyladěného modelu. Nasazení dostupná v seznamu závisí na nasazeních, které jste vytvořili v rámci prostředku Azure OpenAI. Pokud nemůžete najít požadované nasazení, můžete vytvořit nový ze stránky vyhodnocení Azure OpenAI.

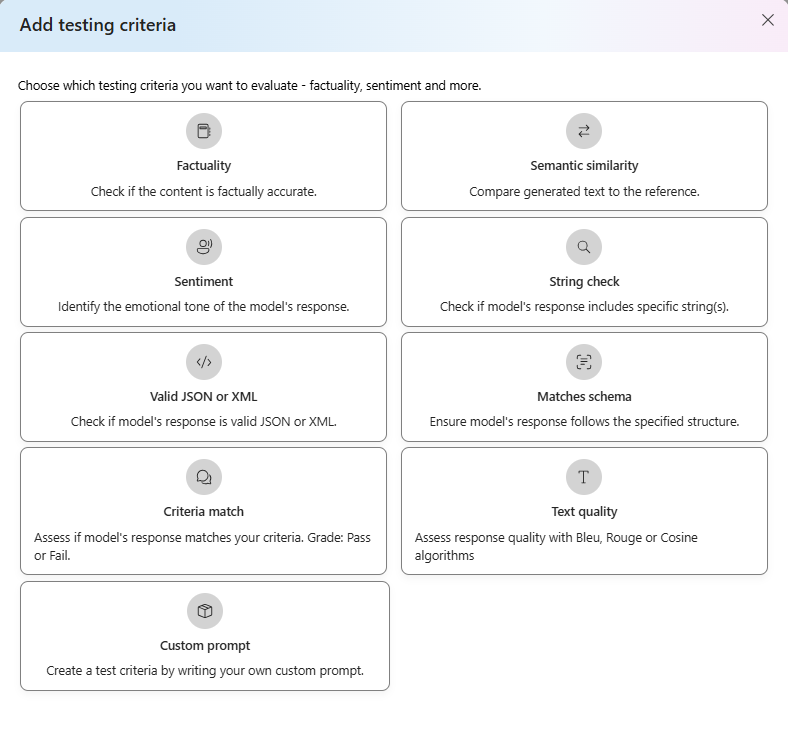

Kritéria testování

Kritéria testování se používají k vyhodnocení účinnosti každého výstupu generovaného cílovým modelem. Tyto testy porovnávají vstupní data s výstupními daty, aby byla zajištěna konzistence. Máte možnost konfigurovat různá kritéria pro testování a měření kvality a relevance výstupu na různých úrovních.

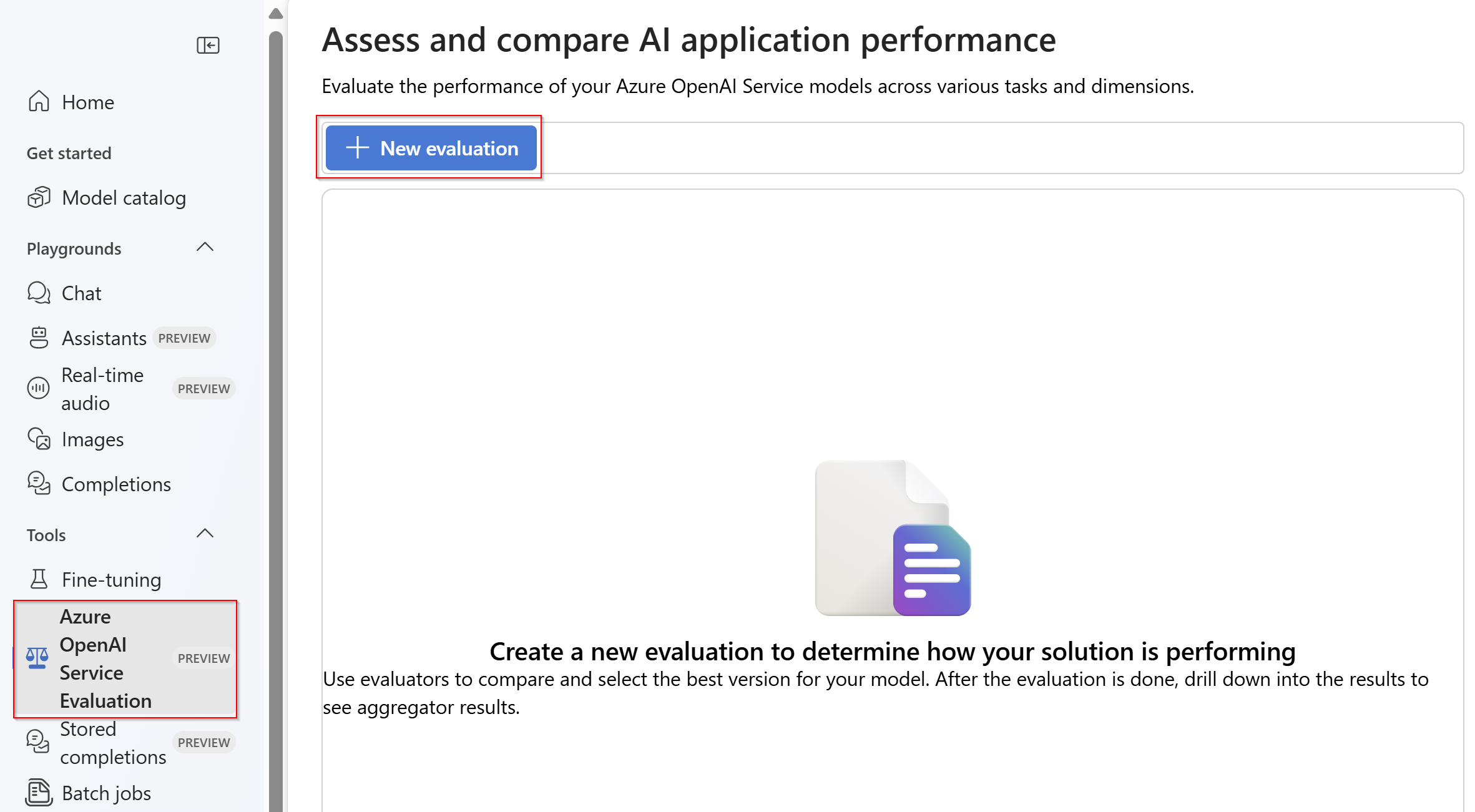

Začínáme

Na portálu Azure AI Foundry vyberte zkušební verzi Azure OpenAI (PREVIEW ). Pokud chcete toto zobrazení zobrazit jako možnost, může být potřeba nejprve vybrat existující prostředek Azure OpenAI v podporované oblasti.

Výběr možnosti Nové vyhodnocení

Zadejte název vyhodnocení. Ve výchozím nastavení se automaticky vygeneruje náhodný název, pokud ho nebudete upravovat a nenahrazovat. Vyberte Nahrát novou datovou sadu.

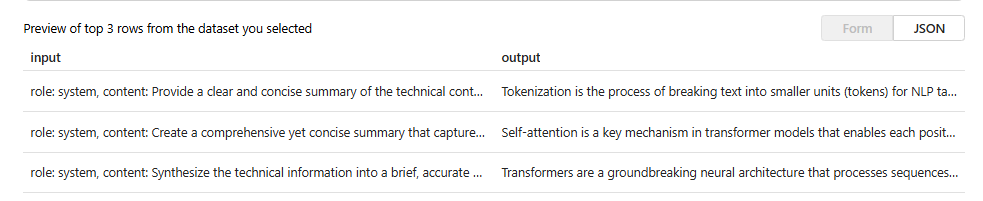

Vyberte své vyhodnocení, které bude ve

.jsonlformátu. Pokud potřebujete ukázkový testovací soubor, můžete tyto 10 řádků uložit do souboru s názvemeval-test.jsonl:{"input": [{"role": "system", "content": "Provide a clear and concise summary of the technical content, highlighting key concepts and their relationships. Focus on the main ideas and practical implications."}, {"role": "user", "content": "Tokenization is a key step in preprocessing for natural language processing, involving the division of text into smaller components called tokens. These can be words, subwords, or characters, depending on the method chosen. Word tokenization divides text at word boundaries, while subword techniques like Byte Pair Encoding (BPE) or WordPiece can manage unknown words by breaking them into subunits. Character tokenization splits text into individual characters, useful for multiple languages and misspellings. The tokenization method chosen greatly affects model performance and its capacity to handle various languages and vocabularies."}], "output": "Tokenization divides text into smaller units (tokens) for NLP applications, using word, subword (e.g., BPE), or character methods. Each has unique benefits, impacting model performance and language processing capabilities."} {"input": [{"role": "system", "content": "Create a comprehensive yet concise summary that captures the essential technical details and significance of the topic."}, {"role": "user", "content": "Self-attention mechanisms are vital in modern transformer models, allowing them to evaluate the relevance of different parts of an input sequence when processing each element. In self-attention, each position in a sequence learns to focus on all other positions, forming a weighted sum of their values. Attention weights are derived using queries, keys, and values, with compatibility between a query and key determining attention to each value. This mechanism enables capturing long-range dependencies and relationships within a sequence, making it effective for tasks needing context understanding and inter-part relationships."}], "output": "Self-attention is crucial in transformers, enabling each sequence position to evaluate and collect data from all others. It uses queries, keys, and values for attention weights, effectively capturing long-range dependencies and contextual links."} {"input": [{"role": "system", "content": "Synthesize the technical information into a brief, accurate summary that maintains the core concepts and their significance."}, {"role": "user", "content": "The transformer architecture significantly changed natural language processing by introducing a new method for sequence processing. Unlike recurrent neural networks, transformers process whole sequences at once using self-attention. The architecture consists of an encoder and decoder, each with multiple layers of multi-head attention, feed-forward networks, and normalization layers. The encoder processes the input sequence, and the decoder produces the output sequence. Positional encodings are added to retain sequence order information since the model lacks inherent sequence position awareness. This architecture underlies many leading language models like BERT and GPT."}], "output": "Transformers are a transformative neural architecture processing sequences with self-attention instead of recurrence. Their encoder-decoder design, with multi-head attention and position encodings, is fundamental to modern language models like BERT and GPT."} {"input": [{"role": "system", "content": "Distill the technical content into a clear, concise summary that preserves the most important concepts and their practical applications."}, {"role": "user", "content": "Cosine similarity is a metric for measuring similarity between vectors by calculating the cosine of the angle between them. The outcome ranges from -1 to 1, with 1 indicating identical orientation, 0 orthogonality, and -1 opposite orientation. In machine learning and NLP, cosine similarity is useful for comparing document vectors, word embeddings, or any high-dimensional representations. It's often preferred over Euclidean distance because it's invariant to vector magnitude, focusing instead on orientation. This makes it particularly useful for comparing documents or embeddings of various lengths or scales."}], "output": "Cosine similarity evaluates vector similarity by computing their angle's cosine, with values from -1 to 1. It's widely used in ML and NLP for comparing document vectors and embeddings due to its magnitude-invariant nature."} {"input": [{"role": "system", "content": "Provide a succinct summary that captures the key technical concepts and their relationships while maintaining clarity and accuracy."}, {"role": "user", "content": "Neural network activation functions are crucial for introducing non-linearity to deep learning models. Commonly used activation functions include ReLU (Rectified Linear Unit), which outputs the input directly if positive and zero otherwise, sigmoid, which compresses values between 0 and 1, and tanh, which normalizes values between -1 and 1. Each function has specific benefits and applications: ReLU avoids vanishing gradients and enables sparse activation, sigmoid is useful for binary classification, and tanh is often used in hidden layers for its zero-centered output. The activation function choice greatly affects model training dynamics and ultimate performance."}], "output": "Activation functions introduce non-linearity to neural networks, with ReLU, sigmoid, and tanh being the most common. Each serves distinct purposes: ReLU prevents vanishing gradients, sigmoid is suitable for binary classification, and tanh offers zero-centered output, all affecting model performance differently."} {"input": [{"role": "system", "content": "Create a focused summary that emphasizes the main technical concepts and their practical implications while maintaining accuracy."}, {"role": "user", "content": "Batch normalization is a technique that stabilizes and accelerates deep neural network training by normalizing each layer's inputs. It normalizes activations using the mean and variance computed over the current data batch. This normalization reduces internal covariate shift, where the input distribution changes during training. Batch normalization includes learnable parameters (gamma and beta) allowing the network to reverse normalization if necessary. Benefits include enabling higher learning rates, lessening the importance of precise parameter initialization, and serving as a regularizer, potentially removing the need for dropout."}], "output": "Batch normalization stabilizes neural network training by normalizing layer inputs using batch statistics. It addresses internal covariate shift with learnable parameters, allowing higher learning rates and improved training dynamics, while offering regularization benefits."} {"input": [{"role": "system", "content": "Summarize the technical content while preserving the essential concepts and their interconnections, ensuring clarity and precision."}, {"role": "user", "content": "Gradient descent optimization algorithms are foundational to training machine learning models. The basic version updates parameters in the steepest descent direction of the loss function. Variants like Stochastic Gradient Descent (SGD) use random samples to estimate gradients, enhancing computational efficiency. Advanced optimizers like Adam combine momentum (helping overcome local minima) and RMSprop (adapting learning rates for each parameter). These optimizers maintain running averages of gradients and their squares, enabling adaptive learning rates and more efficient training. The optimizer choice can significantly influence model convergence speed and final performance."}], "output": "Gradient descent algorithms optimize ML models by updating parameters based on loss gradients. Variants like SGD use sampling for efficiency, while advanced optimizers like Adam combine momentum with adaptive learning rates for improved training performance."} {"input": [{"role": "system", "content": "Deliver a concise yet comprehensive summary that highlights the key technical aspects and their practical significance."}, {"role": "user", "content": "Cross-validation is a resampling method used to evaluate machine learning models on limited data. The most common form, k-fold cross-validation, involves dividing the dataset into k equal parts, training the model on k-1 folds while validating on the remaining fold, and rotating through all combinations. This provides a more robust model performance assessment than a single train-test split, helping detect overfitting and estimate model generalization to unseen data. Variations include stratified k-fold (maintaining class distribution), leave-one-out (k equals dataset size), and time series cross-validation for temporal data."}], "output": "Cross-validation evaluates ML models by training and testing on different data splits, typically using k-fold methodology. This approach offers better performance assessment than single splits, with variations for different data types and requirements."} {"input": [{"role": "system", "content": "Generate a clear and focused summary that captures the essential technical details while maintaining their relationships and significance."}, {"role": "user", "content": "Transfer learning is a machine learning method where a model developed for one task is reused as the starting point for a model on a second task. This approach is powerful in deep learning, where pre-trained models on large datasets (like ImageNet for computer vision or BERT for NLP) are fine-tuned on specific downstream tasks. Transfer learning reduces the need for large amounts of task-specific training data and computational resources, as the model has already learned useful features from the source domain. Common strategies include feature extraction (freezing pre-trained layers) and fine-tuning (updating all or some pre-trained weights)."}], "output": "Transfer learning reuses models trained on one task for different tasks, particularly effective in deep learning. It leverages pre-trained models through feature extraction or fine-tuning, reducing data and computational needs for new tasks."} {"input": [{"role": "system", "content": "Provide a precise and informative summary that distills the key technical concepts while maintaining their relationships and practical importance."}, {"role": "user", "content": "Ensemble methods combine multiple machine learning models to create a more robust and accurate predictor. Common techniques include bagging (training models on random data subsets), boosting (sequentially training models to correct earlier errors), and stacking (using a meta-model to combine base model predictions). Random Forests, a popular bagging method, create multiple decision trees using random feature subsets. Gradient Boosting builds trees sequentially, with each tree correcting the errors of previous ones. These methods often outperform single models by reducing overfitting and variance while capturing different data aspects."}], "output": "Ensemble methods enhance prediction accuracy by combining multiple models through techniques like bagging, boosting, and stacking. Popular implementations include Random Forests (using multiple trees with random features) and Gradient Boosting (sequential error correction), offering better performance than single models."}První tři řádky souboru uvidíte jako náhled:

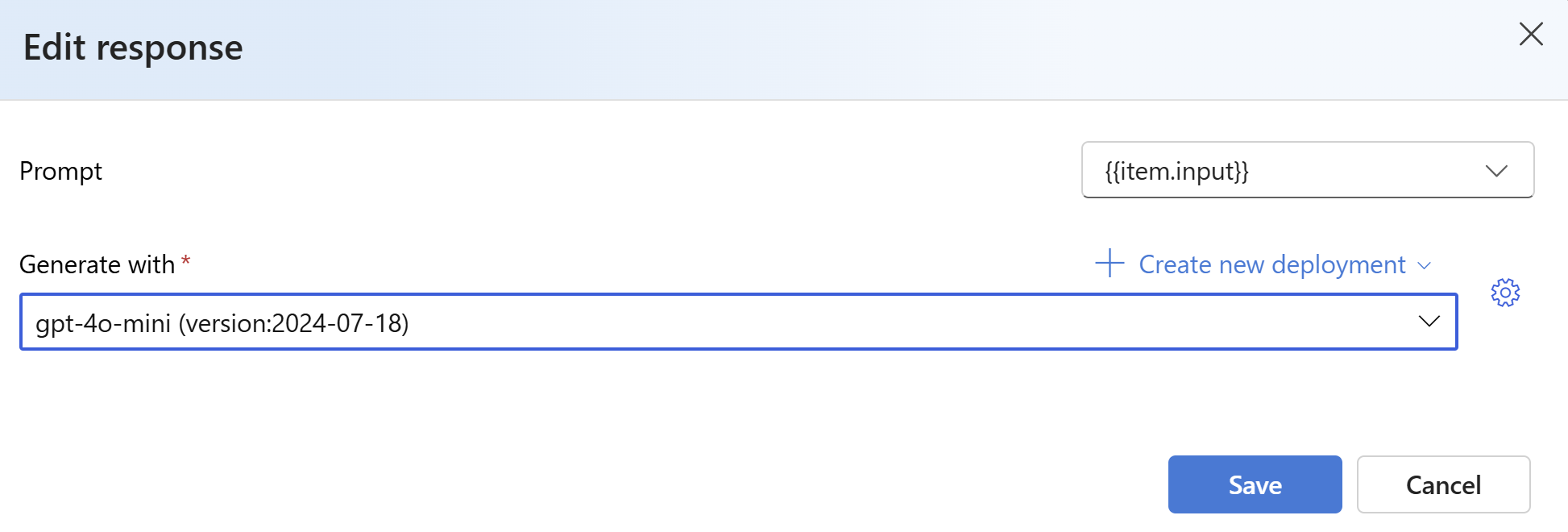

V části Odpovědi vyberte tlačítko Vytvořit . Vyberte

{{item.input}}z rozevíracího seznamu Vytvořit pomocí šablony . Tím se vstupní pole z našeho zkušebního souboru vloží do jednotlivých výzev ke spuštění nového modelu, které chceme porovnat s naší vyhodnocovací datovou sadou. Model vezme tento vstup a vygeneruje vlastní jedinečné výstupy, které v tomto případě budou uloženy v proměnné s názvem{{sample.output_text}}. Tento ukázkový výstupní text pak použijeme později jako součást našich testovacích kritérií. Alternativně můžete zadat vlastní systémovou zprávu a příklady jednotlivých zpráv ručně.Vyberte model, který chcete generovat odpovědi na základě vyhodnocení. Pokud model nemáte, můžete ho vytvořit. Pro účely tohoto příkladu používáme standardní nasazení

gpt-4o-mini.Symbol nastavení/srocketu řídí základní parametry, které jsou předány modelu. V tuto chvíli jsou podporovány pouze následující parametry:

- Teplota

- Maximální délka

- Horní P

Maximální délka je aktuálně omezena na 2048 bez ohledu na to, jaký model vyberete.

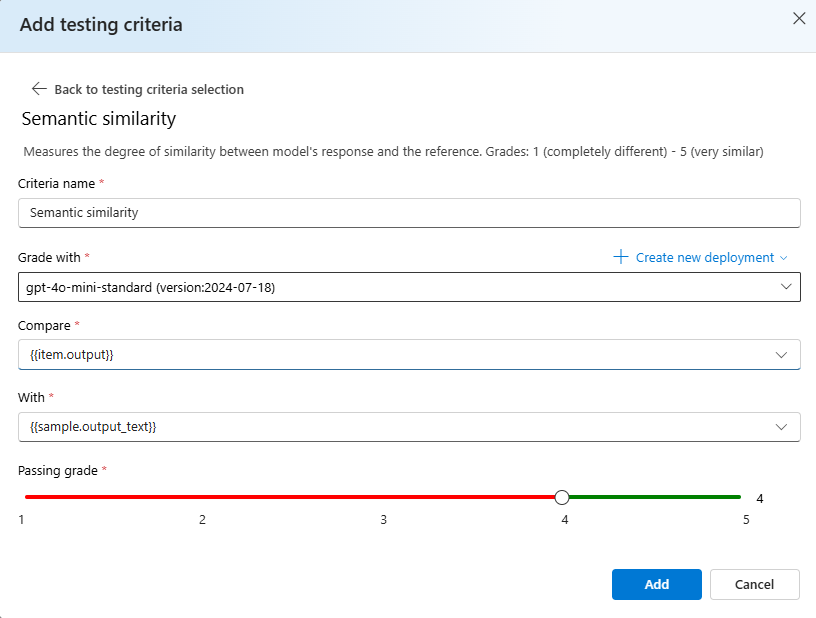

Vyberte Přidat testovací kritéria a vyberte Přidat.

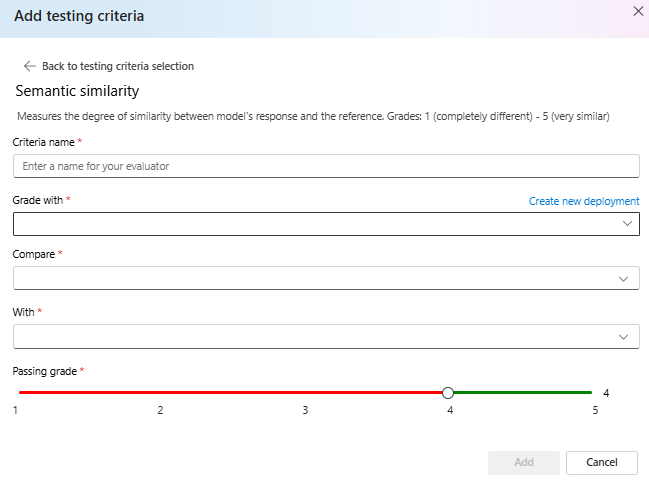

Vyberte sémantickou podobnost> v části Porovnat přidat

{{item.output}}v části Přidat{{sample.output_text}}. Tím se vezme původní referenční výstup z vašeho zkušebního.jsonlsouboru a porovná ho s výstupem, který se vygeneruje tím, že model zobrazí výzvy založené na vašem{{item.input}}.> V tuto chvíli můžete buď přidat další testovací kritéria, nebo výběrem možnosti Vytvořit zahájit spuštění zkušební úlohy.

Jakmile vyberete Vytvořit , přejdete na stránku stavu pro úlohu vyhodnocení.

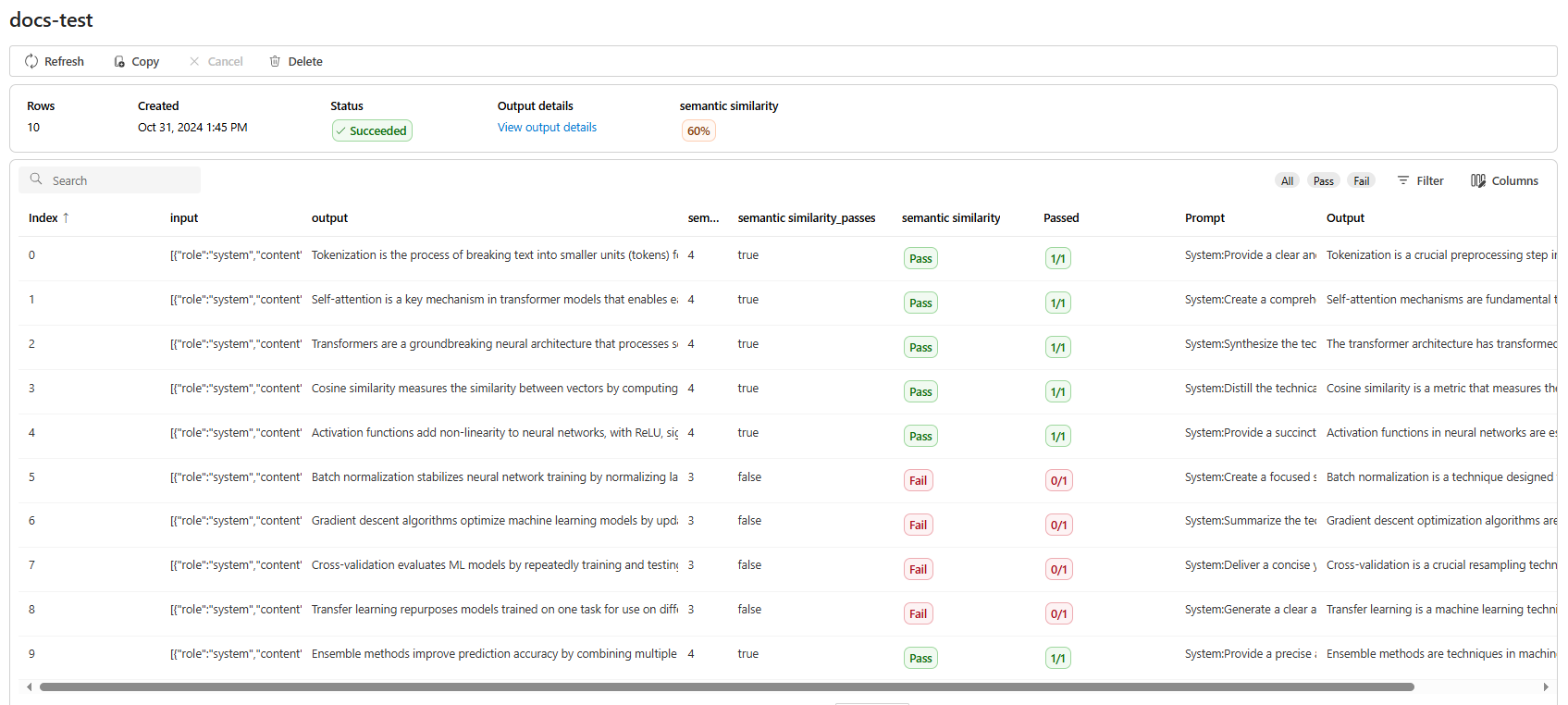

Po vytvoření zkušební úlohy můžete vybrat úlohu, abyste zobrazili úplné podrobnosti úlohy:

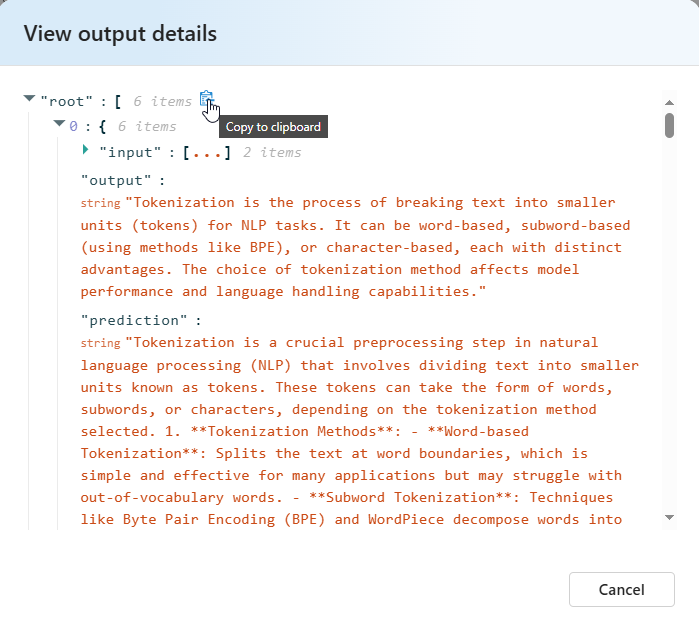

Pro sémantické podobnosti Zobrazení podrobností výstupu obsahuje reprezentaci JSON, kterou můžete zkopírovat nebo vložit úspěšné testy.

Podrobnosti o testech kritérií

Azure OpenAI Evaluation nabízí několik možností kritérií testování. V následující části najdete další podrobnosti o jednotlivých možnostech.

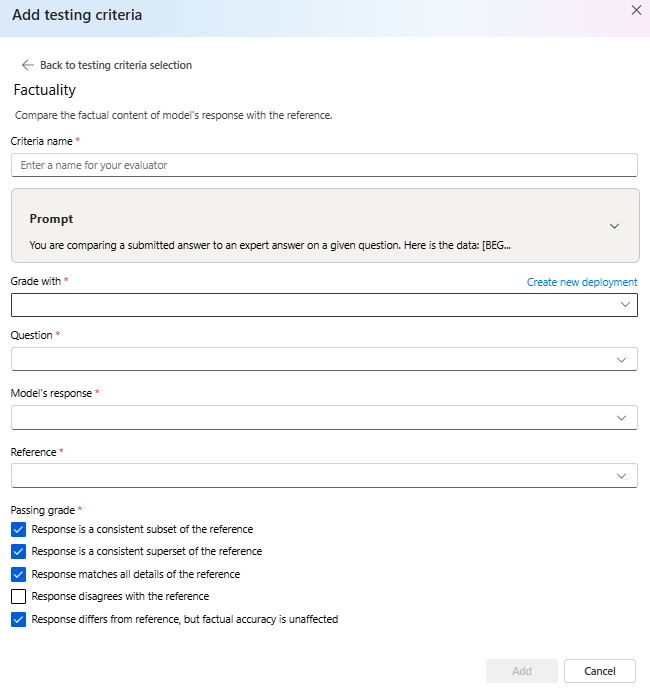

Faktičnost

Vyhodnocuje skutečnou přesnost odeslané odpovědi porovnáním s odbornou odpovědí.

Faktie vyhodnocuje faktickou přesnost odeslané odpovědi porovnáním s odbornou odpovědí. Při použití podrobné výzvy typu coT (CoT) určuje, zda je odeslaná odpověď konzistentní s podmnožinou, nadmnožinou nebo v konfliktu s odbornou odpovědí. Ignoruje rozdíly ve stylu, gramatikě nebo interpunkci, která se zaměřuje výhradně na faktický obsah. Faktická skutečnost může být užitečná v mnoha scénářích, mimo jiné i na ověřování obsahu a vzdělávací nástroje, které zajišťují přesnost odpovědí poskytovaných AI.

Text výzvy, který se používá jako součást tohoto testovacího kritéria, můžete zobrazit tak, že vyberete rozevírací seznam vedle výzvy. Aktuální text výzvy je:

Prompt

You are comparing a submitted answer to an expert answer on a given question.

Here is the data:

[BEGIN DATA]

************

[Question]: {input}

************

[Expert]: {ideal}

************

[Submission]: {completion}

************

[END DATA]

Compare the factual content of the submitted answer with the expert answer. Ignore any differences in style, grammar, or punctuation.

The submitted answer may either be a subset or superset of the expert answer, or it may conflict with it. Determine which case applies. Answer the question by selecting one of the following options:

(A) The submitted answer is a subset of the expert answer and is fully consistent with it.

(B) The submitted answer is a superset of the expert answer and is fully consistent with it.

(C) The submitted answer contains all the same details as the expert answer.

(D) There is a disagreement between the submitted answer and the expert answer.

(E) The answers differ, but these differences don't matter from the perspective of factuality.

Sémantická podobnost

Měří stupeň podobnosti mezi odezvou modelu a odkazem.

Grades: 1 (completely different) - 5 (very similar).

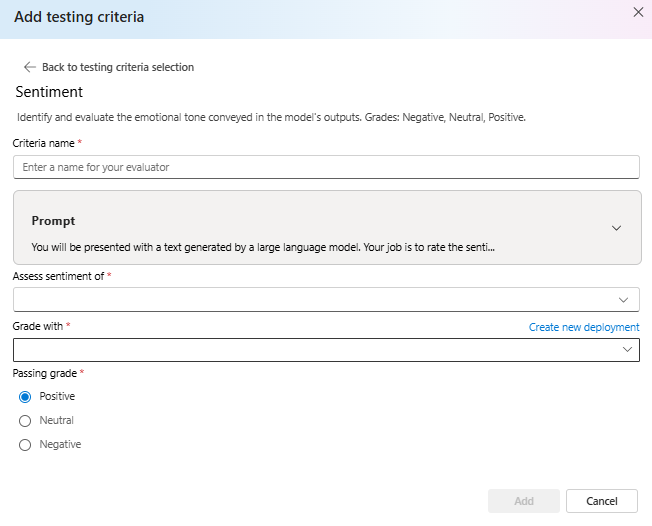

Smýšlení

Snaží se identifikovat emocionální tón výstupu.

Text výzvy, který se používá jako součást tohoto testovacího kritéria, můžete zobrazit tak, že vyberete rozevírací seznam vedle výzvy. Aktuální text výzvy je:

Prompt

You will be presented with a text generated by a large language model. Your job is to rate the sentiment of the text. Your options are:

A) Positive

B) Neutral

C) Negative

D) Unsure

[BEGIN TEXT]

***

[{text}]

***

[END TEXT]

First, write out in a step by step manner your reasoning about the answer to be sure that your conclusion is correct. Avoid simply stating the correct answers at the outset. Then print only the single character (without quotes or punctuation) on its own line corresponding to the correct answer. At the end, repeat just the letter again by itself on a new line

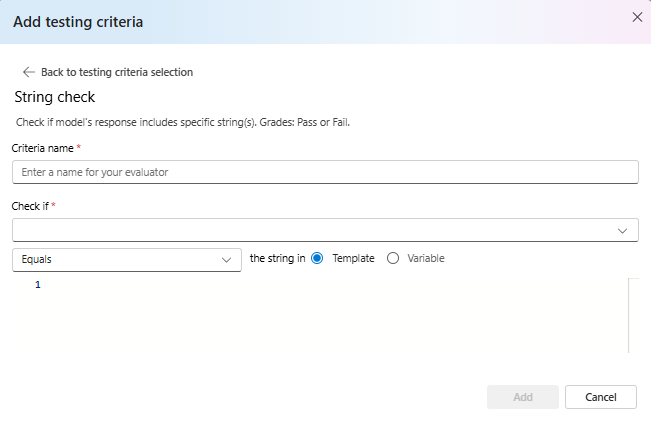

Kontrola řetězce

Ověří, jestli výstup přesně odpovídá očekávanému řetězci.

Kontrola řetězců provádí různé binární operace se dvěma řetězcovými proměnnými, což umožňuje různá kritéria vyhodnocení. Pomáhá s ověřením různých vztahů řetězců, včetně rovnosti, omezení a konkrétních vzorů. Tento vyhodnocovací nástroj umožňuje rozlišovat malá a velká písmena nebo malá a malá písmena. Poskytuje také zadané známky pro skutečné nebo nepravdivé výsledky, což umožňuje přizpůsobené výsledky vyhodnocení na základě výsledku porovnání. Tady je podporovaný typ operací:

-

equals: Zkontroluje, jestli se výstupní řetězec přesně rovná vyhodnocovacímu řetězci. -

contains: Zkontroluje, jestli je vyhodnocovací řetězec podřetězcem výstupního řetězce. -

starts-with: Zkontroluje, jestli výstupní řetězec začíná zkušebním řetězcem. -

ends-with: Zkontroluje, jestli výstupní řetězec končí zkušebním řetězcem.

Poznámka:

Při nastavování určitých parametrů v kritériích testování máte možnost zvolit mezi proměnnou a šablonou. Vyberte proměnnou , pokud chcete odkazovat na sloupec ve vstupních datech. Pokud chcete zadat pevný řetězec, zvolte šablonu .

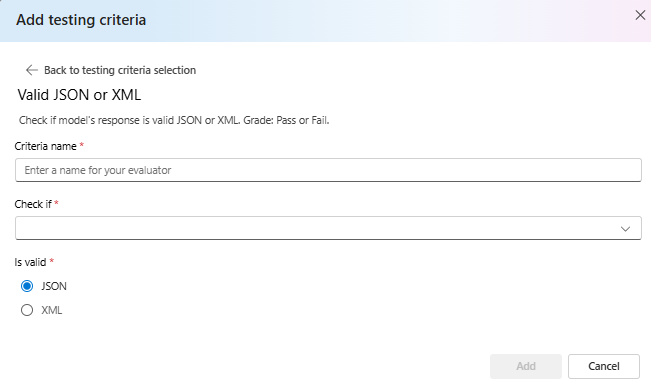

Platný kód JSON nebo XML

Ověří, jestli je výstup platný ve formátu JSON nebo XML.

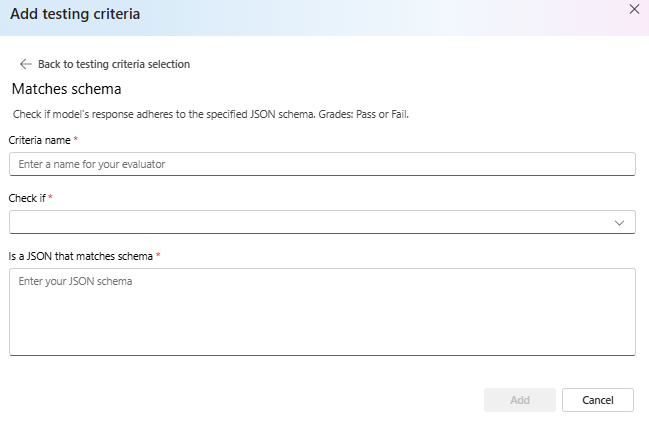

Odpovídá schématu

Zajišťuje, že výstup se řídí zadanou strukturou.

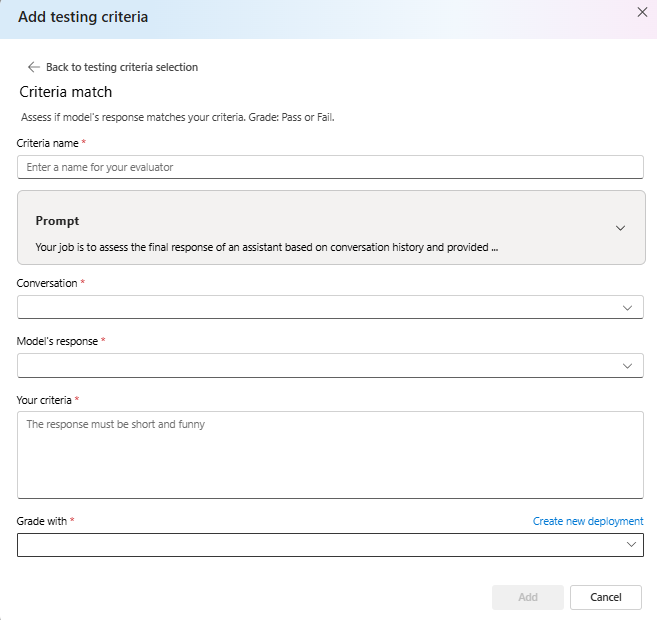

Shoda kritérií

Vyhodnoťte, jestli odpověď modelu odpovídá vašim kritériím. Grade: Pass or Fail.

Text výzvy, který se používá jako součást tohoto testovacího kritéria, můžete zobrazit tak, že vyberete rozevírací seznam vedle výzvy. Aktuální text výzvy je:

Prompt

Your job is to assess the final response of an assistant based on conversation history and provided criteria for what makes a good response from the assistant. Here is the data:

[BEGIN DATA]

***

[Conversation]: {conversation}

***

[Response]: {response}

***

[Criteria]: {criteria}

***

[END DATA]

Does the response meet the criteria? First, write out in a step by step manner your reasoning about the criteria to be sure that your conclusion is correct. Avoid simply stating the correct answers at the outset. Then print only the single character "Y" or "N" (without quotes or punctuation) on its own line corresponding to the correct answer. "Y" for yes if the response meets the criteria, and "N" for no if it does not. At the end, repeat just the letter again by itself on a new line.

Reasoning:

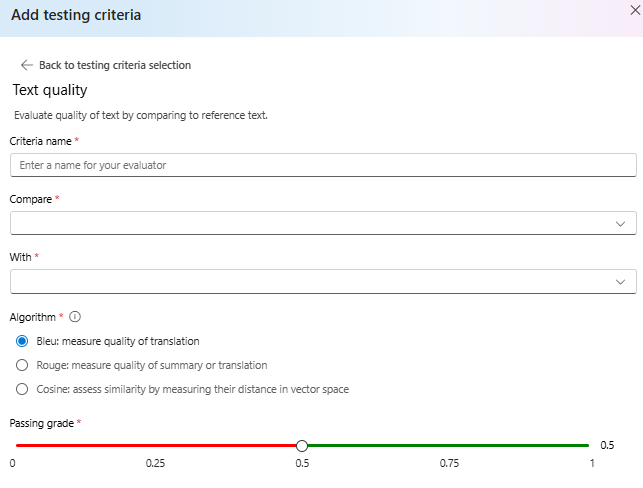

Kvalita textu

Vyhodnoťte kvalitu textu porovnáním s odkazem na text.

Souhrn:

- Skóre BLEU: Vyhodnotí kvalitu generovaného textu porovnáním s jedním nebo více vysoce kvalitními referenčními překlady pomocí skóre BLEU.

- ROUGE Score: Vyhodnocuje kvalitu generovaného textu tak, že ji porovná s referenčními souhrny pomocí skóre ROUGE.

- Kosinus: Označuje se také jako kosinus podobnosti, jak přesně dva vložené texty ( například výstupy modelu a referenční texty) odpovídají významu, což pomáhá vyhodnotit sémantickou podobnost mezi nimi. To se provádí měřením jejich vzdálenosti ve vektorovém prostoru.

Podrobnosti:

Skóre BLEU (BiLingual Evaluation Understudy) se běžně používá ve zpracování přirozeného jazyka (NLP) a strojovém překladu. Běžně se používá v případech použití sumarizace textu a generování textu. Vyhodnotí, jak přesně vygenerovaný text odpovídá referenčnímu textu. Skóre BLEU se pohybuje od 0 do 1 a vyšší skóre označující lepší kvalitu.

ROUGE (rekapacitně orientované podstudií pro vyhodnocení Gistingu) je sada metrik, které slouží k vyhodnocení automatického shrnutí a strojového překladu. Měří překrývání mezi vygenerovaným textem a souhrny odkazů. ROUGE se zaměřuje na míry orientované na úplnost, aby posoudily, jak dobře vygenerovaný text pokrývá referenční text. Skóre ROUGE poskytuje různé metriky, mezi které patří: • ROUGE-1: Překrývání unigramů (jednoslovek) mezi vygenerovaným a referenčním textem. • ROUGE-2: Překrývající se bigramy (dvě po sobě jdoucí slova) mezi vygenerovaným a referenčním textem. • ROUGE-3: Překrývající se trigramy (tři po sobě jdoucí slova) mezi vygenerovaným a referenčním textem. • ROUGE-4: Překrytí čtyř gramů (čtyři po sobě jdoucí slova) mezi vygenerovaným a referenčním textem. • ROUGE-5: Překrytí pěti gramů (pět po sobě jdoucích slov) mezi vygenerovaným a referenčním textem. • ROUGE-L: Překrývání L-gramů (L po sobě jdoucích slov) mezi vygenerovaným a referenčním textem. Shrnutí textu a porovnání dokumentů patří mezi optimální případy použití PRO ROUGE, zejména ve scénářích, kdy je zásadní soudržnost textu a význam.

Kosinus podobnost měří, jak přesně dva vložené texty ( například výstupy modelu a referenční texty) odpovídají významu, což pomáhá vyhodnotit sémantickou podobnost mezi nimi. Stejně jako u ostatních vyhodnocovačů založených na modelu je potřeba k vyhodnocení poskytnout nasazení modelu.

Důležité

U tohoto vyhodnocovače se podporují jenom vložené modely:

text-embedding-3-smalltext-embedding-3-largetext-embedding-ada-002

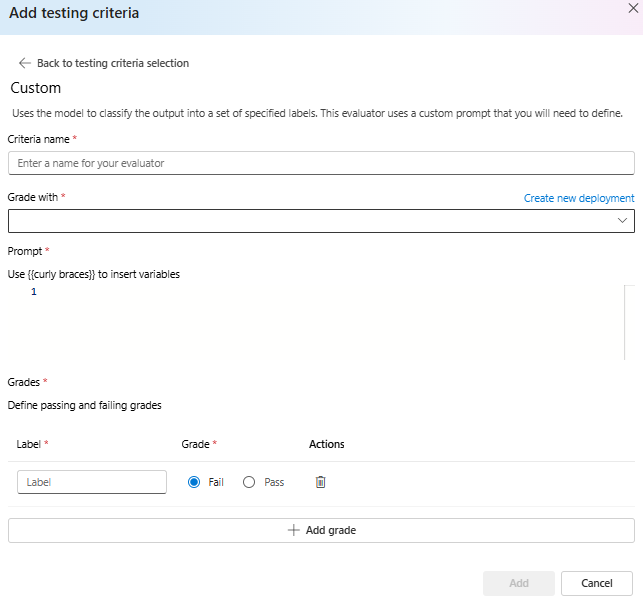

Vlastní výzva

Pomocí modelu klasifikuje výstup do sady zadaných popisků. Tento vyhodnocovací nástroj používá vlastní výzvu, kterou budete muset definovat.